From 29aa5c2e23d4eaf0f8dee0754e885ac6521f43f1 Mon Sep 17 00:00:00 2001

From: Zzm0809 <934230207@qq.com>

Date: Wed, 5 Jun 2024 15:26:42 +0800

Subject: [PATCH] [Doc] Document version archive 1.0 (#3560)

Signed-off-by: Zzm0809 <934230207@qq.com>

---

docs/docs/developer_guide/local_debug.md | 7 +-

docs/docusaurus.config.js | 18 +-

.../current.json | 6 +-

.../version-1.0.json | 118 ++++++

.../en/docusaurus-theme-classic/footer.json | 4 +-

.../current.json | 6 +-

.../version-1.0.json | 118 ++++++

.../zh/docusaurus-theme-classic/footer.json | 4 +-

.../versioned_docs/version-1.0/comminicate.md | 19 +

.../version-1.0/deploy_guide/_category_.json | 4 +

.../deploy_guide/compile_deploy.md | 127 ++++++

.../version-1.0/deploy_guide/docker_deploy.md | 131 ++++++

.../deploy_guide/kubernetes_deploy.md | 363 +++++++++++++++++

.../deploy_guide/normal_deploy.mdx | 258 ++++++++++++

.../deploy_guide/upgrade/_category_.json | 4 +

.../deploy_guide/upgrade/upgrade_075to100.md | 52 +++

.../deploy_guide/upgrade/upgrade_overview.md | 18 +

.../developer_guide/_category_.json | 4 +

.../contribution/_category_.json | 4 +

.../developer_guide/contribution/auto_sync.md | 19 +

.../contribution/code_format.md | 66 +++

.../contribution/commit_code.md | 86 ++++

.../contribution/commit_message.md | 97 +++++

.../developer_guide/contribution/document.md | 52 +++

.../contribution/how_contribute.md | 59 +++

.../developer_guide/contribution/issue.md | 152 +++++++

.../contribution/pull_request.md | 55 +++

.../developer_guide/local_debug.md | 220 ++++++++++

.../version-1.0/extend/_category_.json | 4 +

.../extend/expand_statements/_category_.json | 4 +

.../expand_statements/add_file_statement.md | 59 +++

.../expand_statements/add_jar_statement.md | 50 +++

.../expand_statements/aggtable_statement.md | 66 +++

.../create_temporal_function.md | 34 ++

.../extend/expand_statements/execute_jar.md | 60 +++

.../expand_statements/flinkcdc_pipeline.md | 57 +++

.../extend/expand_statements/print_table.md | 45 +++

.../expand_statements/variable_statement.md | 78 ++++

.../extend/function_expansion/_category_.json | 4 +

.../function_expansion/global_var_ext.md | 43 ++

docs/versioned_docs/version-1.0/faq.md | 240 +++++++++++

.../version-1.0/get_started/_category_.json | 4 +

.../version-1.0/get_started/overview.md | 35 ++

.../get_started/quick_experience.md | 130 ++++++

.../version-1.0/openapi/CancelFlinkJob.md | 80 ++++

.../version-1.0/openapi/ExplainSql.md | 177 ++++++++

.../version-1.0/openapi/ExportSql.md | 78 ++++

.../version-1.0/openapi/GetJobInstance.md | 96 +++++

.../openapi/GetJobInstanceByTaskId.md | 96 +++++

.../version-1.0/openapi/GetJobPlan.md | 202 ++++++++++

.../version-1.0/openapi/GetStreamGraph.md | 201 ++++++++++

.../version-1.0/openapi/GetTaskLineage.md | 76 ++++

.../version-1.0/openapi/RestartTask.md | 190 +++++++++

.../version-1.0/openapi/SavepointTrigger.md | 113 ++++++

.../version-1.0/openapi/SubmitTaskById.md | 194 +++++++++

.../version-1.0/openapi/SubmitTaskJob.md | 196 +++++++++

.../version-1.0/openapi/_category_.json | 4 +

.../version-1.0/openapi/openapi_overview.md | 379 ++++++++++++++++++

.../Integration_practice/_category_.json | 4 +

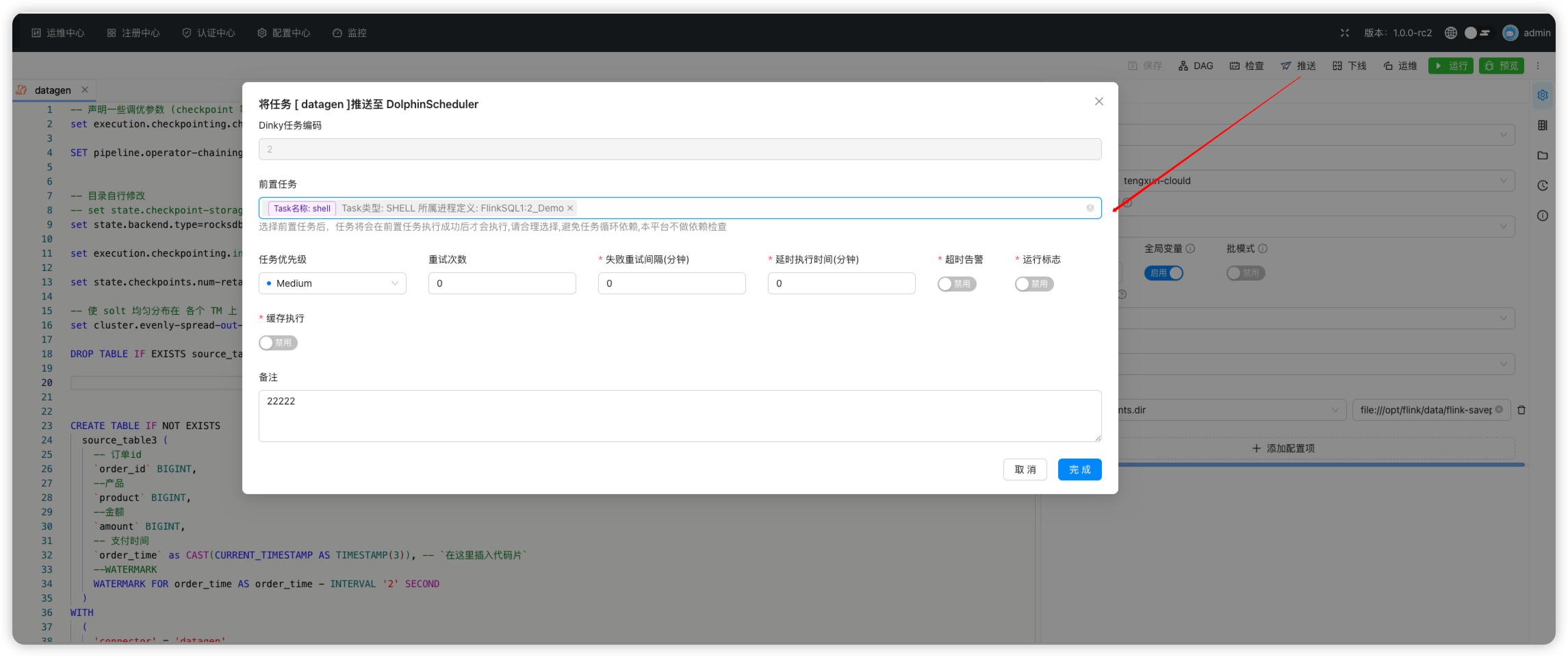

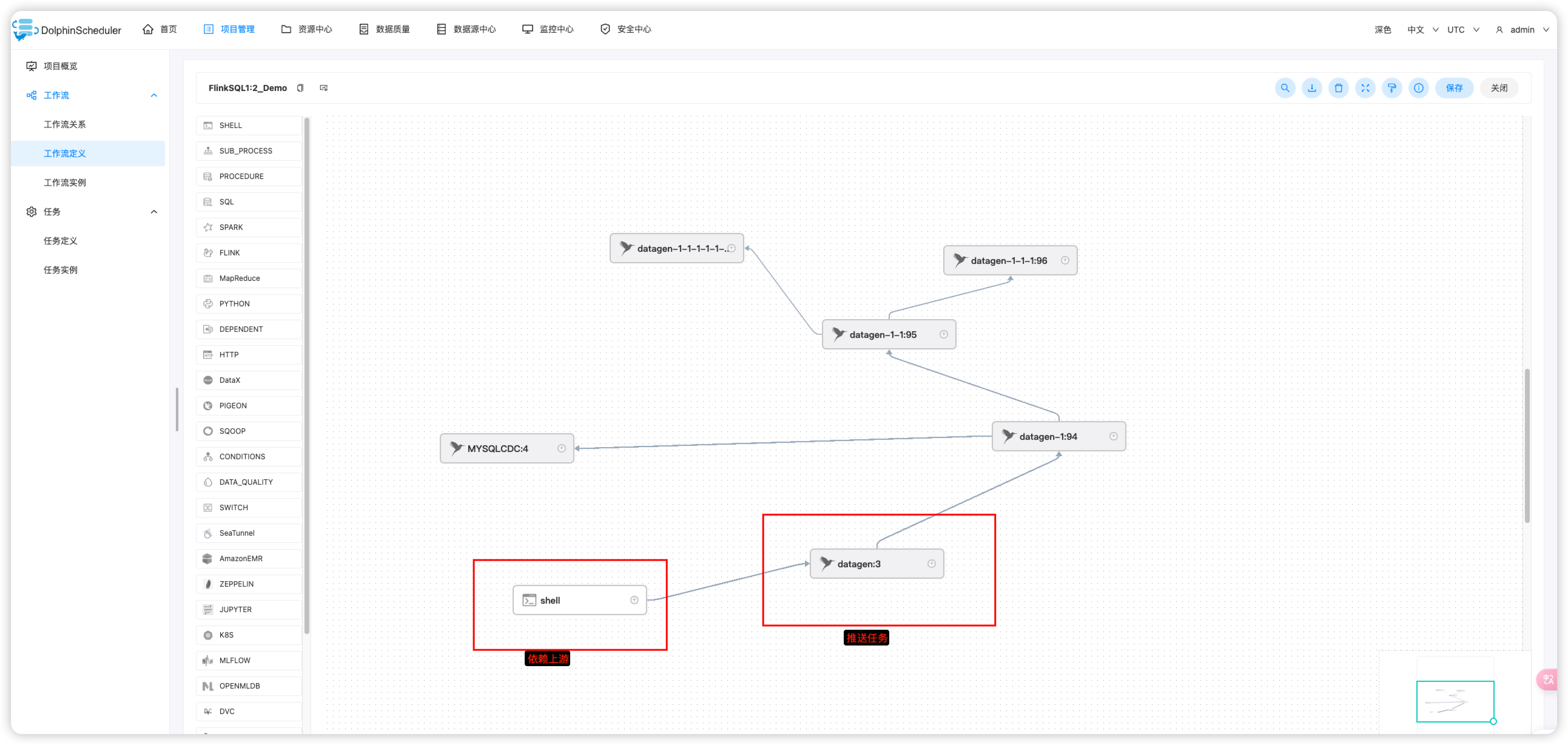

.../dinky_integration_ds.md | 156 +++++++

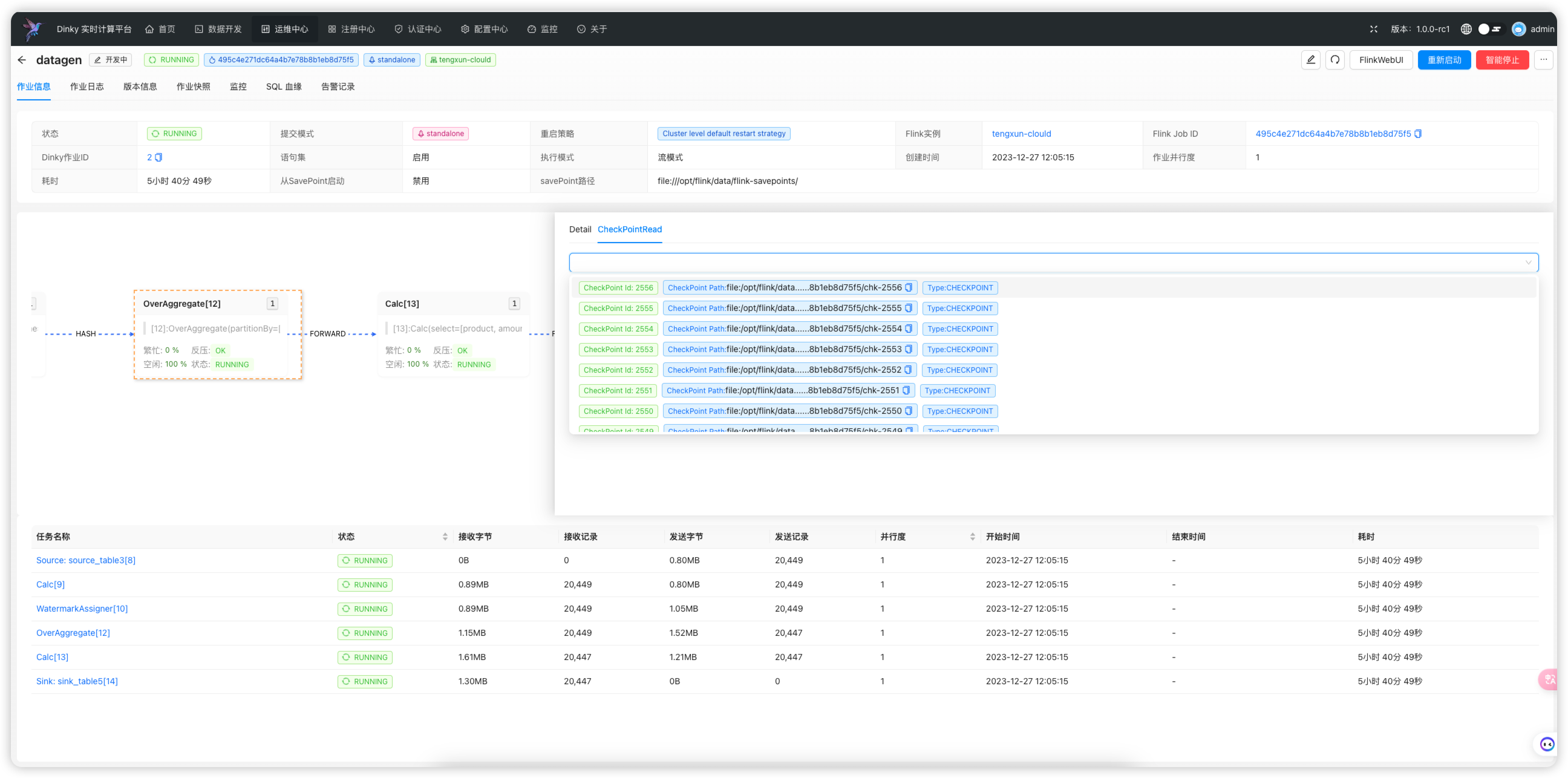

.../dinky_integration_flink.md | 276 +++++++++++++

.../practical_guide/_category_.json | 4 +

.../cdcsource_practice/_category_.json | 4 +

.../cdcsource_practice/cdcsource_faq.md | 55 +++

.../cdcsource_mysqlcdc2ck.md | 50 +++

.../cdcsource_mysqlcdc2dinkycatalog.md | 31 ++

.../cdcsource_mysqlcdc2doris.md | 82 ++++

.../cdcsource_mysqlcdc2hivecatalog.md | 31 ++

.../cdcsource_mysqlcdc2hudi.md | 71 ++++

.../cdcsource_mysqlcdc2kafka.md | 88 ++++

.../cdcsource_mysqlcdc2multiplesink.md | 54 +++

.../cdcsource_mysqlcdc2mysql.md | 80 ++++

.../cdcsource_mysqlcdc2oracle.md | 45 +++

.../cdcsource_mysqlcdc2paimon.md | 63 +++

.../cdcsource_mysqlcdc2pg.md | 47 +++

.../cdcsource_mysqlcdc2print.md | 32 ++

.../cdcsource_mysqlcdc2starrocks.md | 51 +++

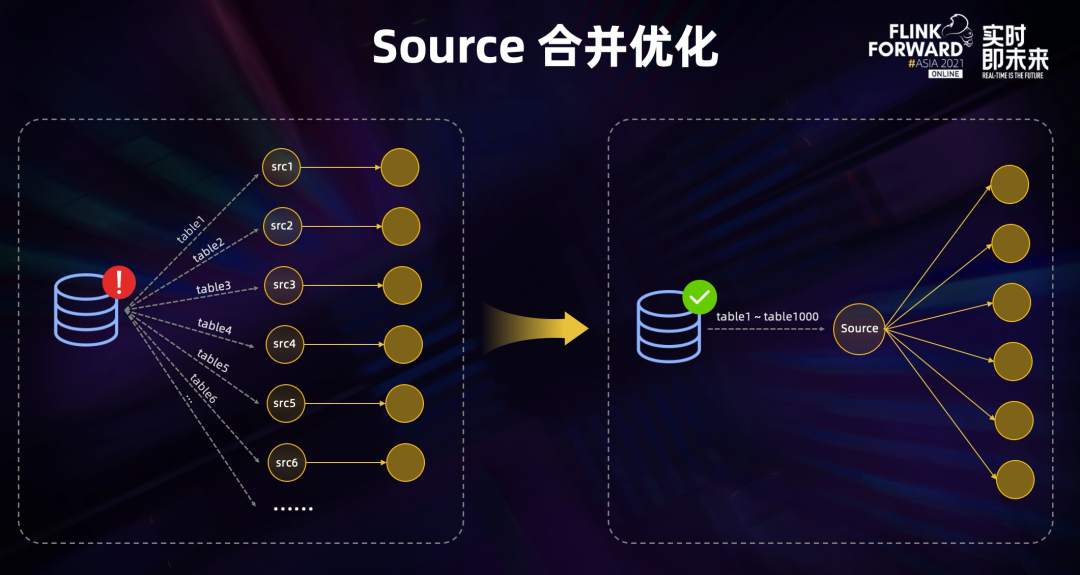

.../cdcsource_practice/cdcsource_overview.md | 151 +++++++

.../run_mode_practice/_category_.json | 4 +

.../application_model_submit.md | 53 +++

.../dinky_k8s_quick_start.mdx | 199 +++++++++

.../k8s_native_model_submit.md | 8 +

.../k8s_operater_model_submit.md | 8 +

.../k8s_session_model_submit.md | 8 +

.../run_mode_practice/local_model_submit.md | 8 +

.../run_mode_practice/projob_model_submit.md | 8 +

.../standalone_model_submit.md | 8 +

.../yarnsession_model_submit.md | 8 +

.../scenario_practice/_category_.json | 4 +

.../scenario_practice/mysqlcdc2doris.md | 8 +

.../scenario_practice/mysqlcdc2hudi.md | 7 +

.../scenario_practice/mysqlcdc2paimon.md | 7 +

.../scenario_practice/mysqlcdc2starrocks.md | 7 +

docs/versioned_docs/version-1.0/roadmap.md | 22 +

docs/versioned_docs/version-1.0/thanks.md | 58 +++

.../version-1.0/user_guide/_category_.json | 4 +

.../user_guide/auth_center/_category_.json | 4 +

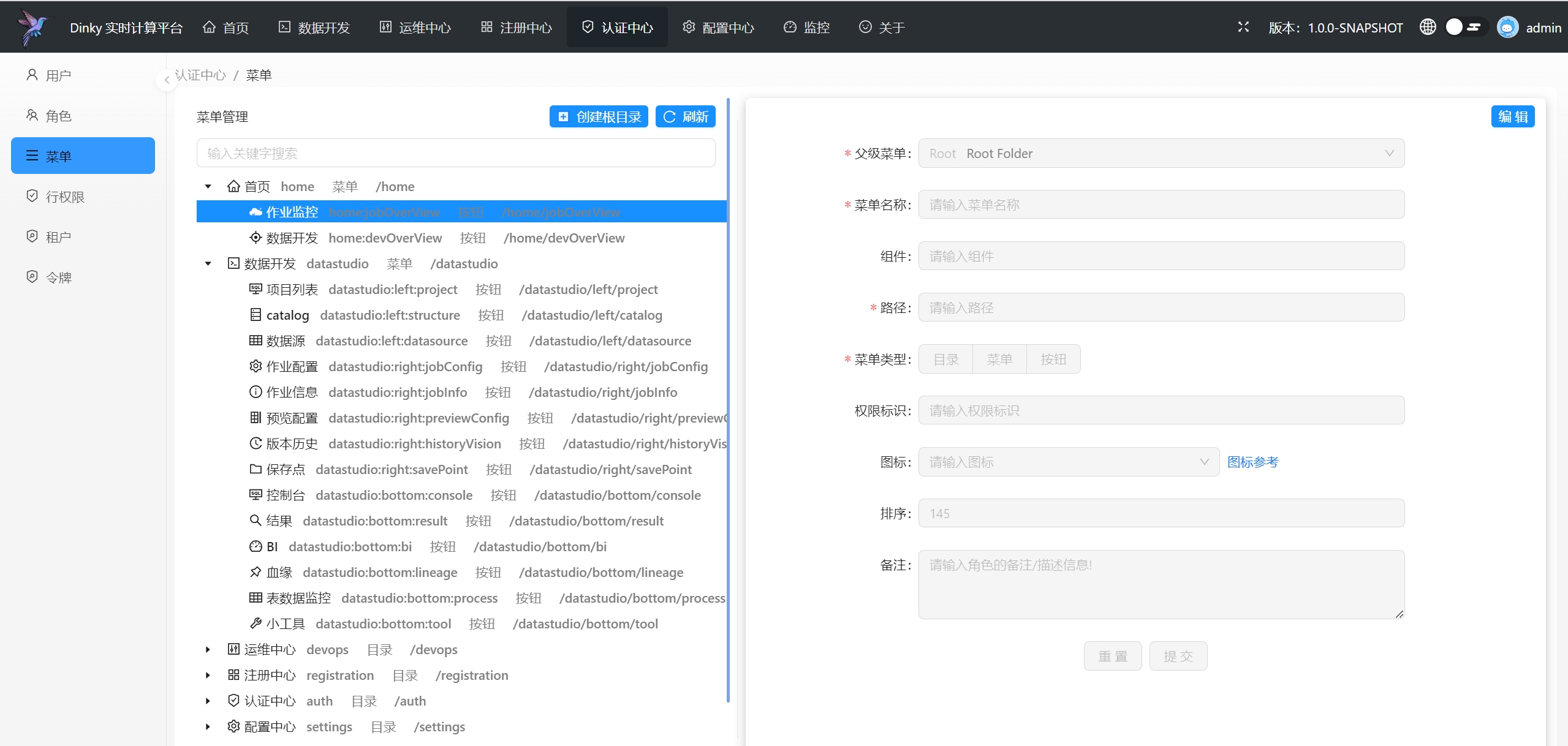

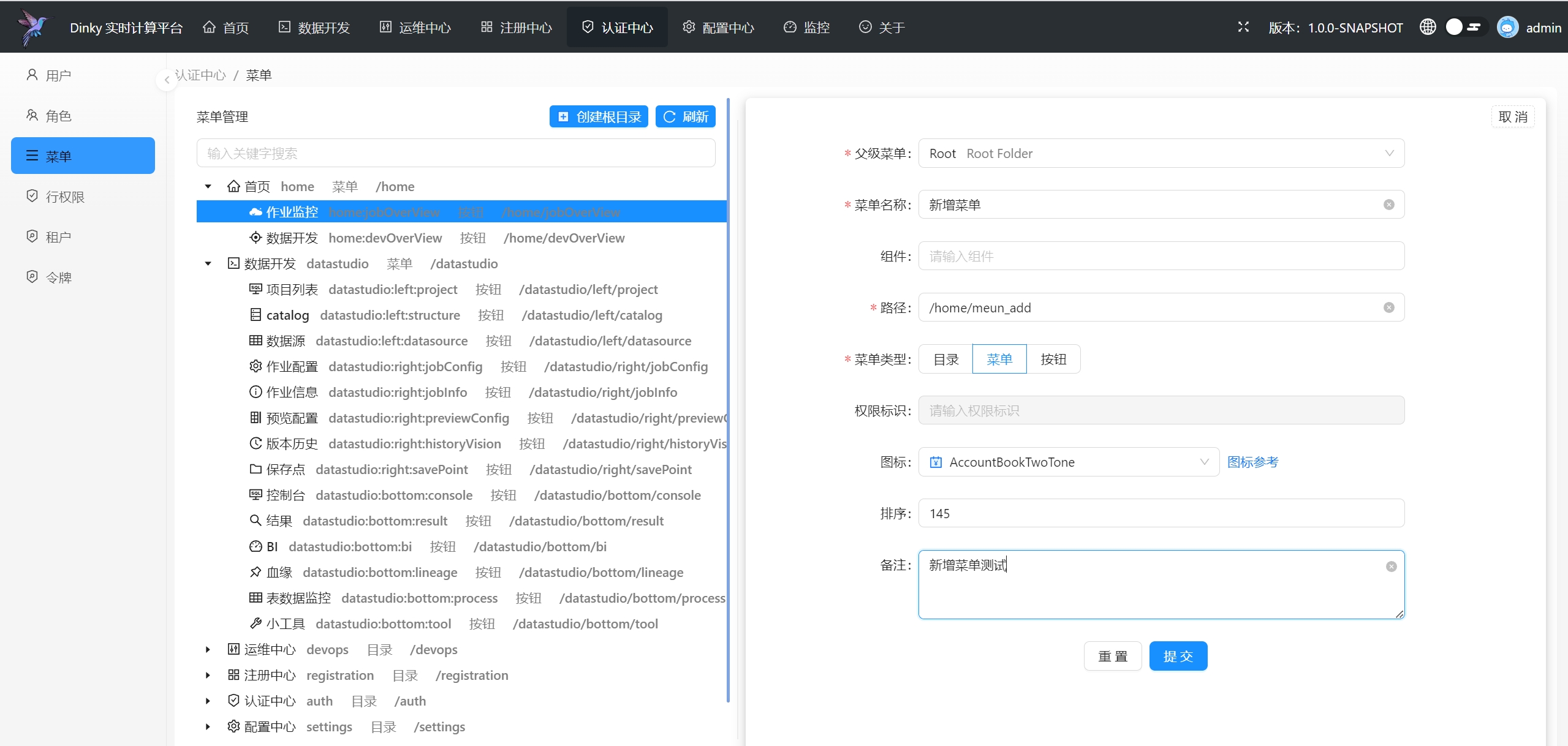

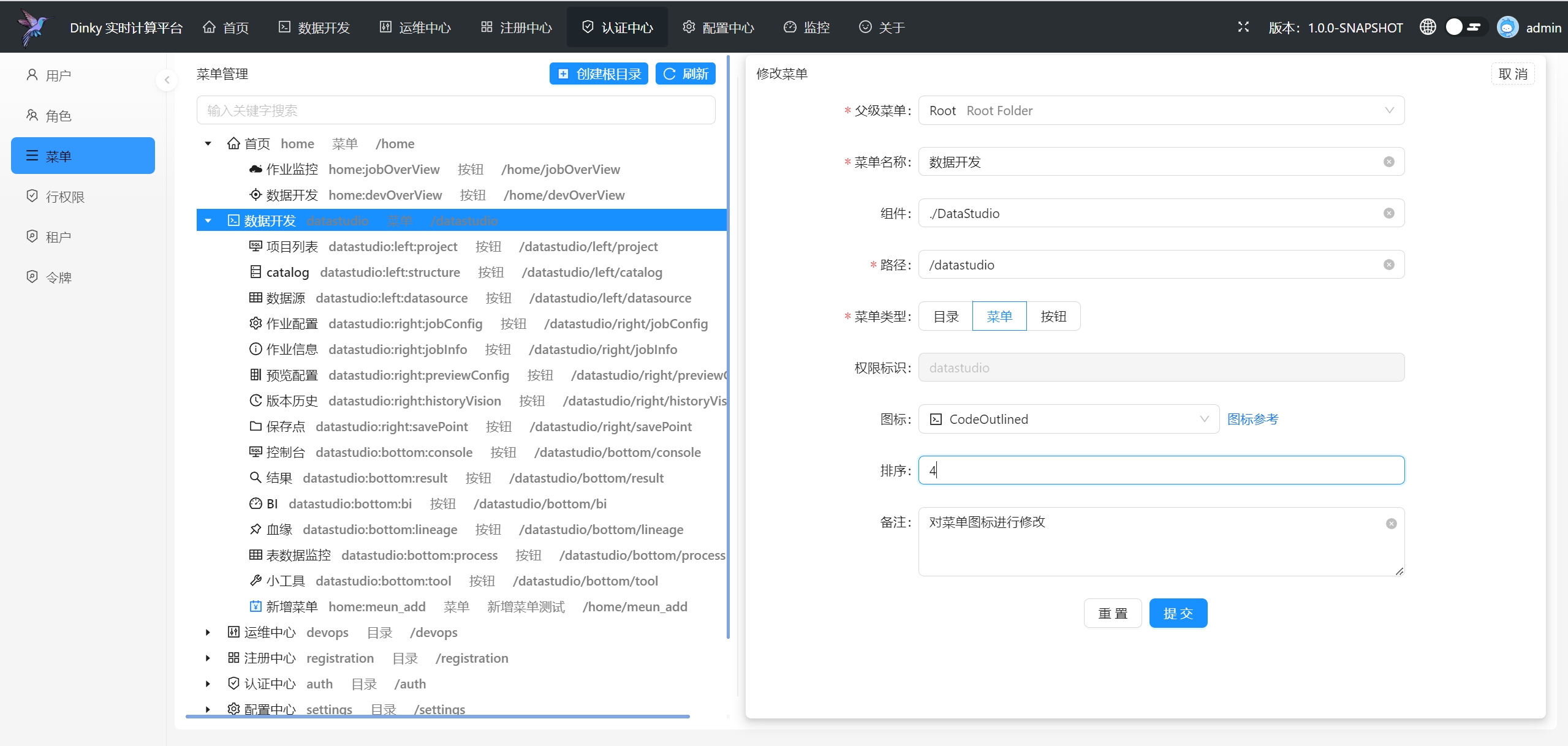

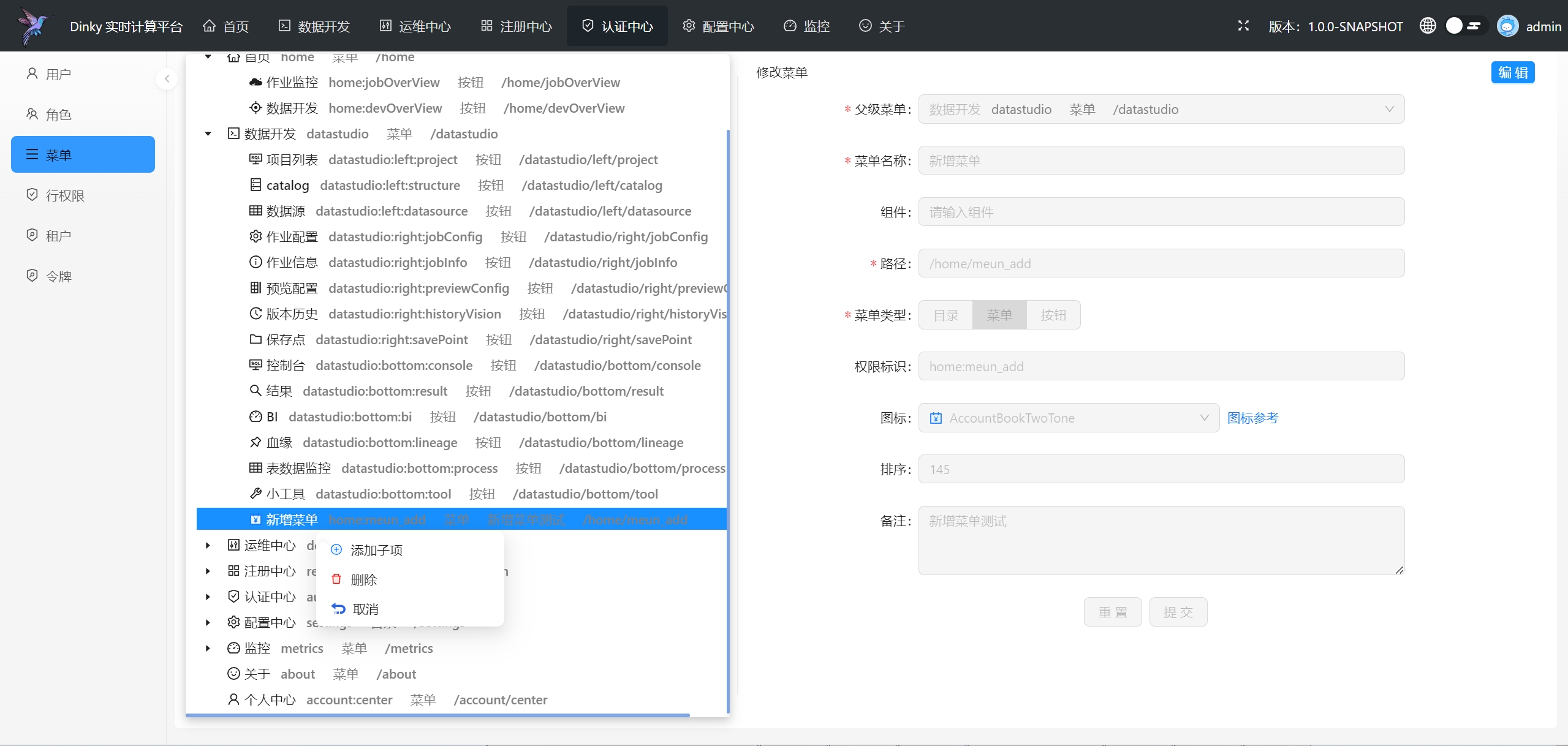

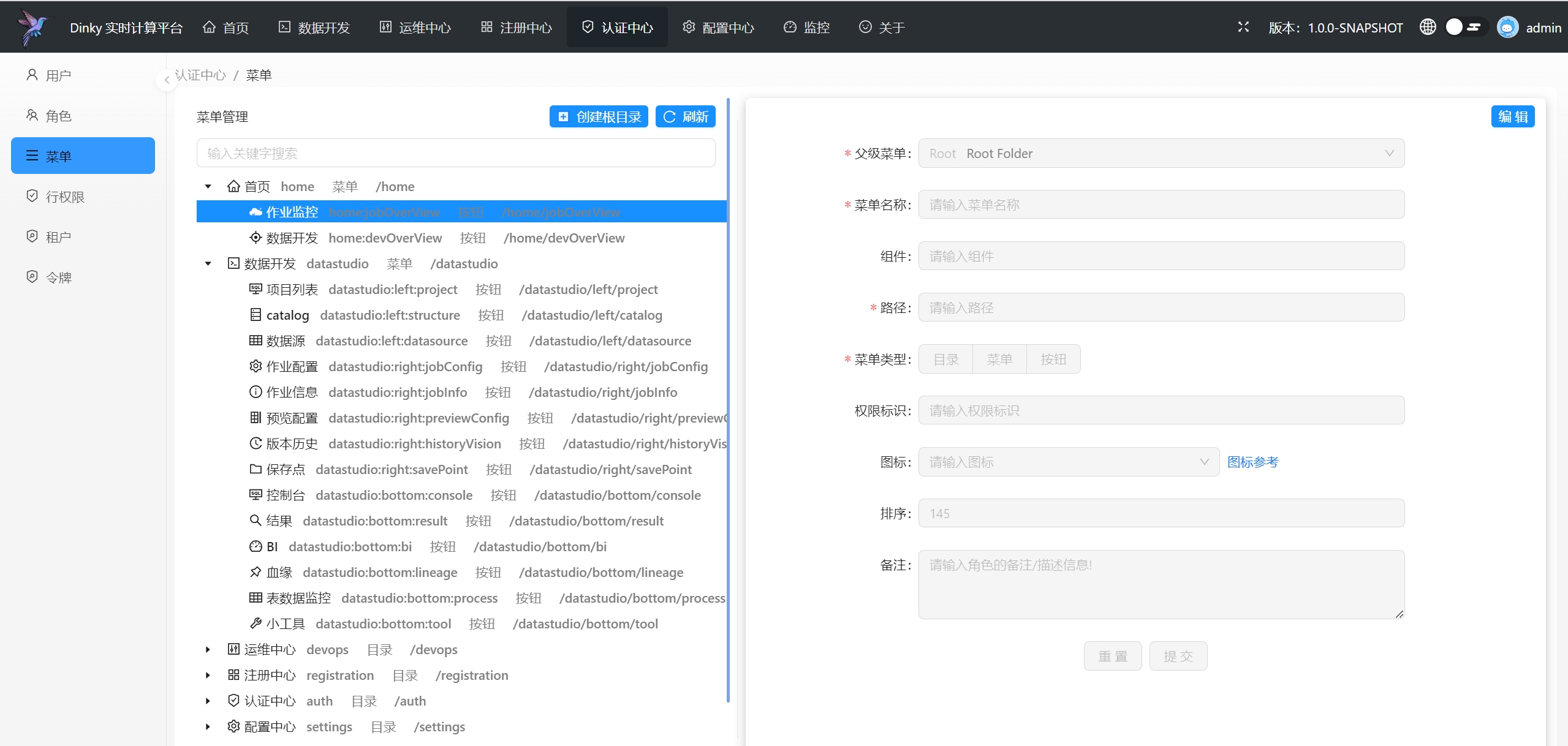

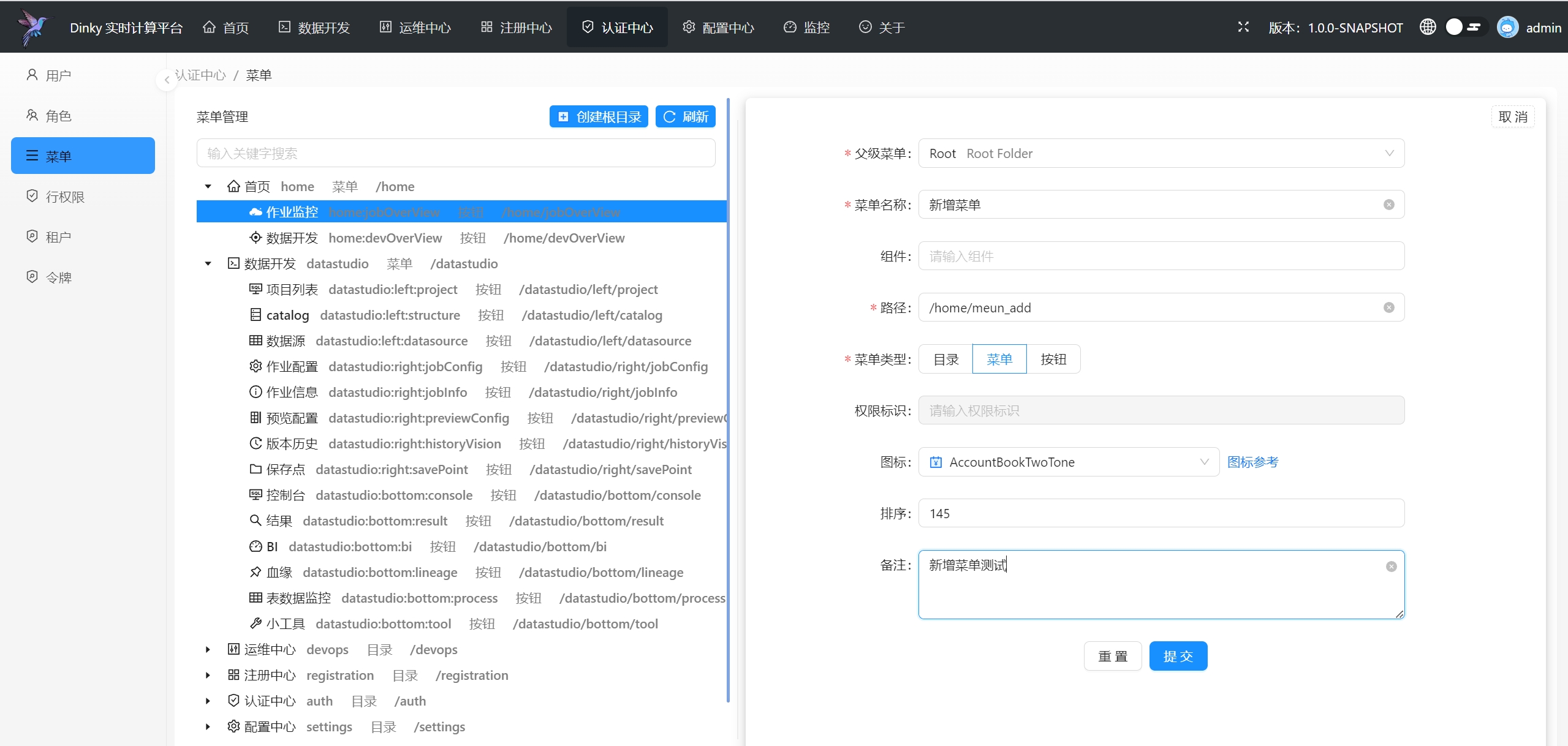

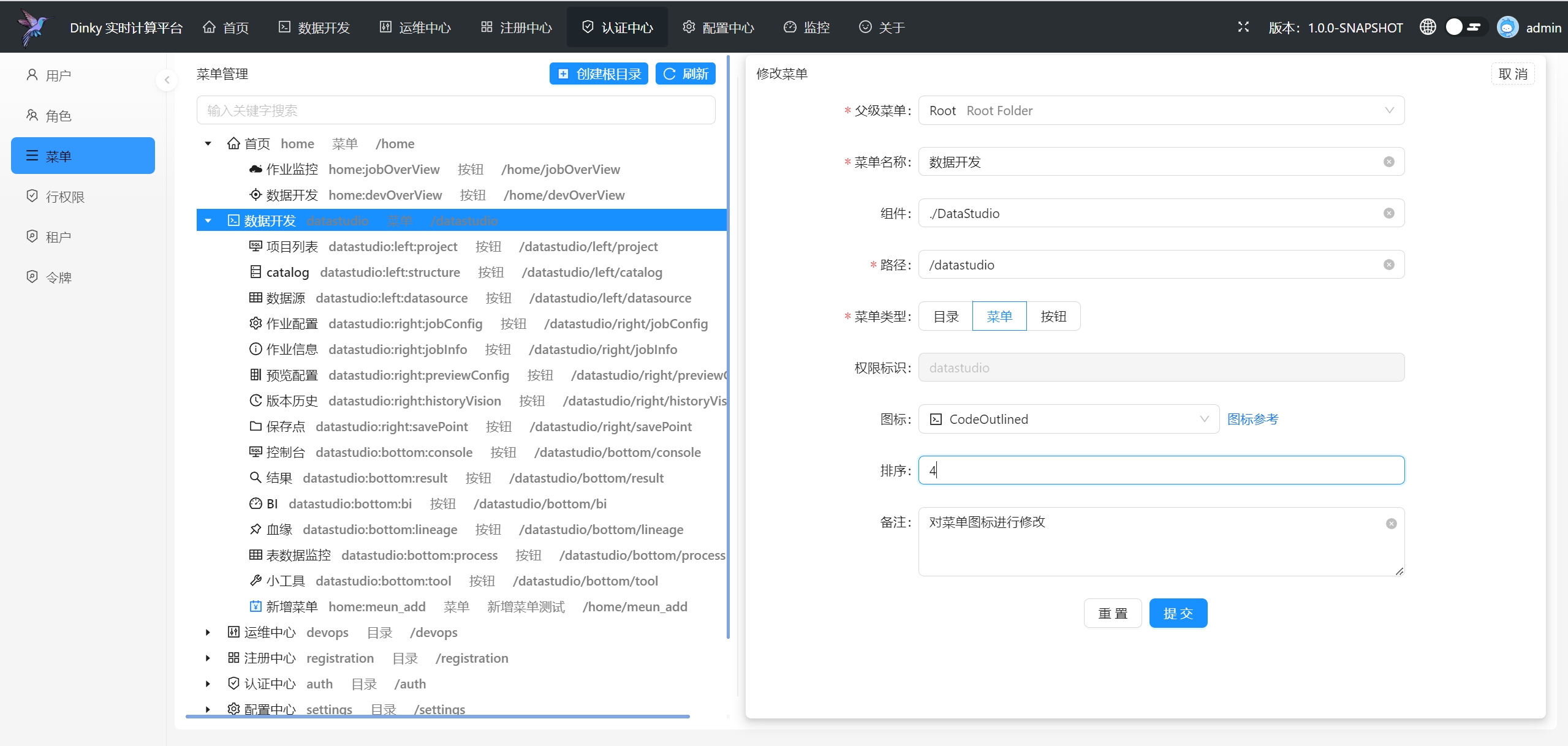

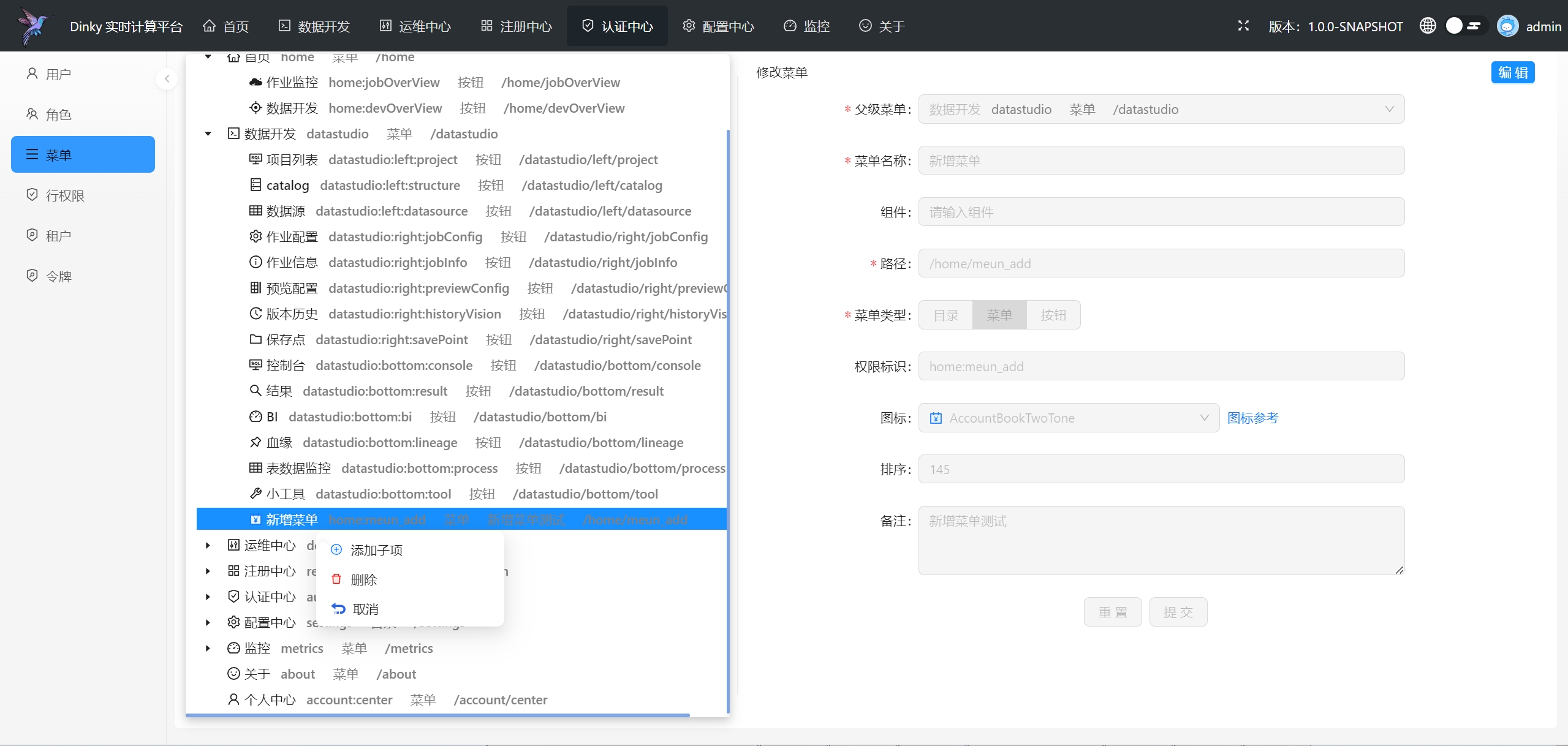

.../user_guide/auth_center/menu.md | 43 ++

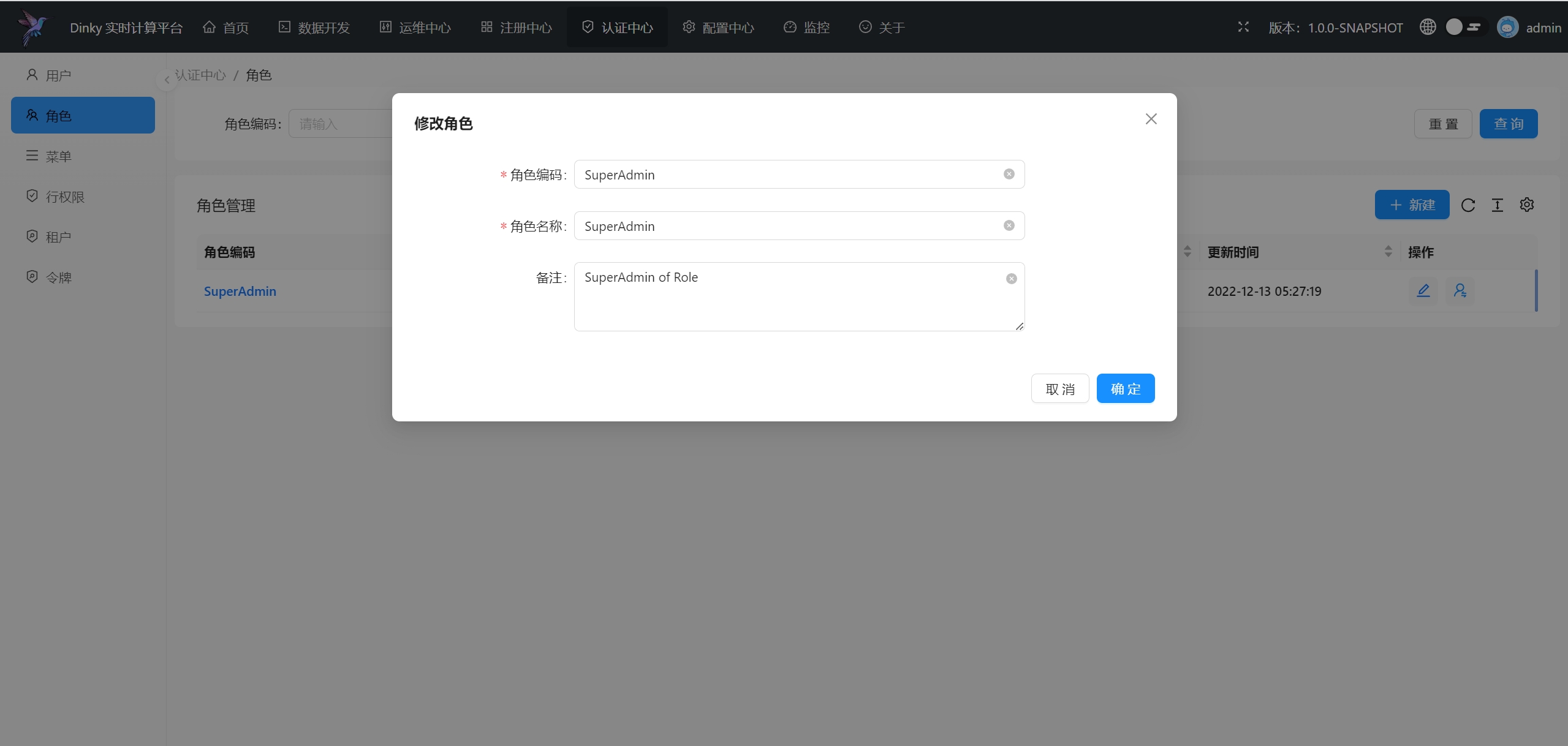

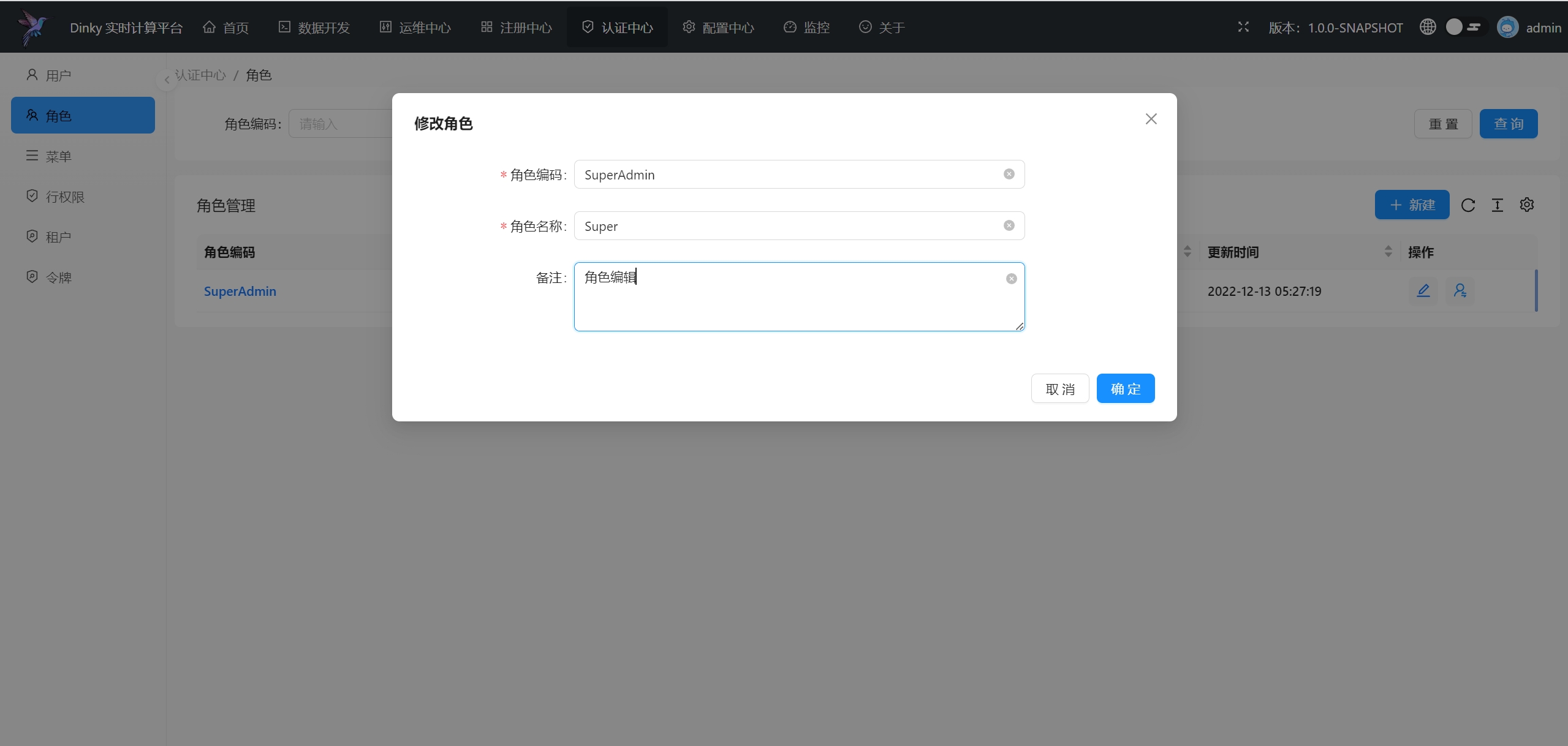

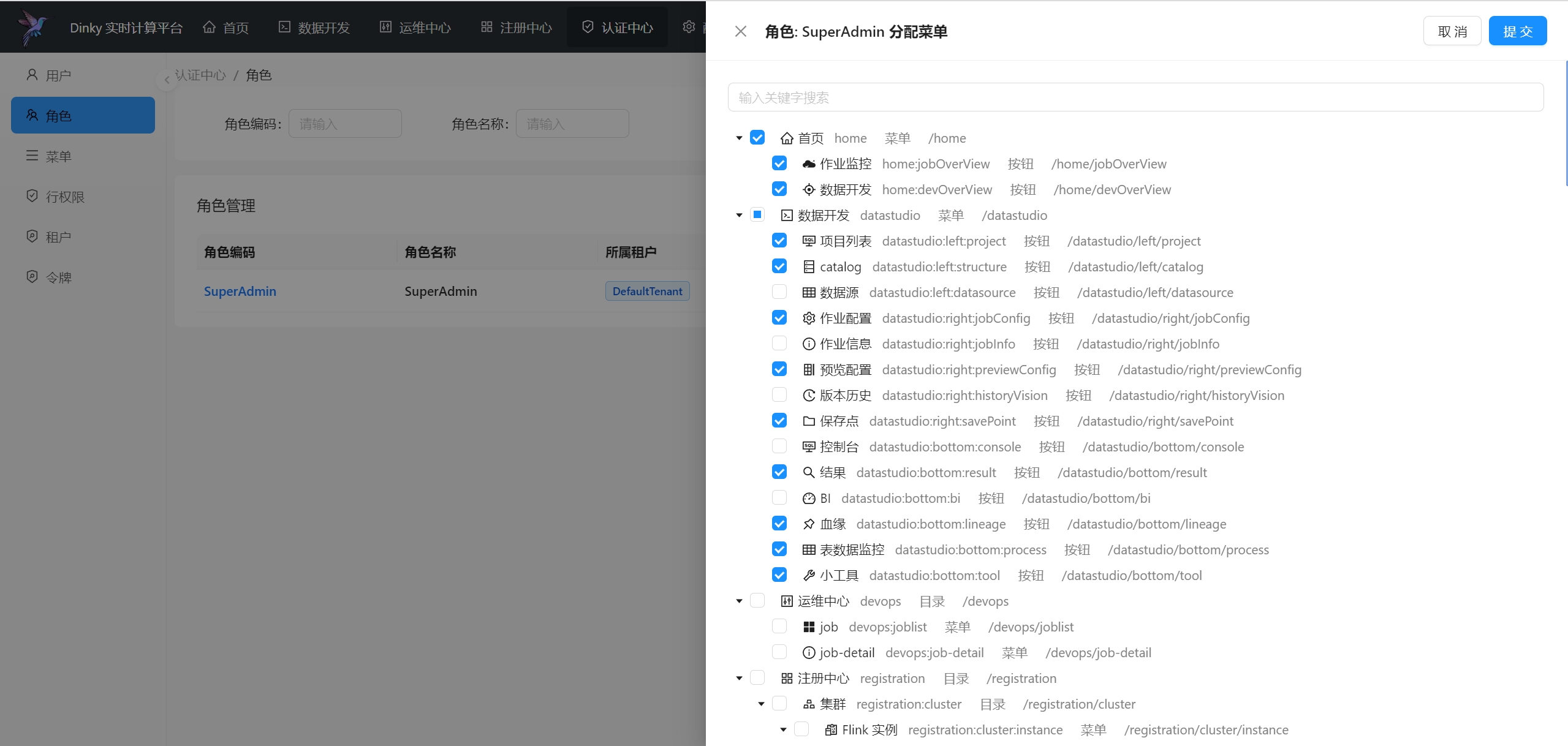

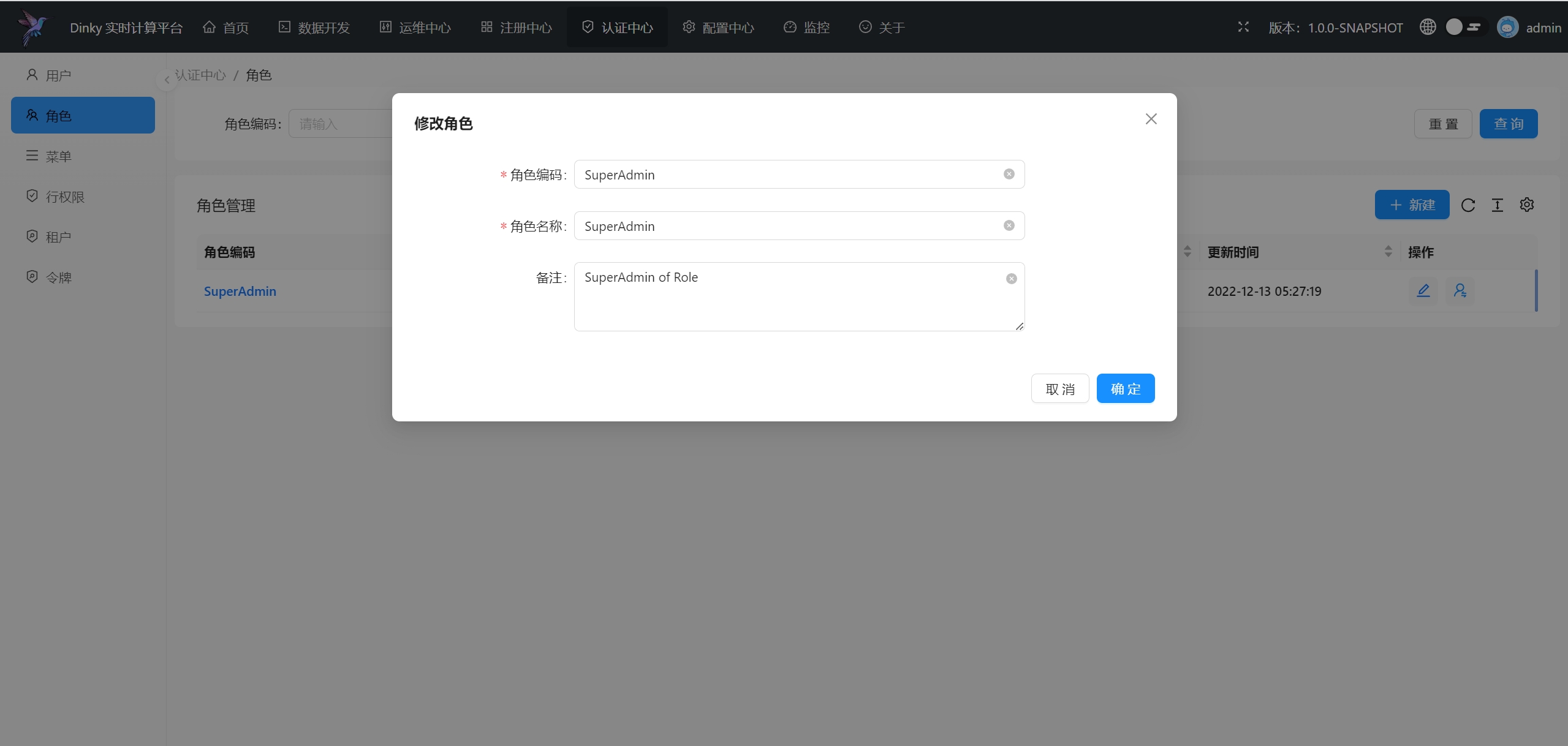

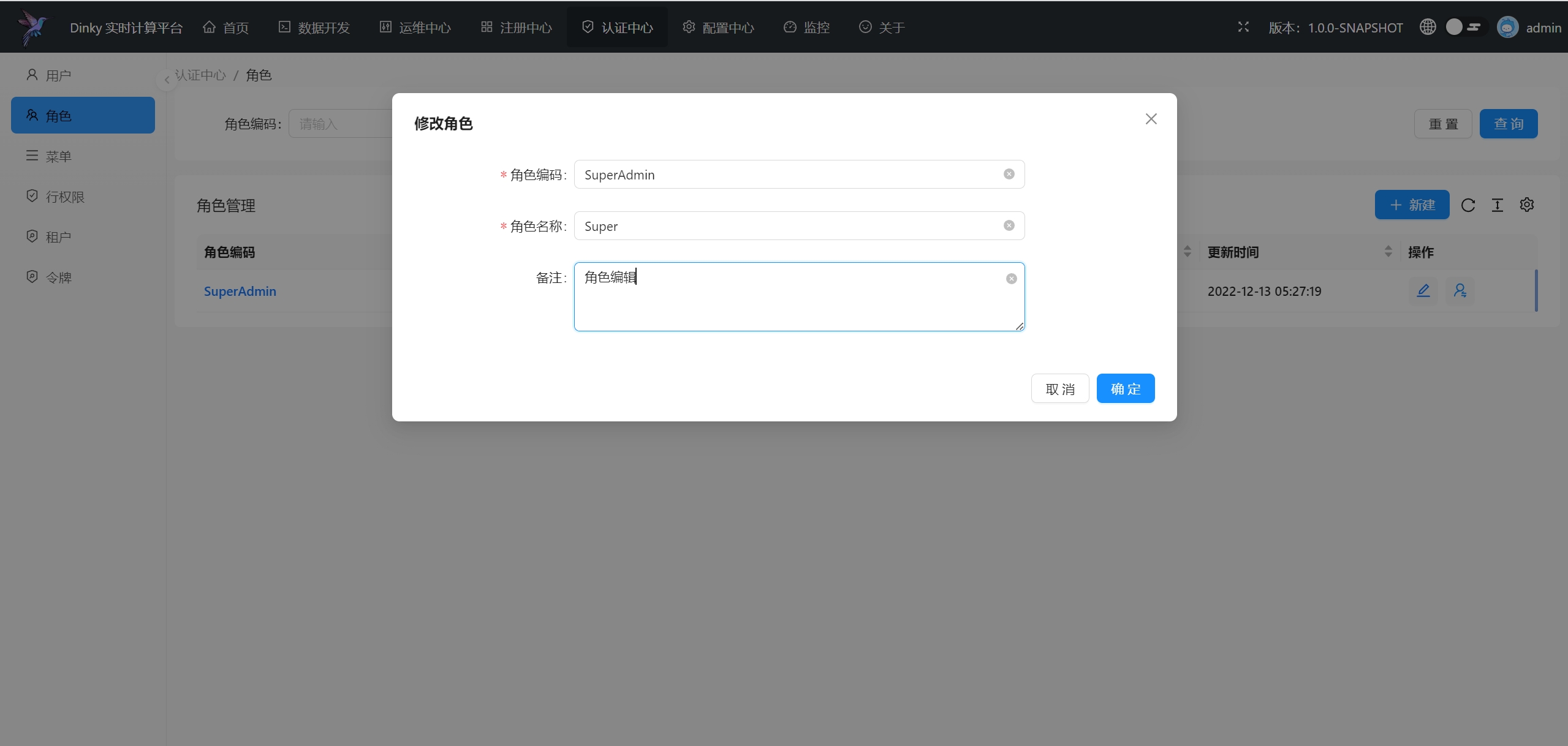

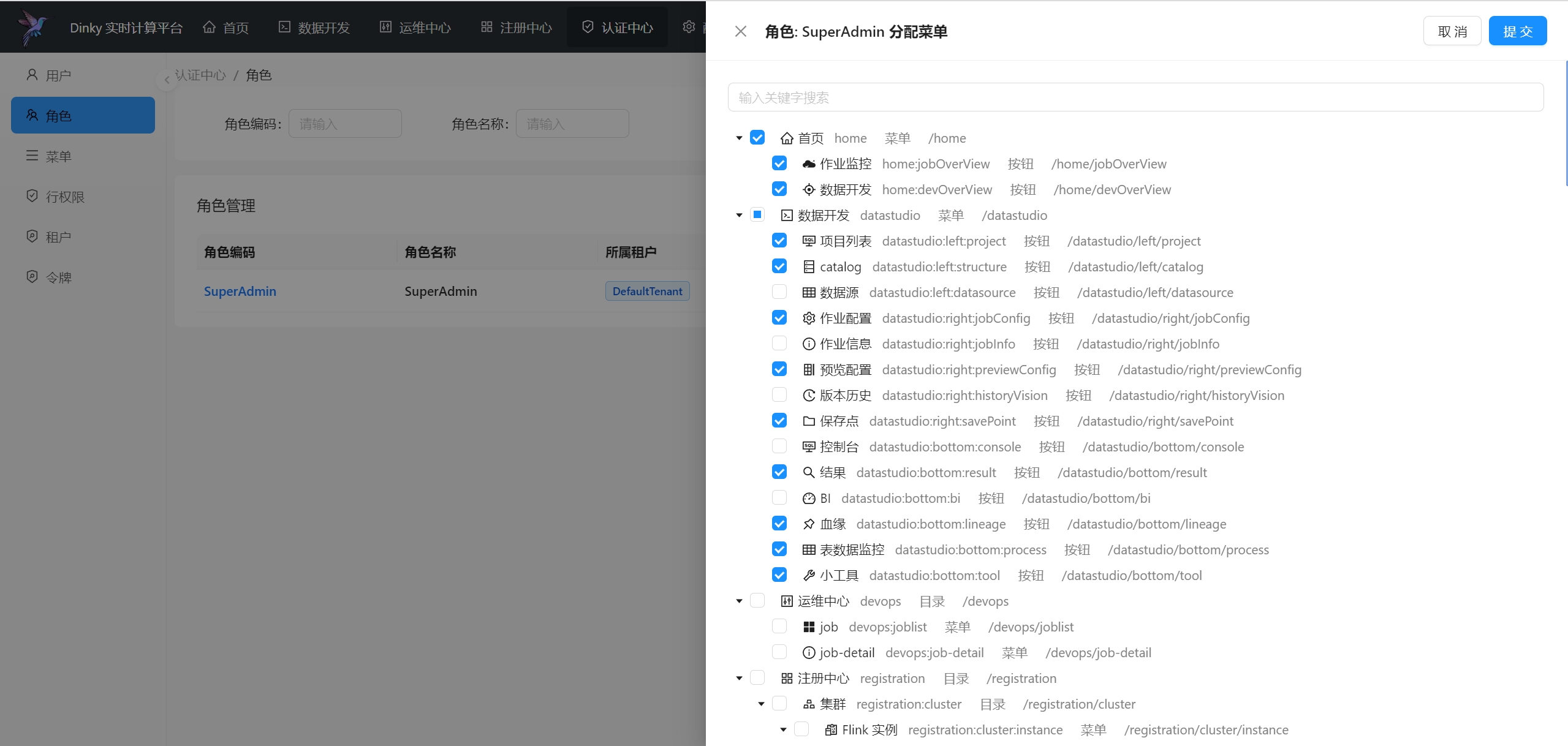

.../user_guide/auth_center/role.md | 44 ++

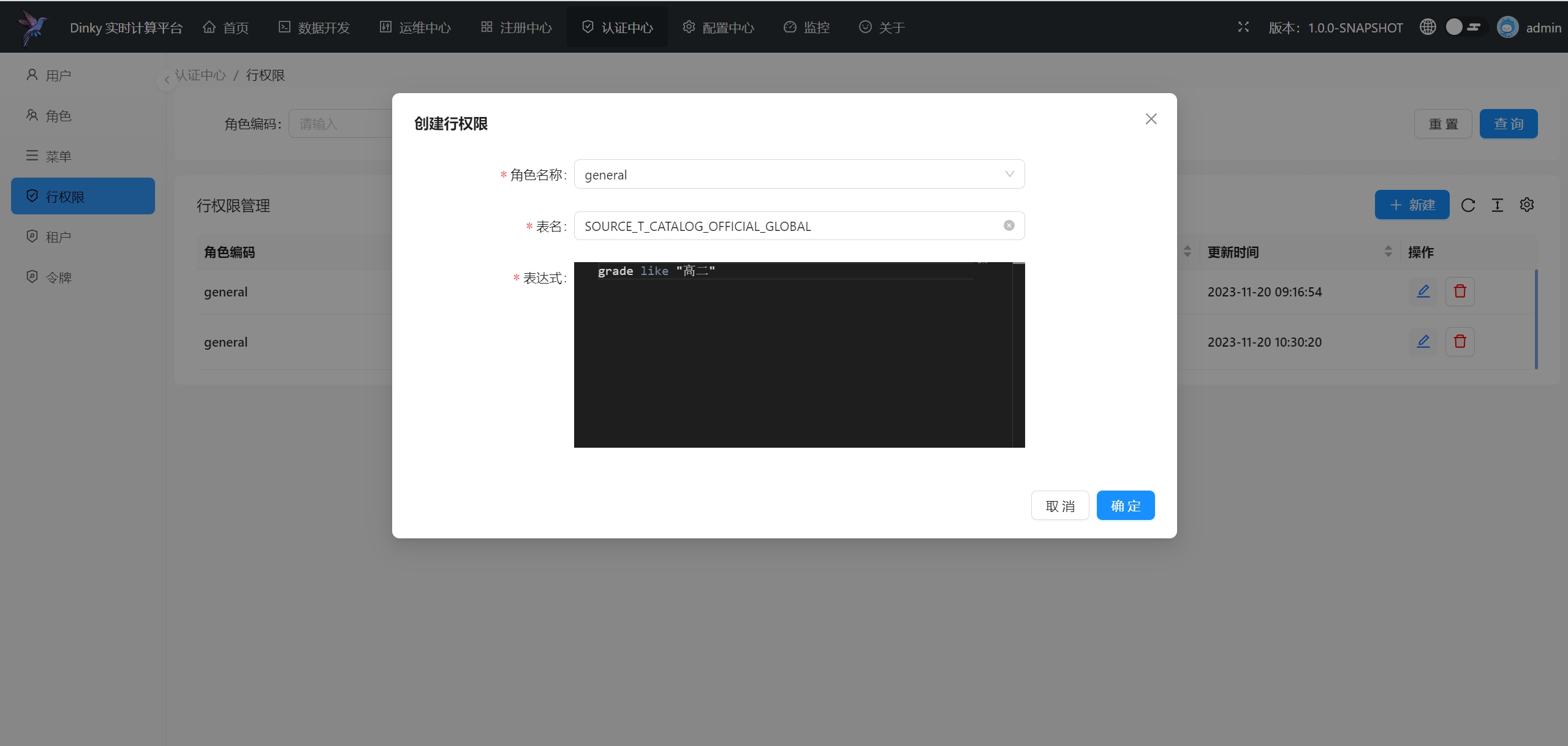

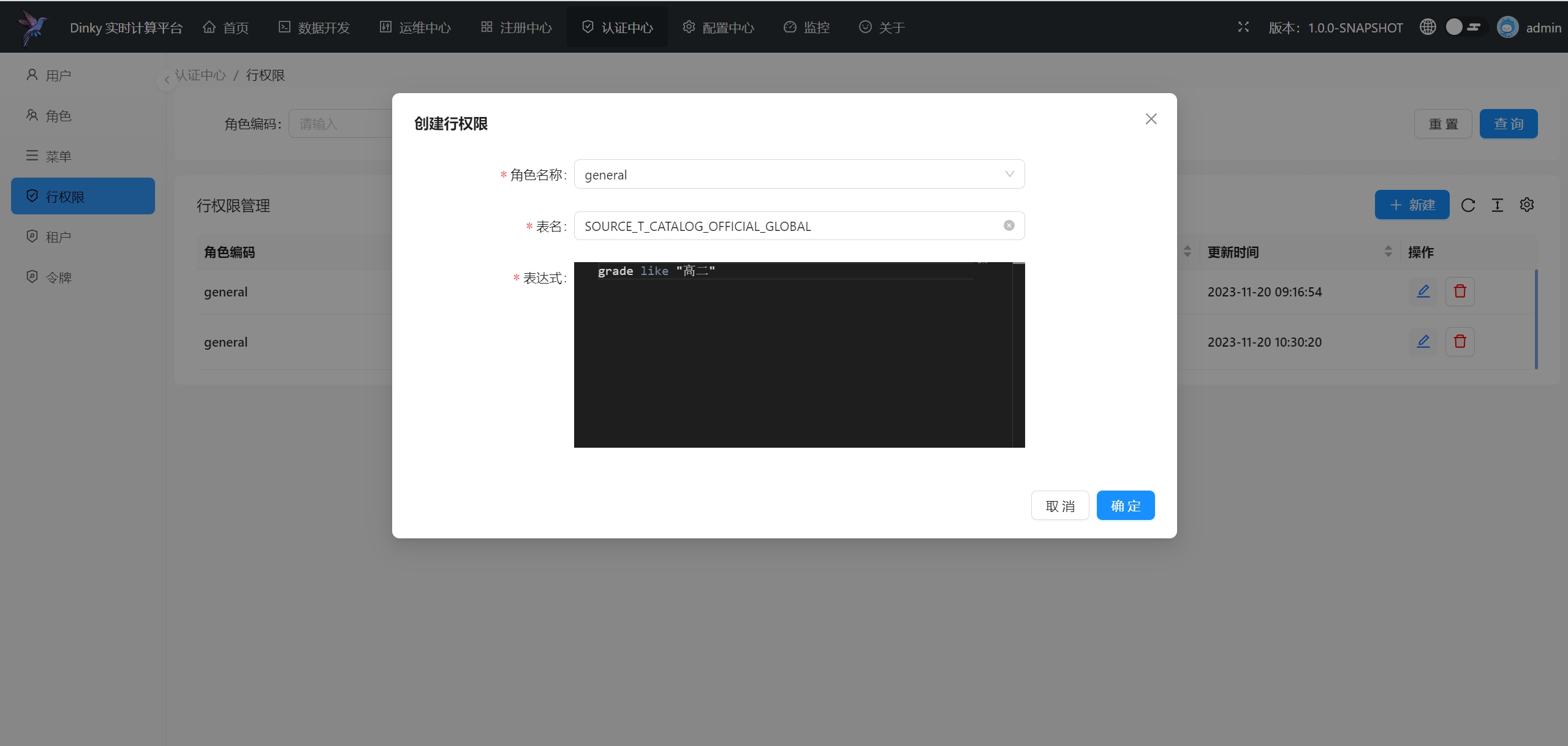

.../user_guide/auth_center/row_limits.md | 29 ++

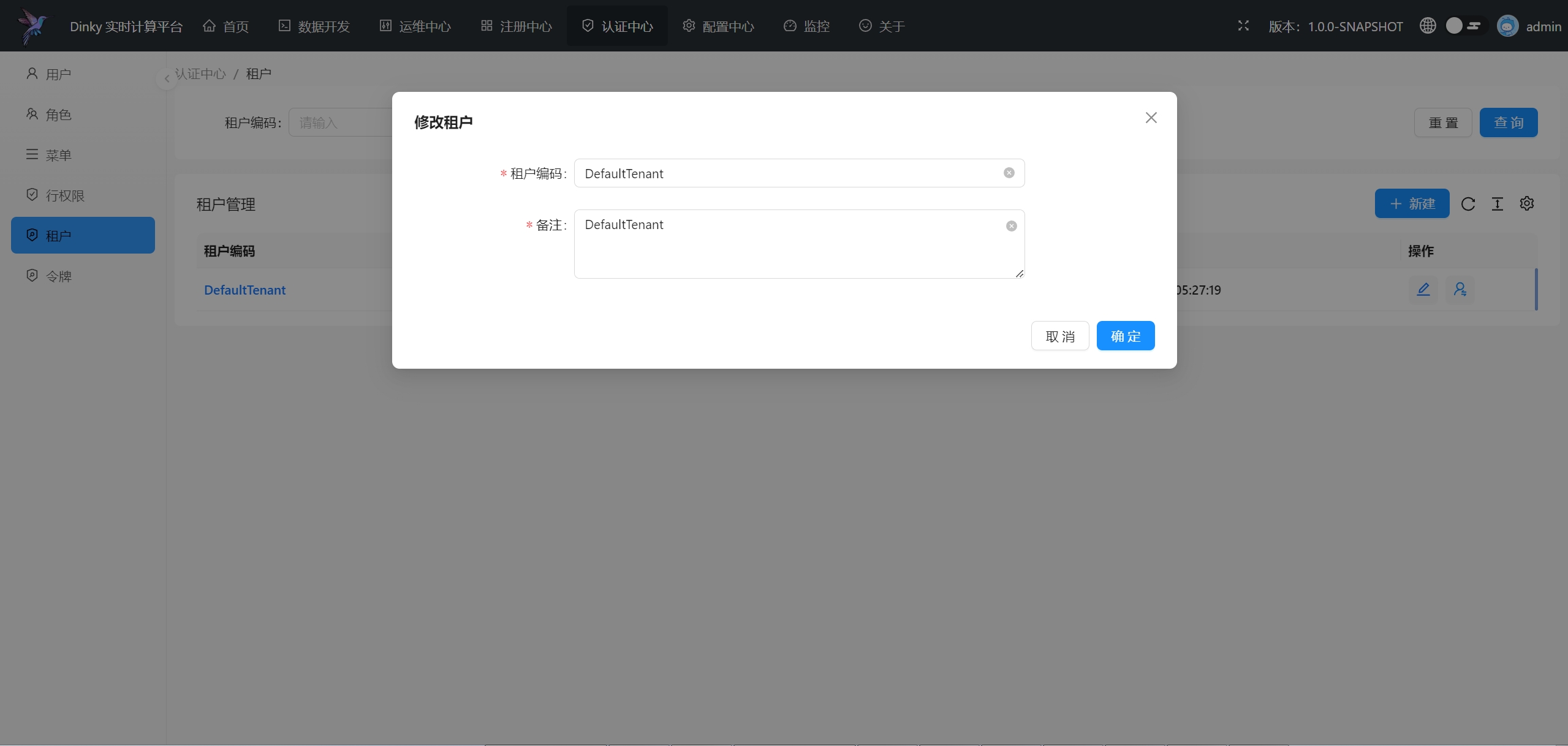

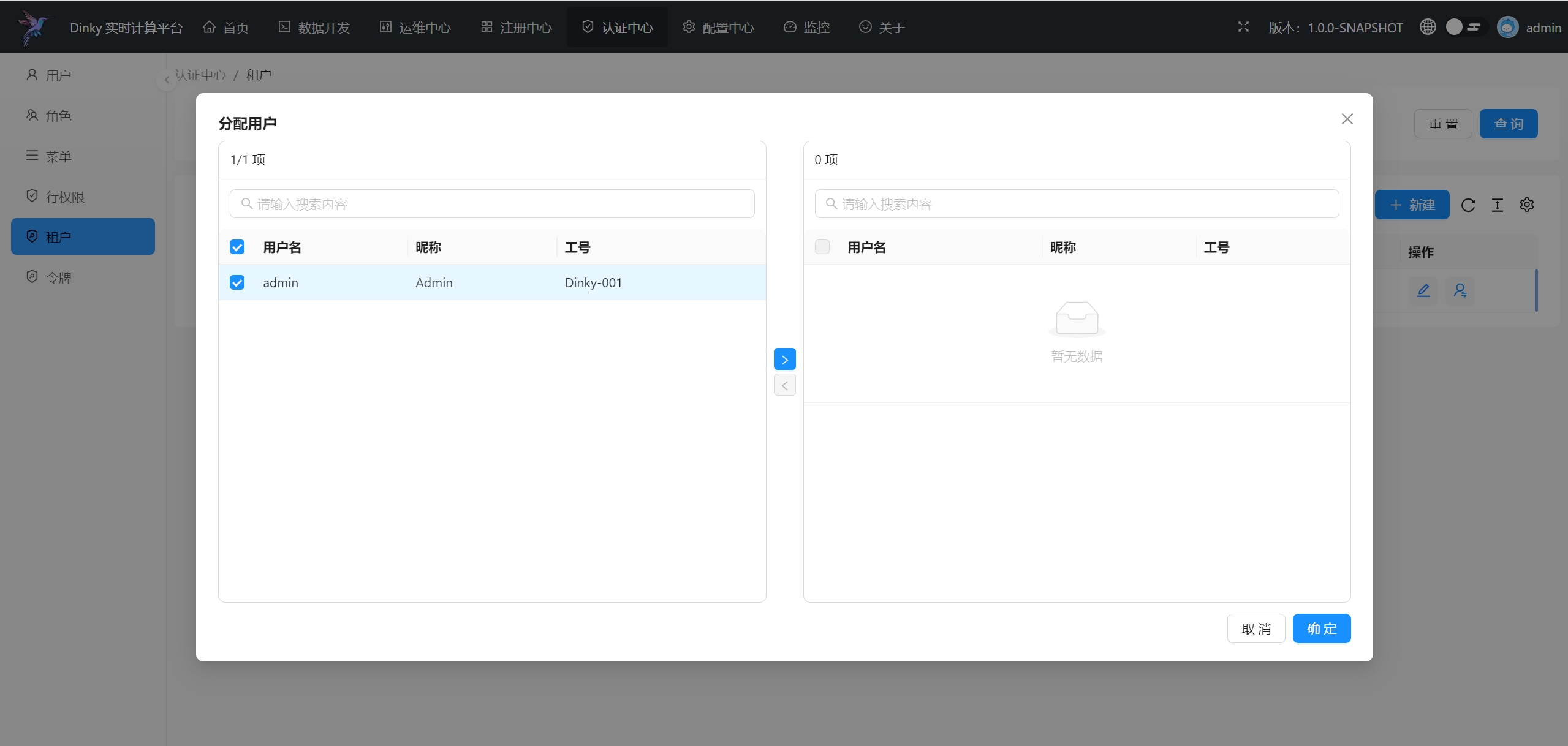

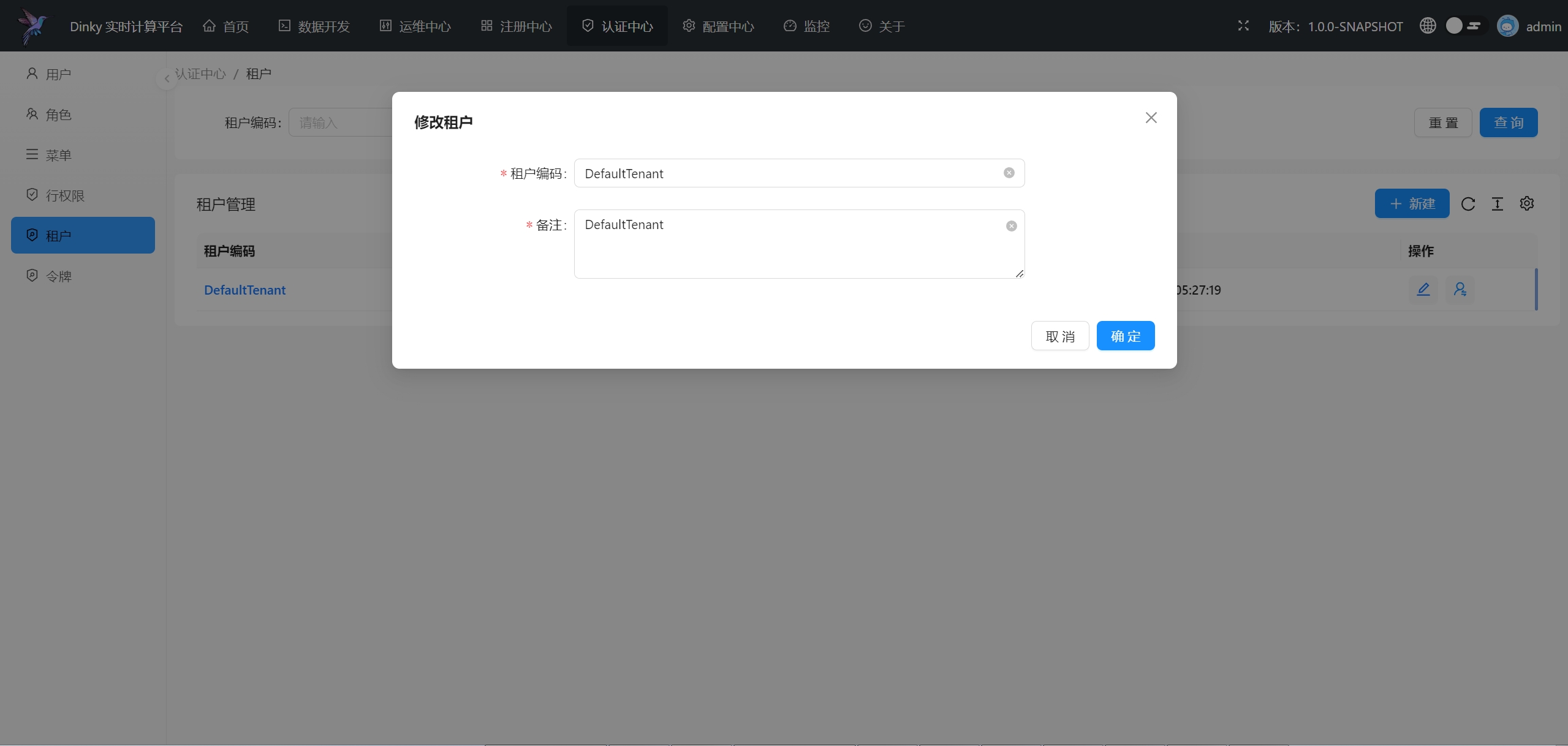

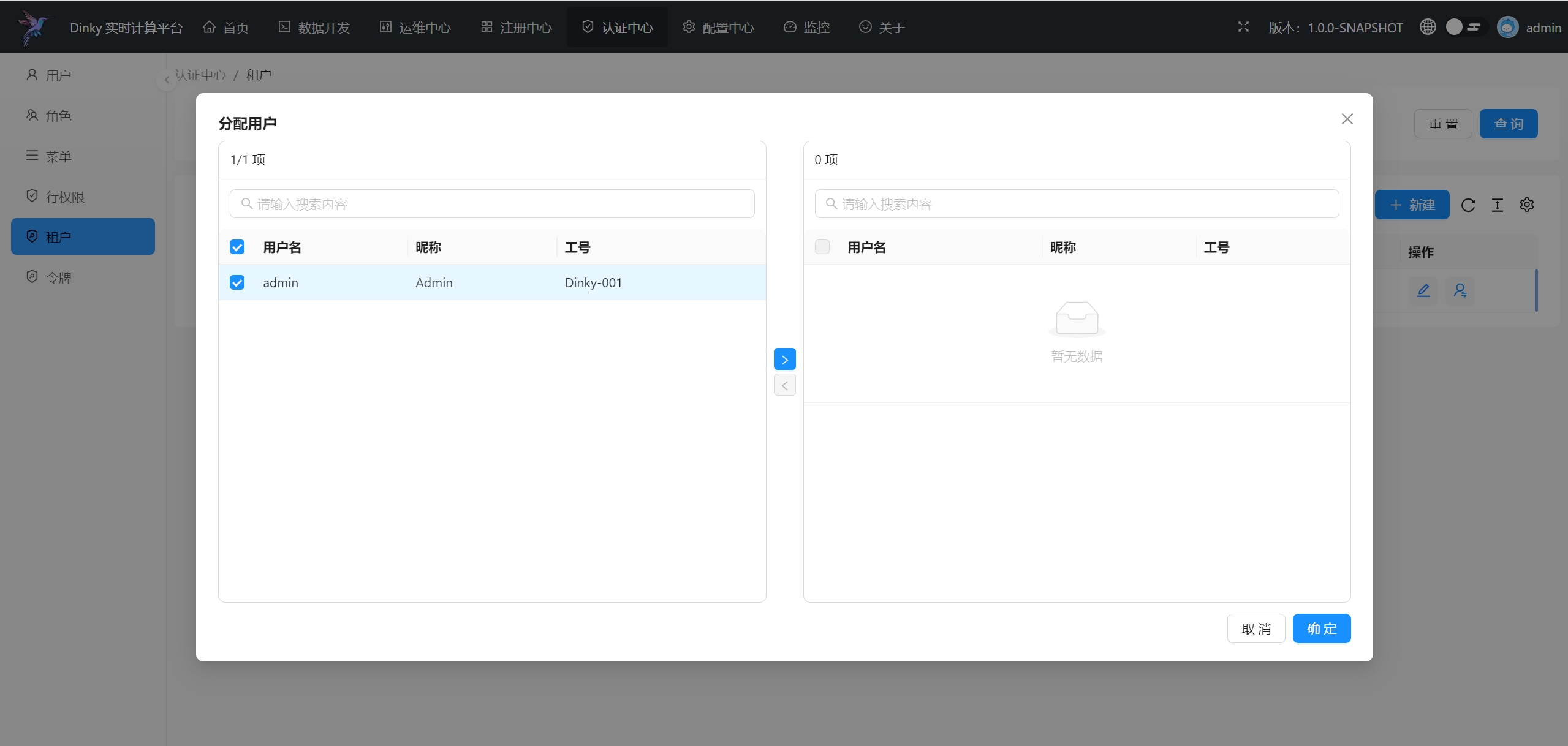

.../user_guide/auth_center/tenant.md | 35 ++

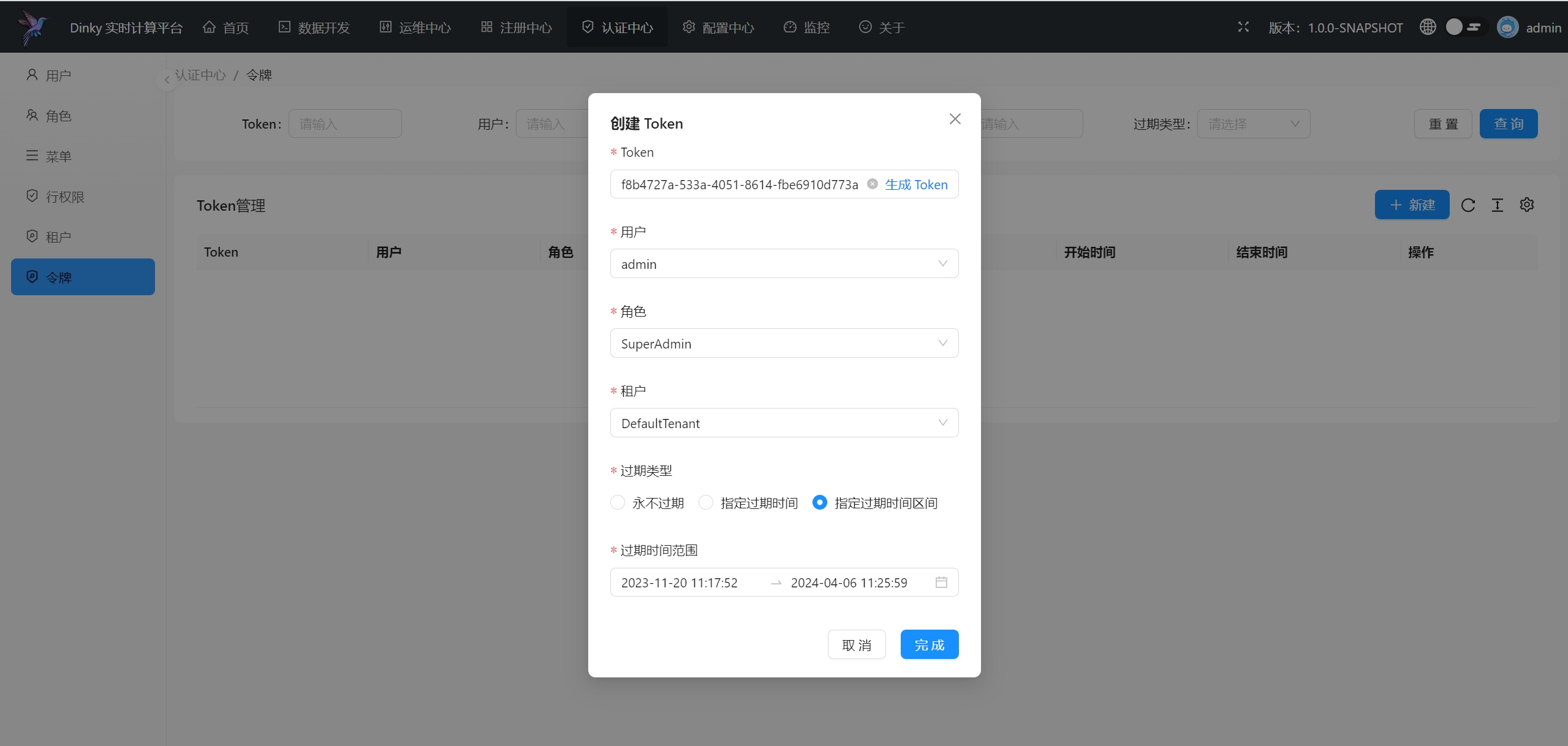

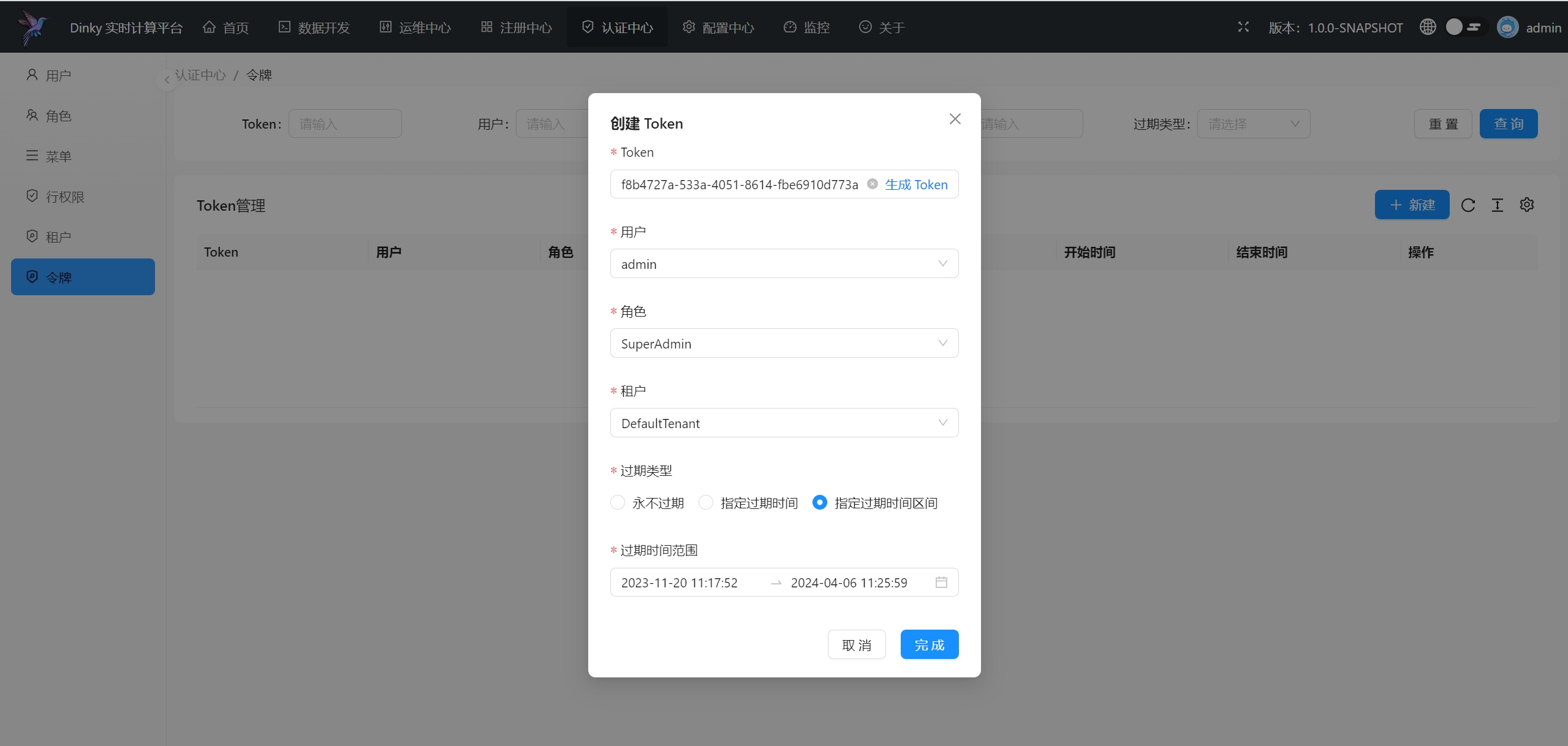

.../user_guide/auth_center/token.md | 30 ++

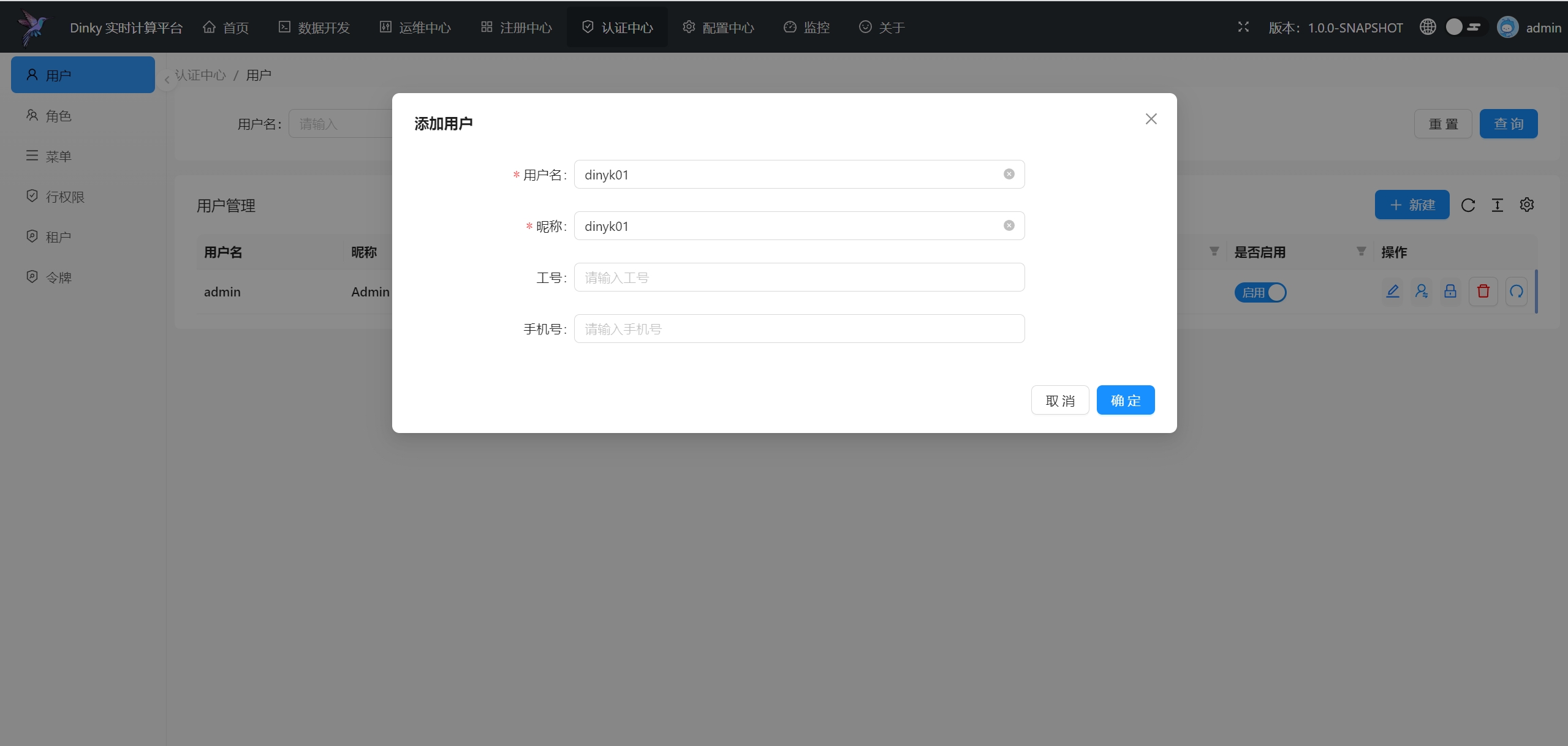

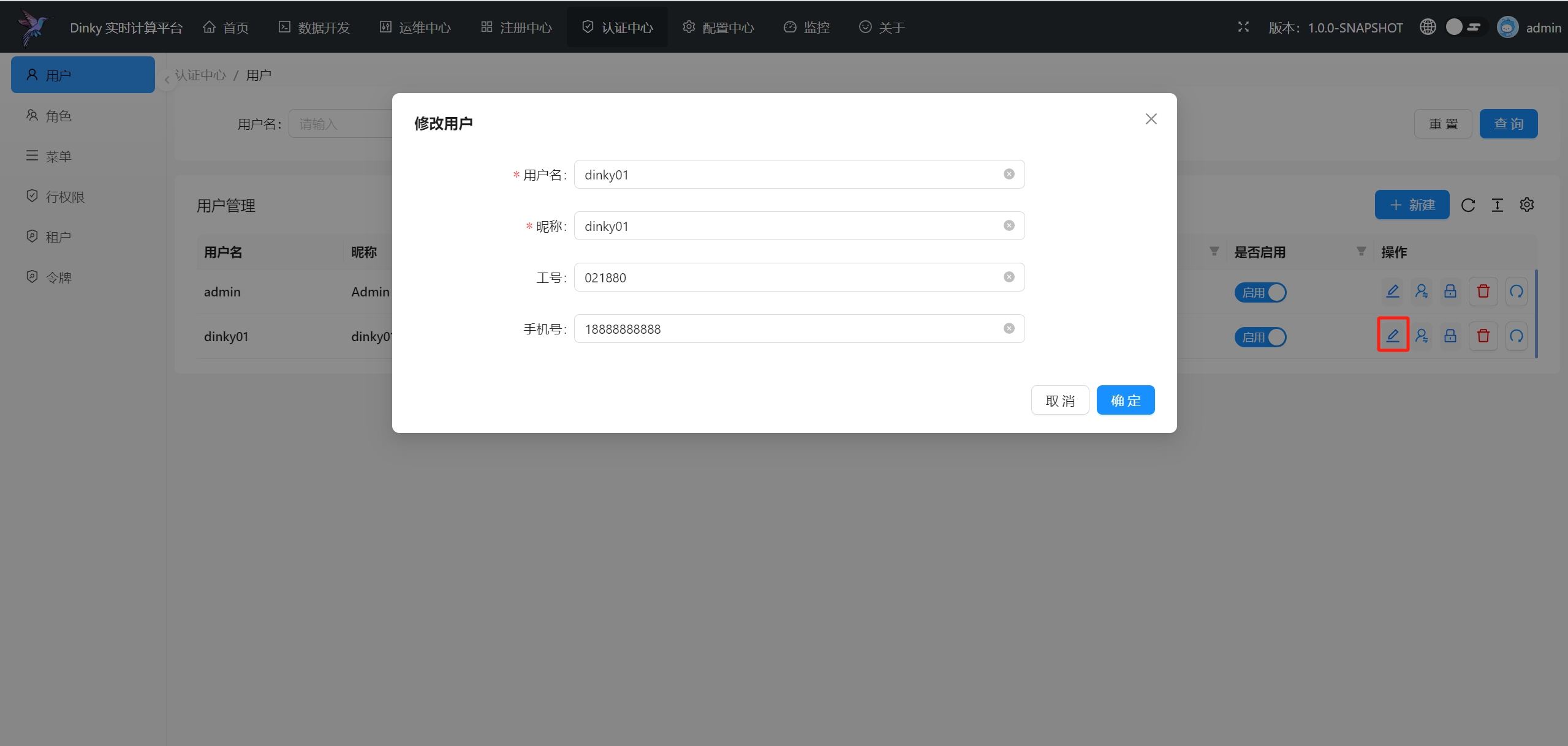

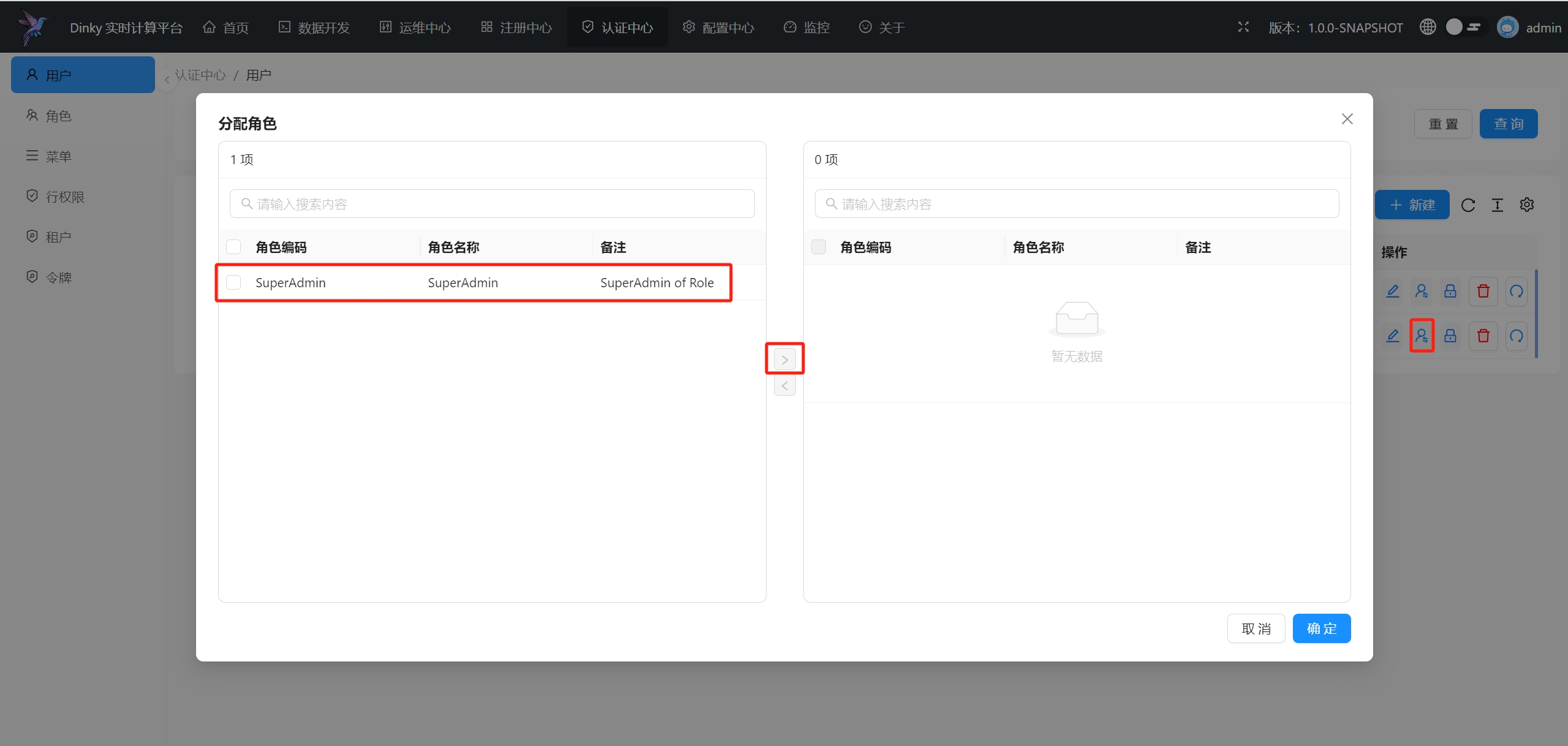

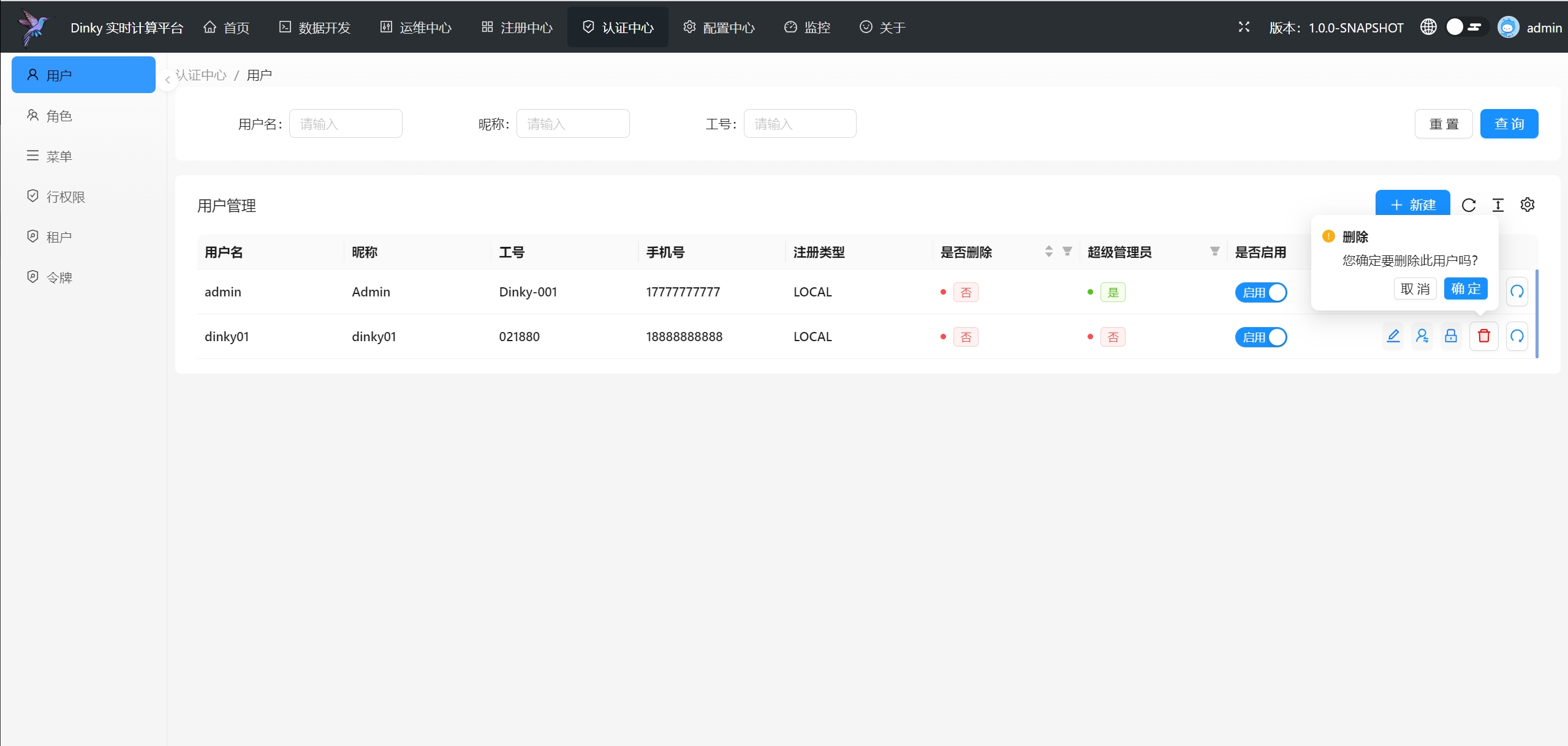

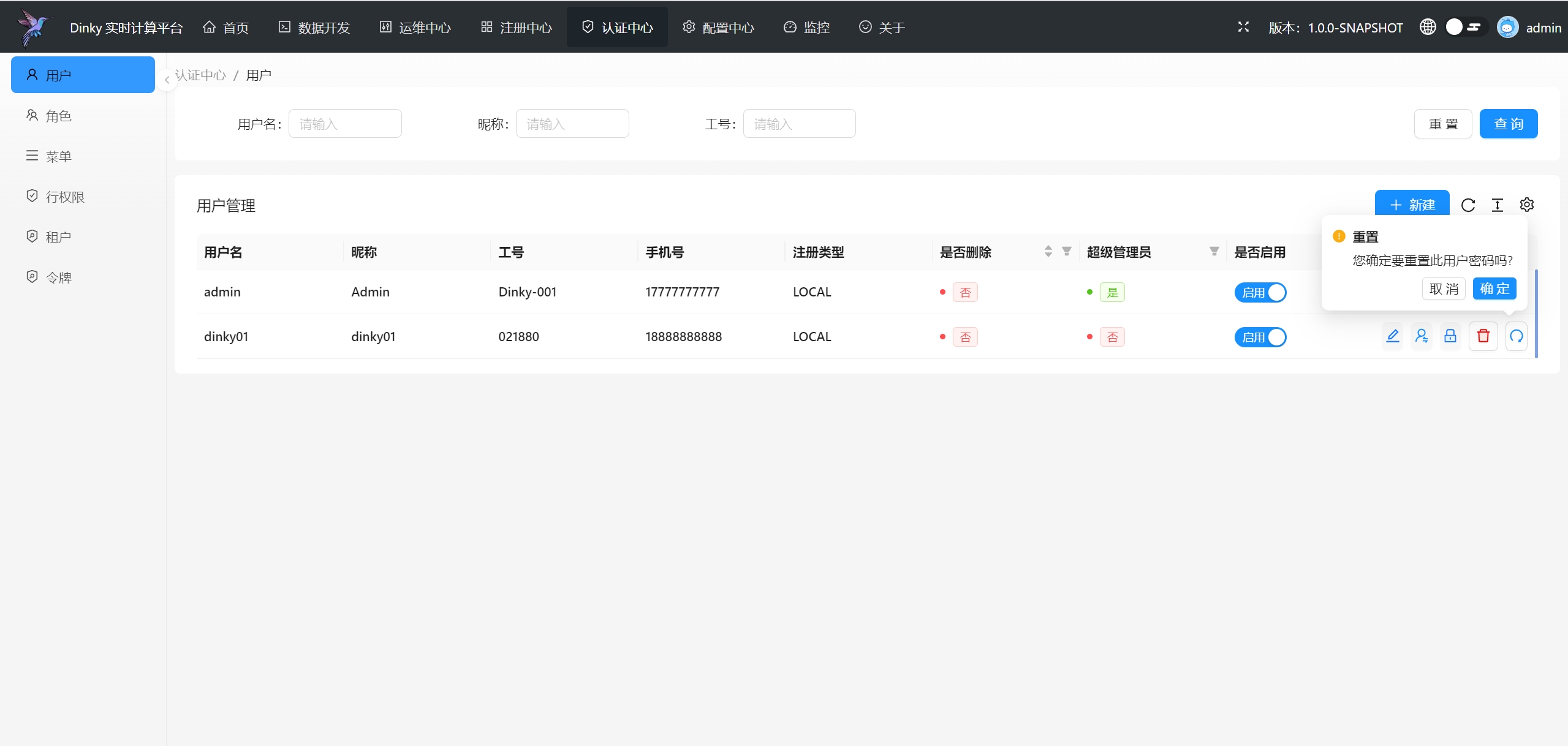

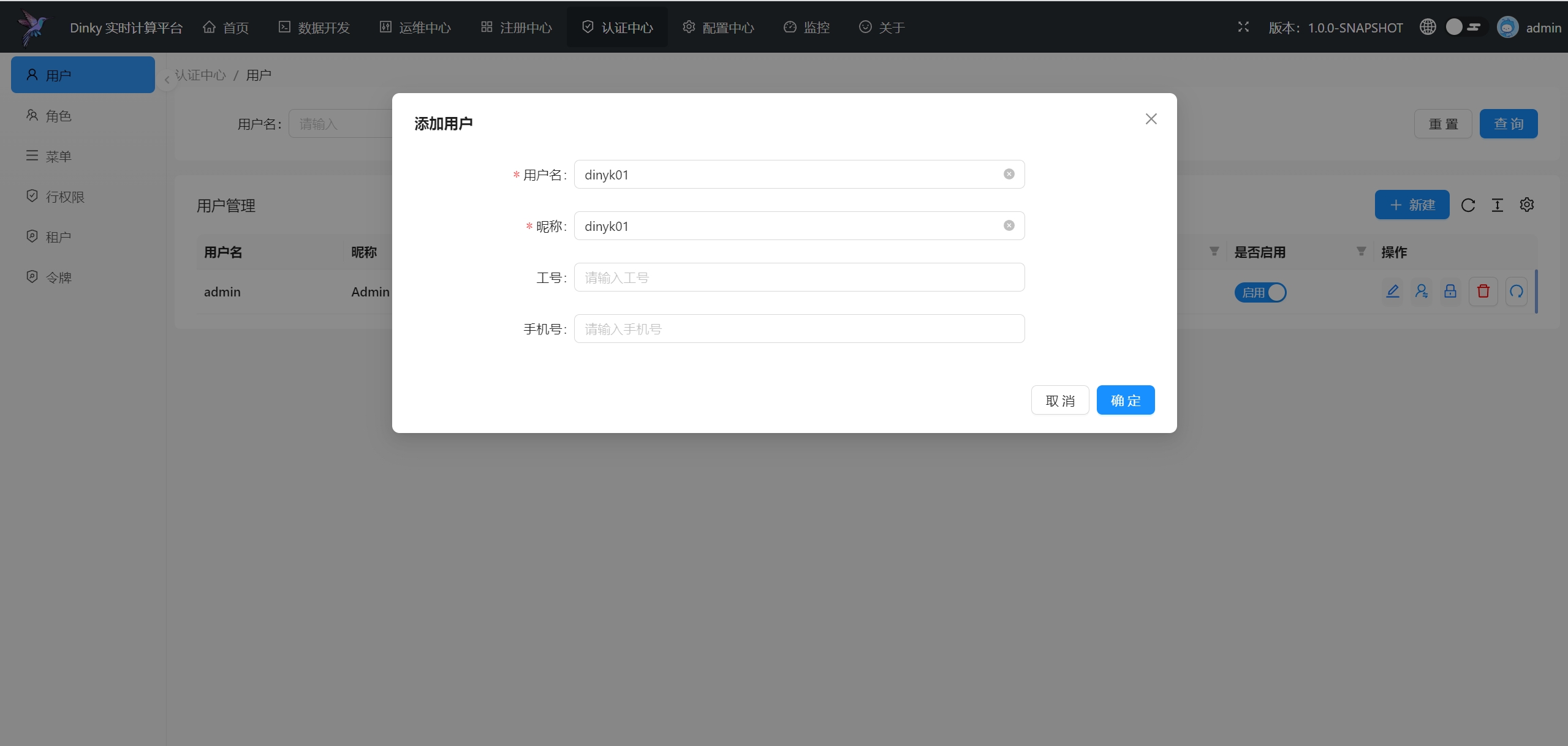

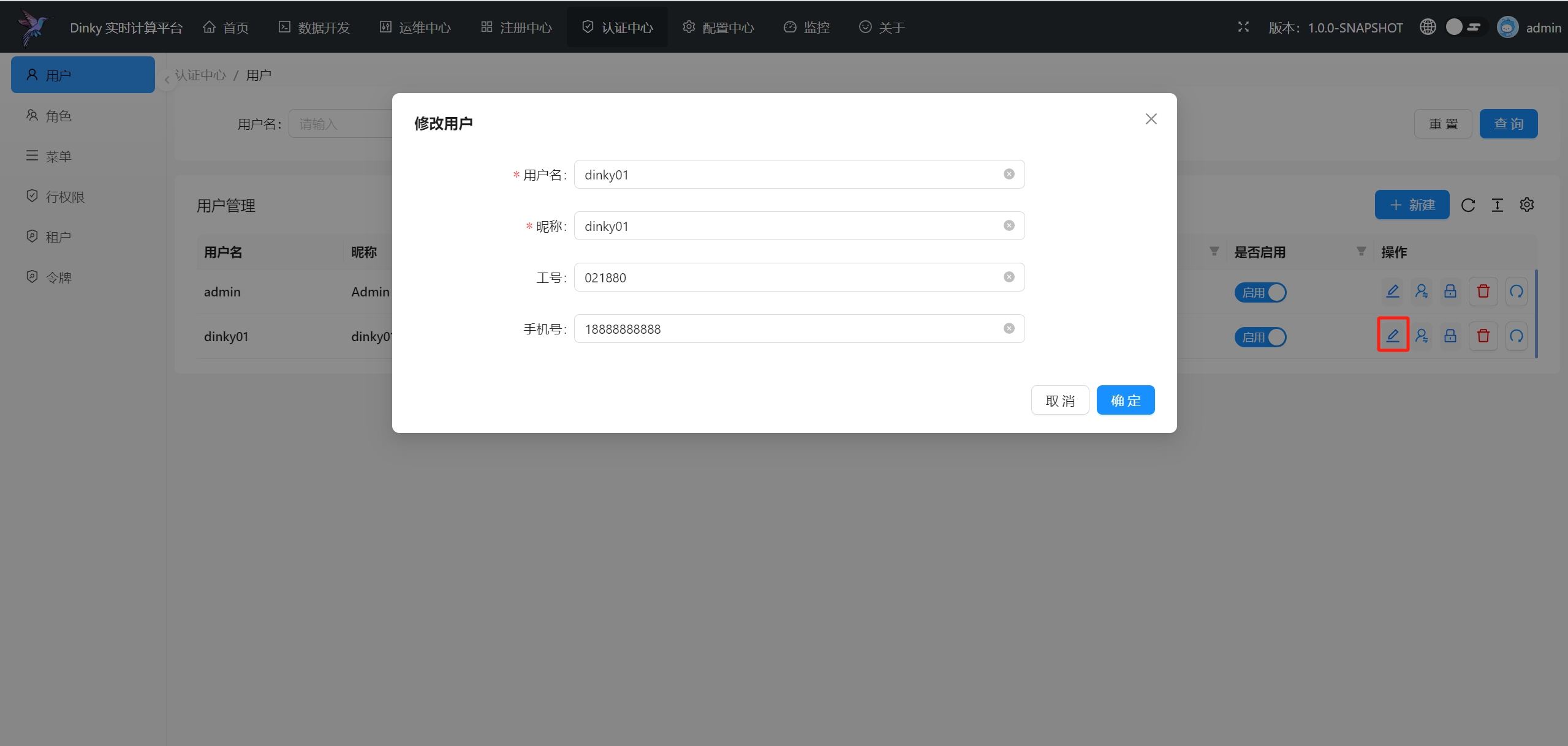

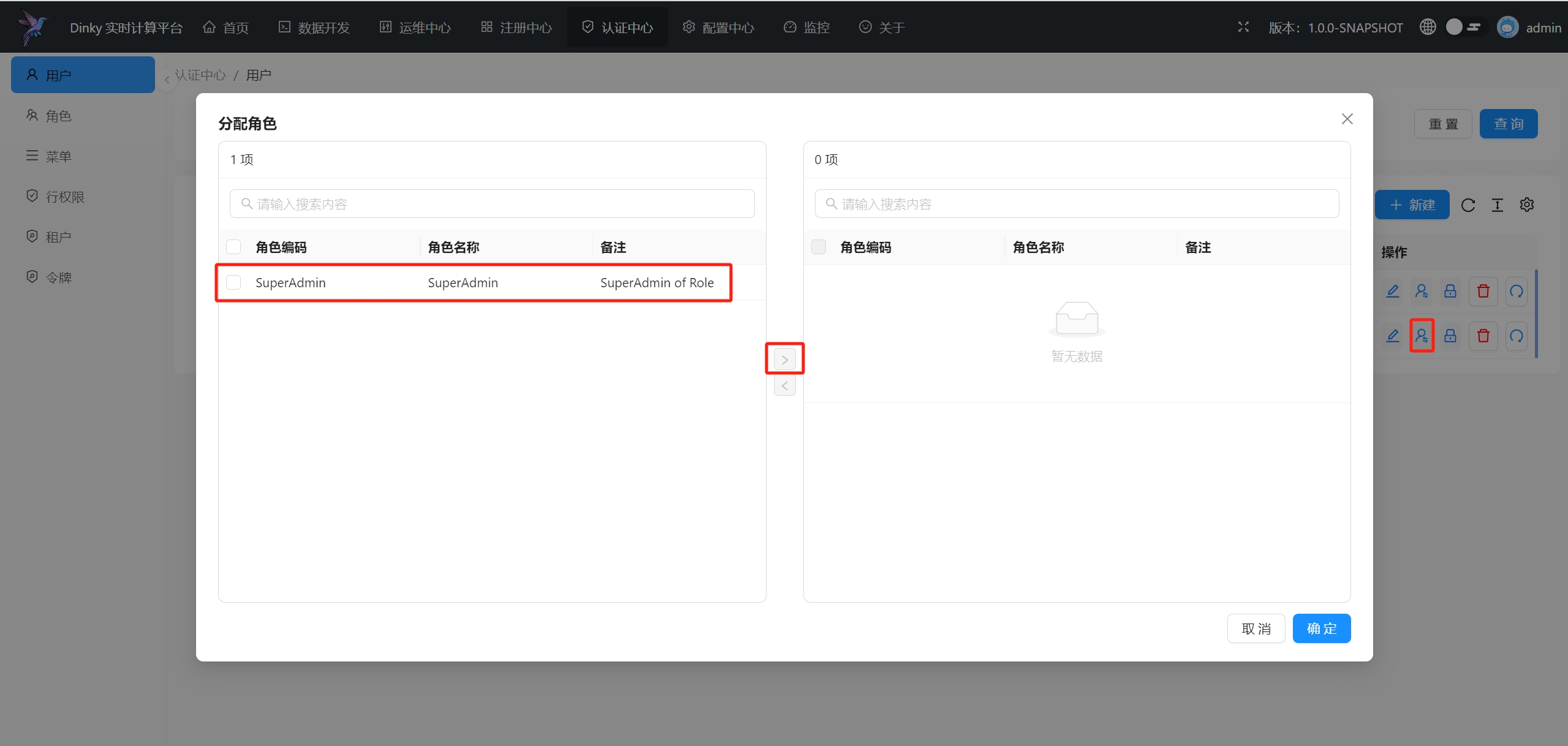

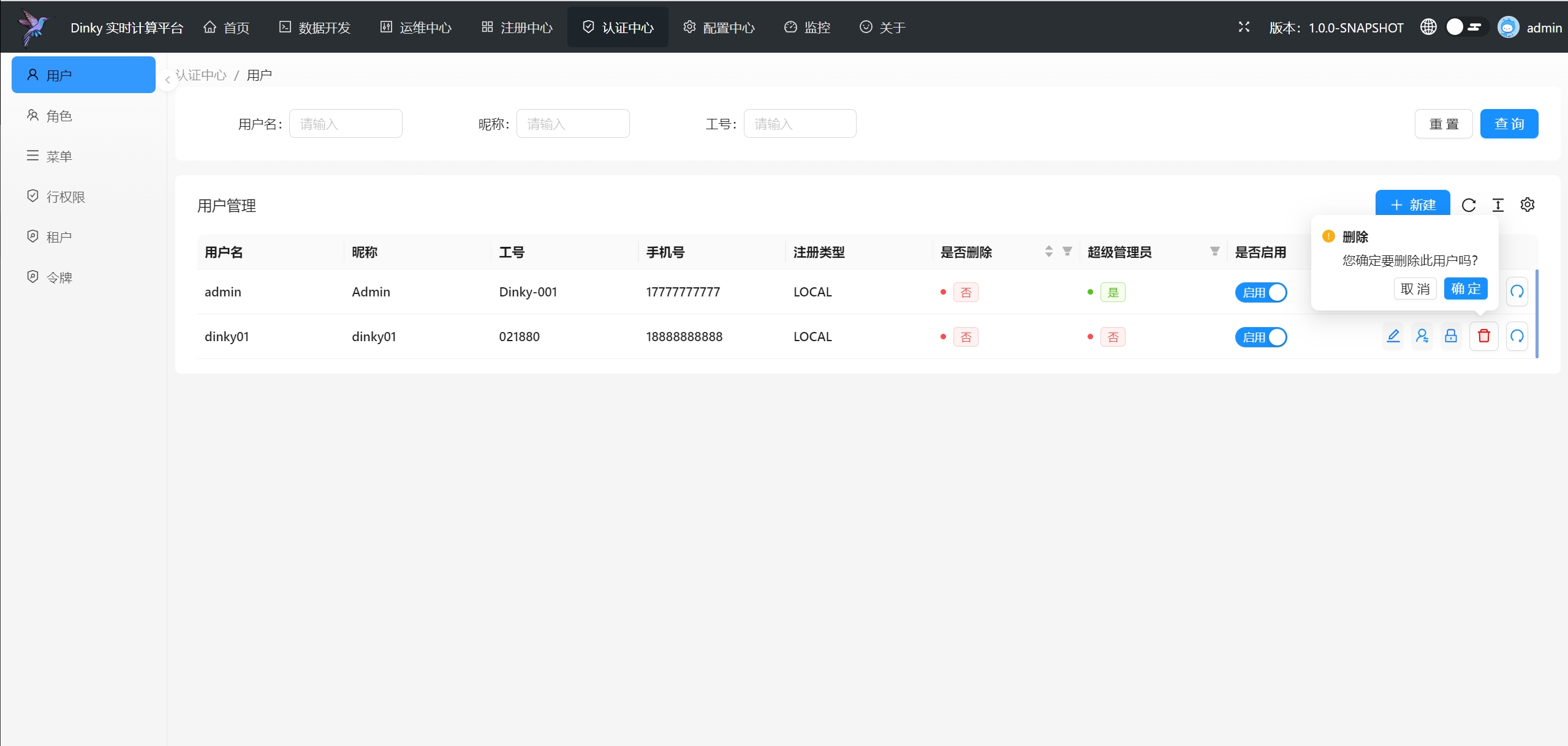

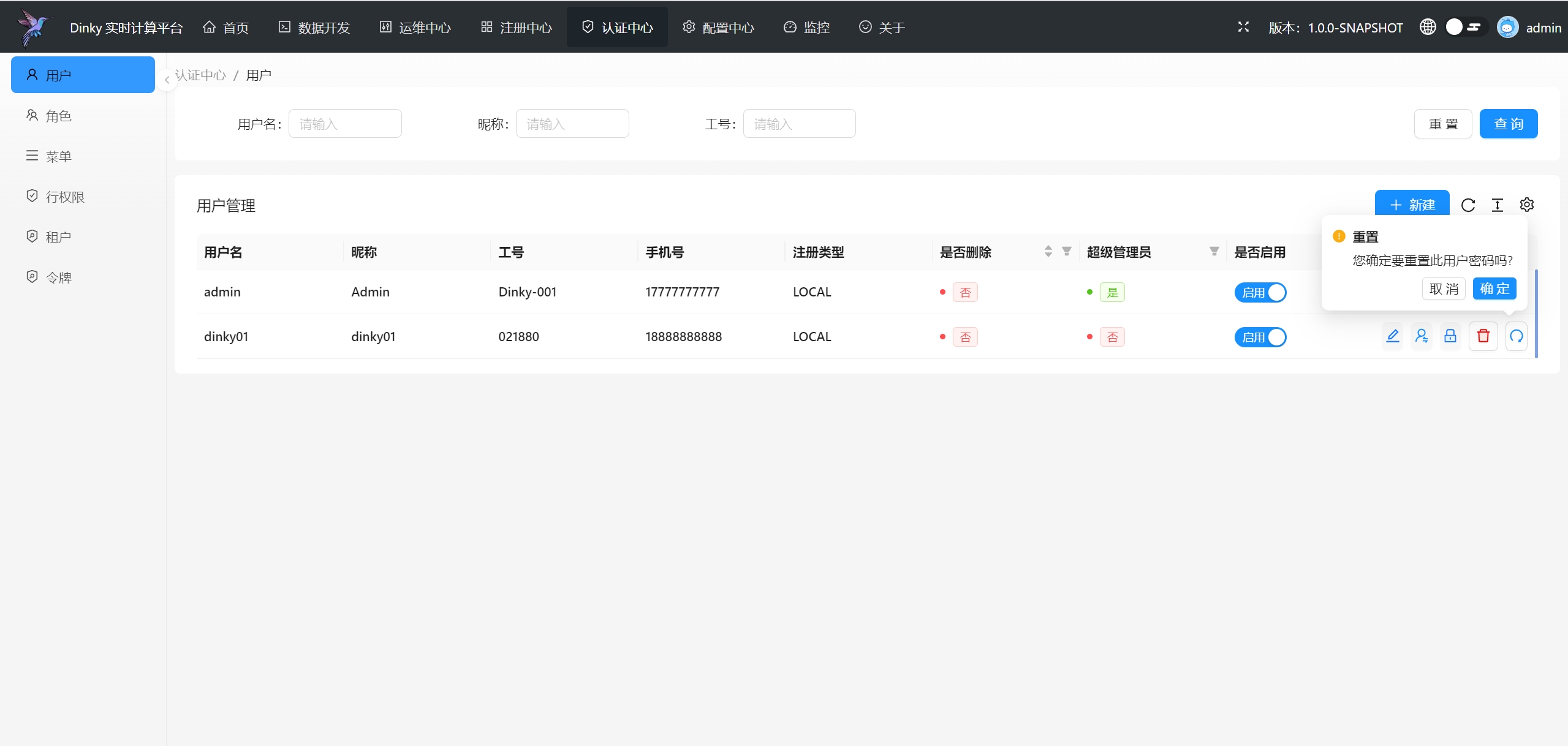

.../user_guide/auth_center/user.md | 96 +++++

.../user_guide/devops_center/_category_.json | 4 +

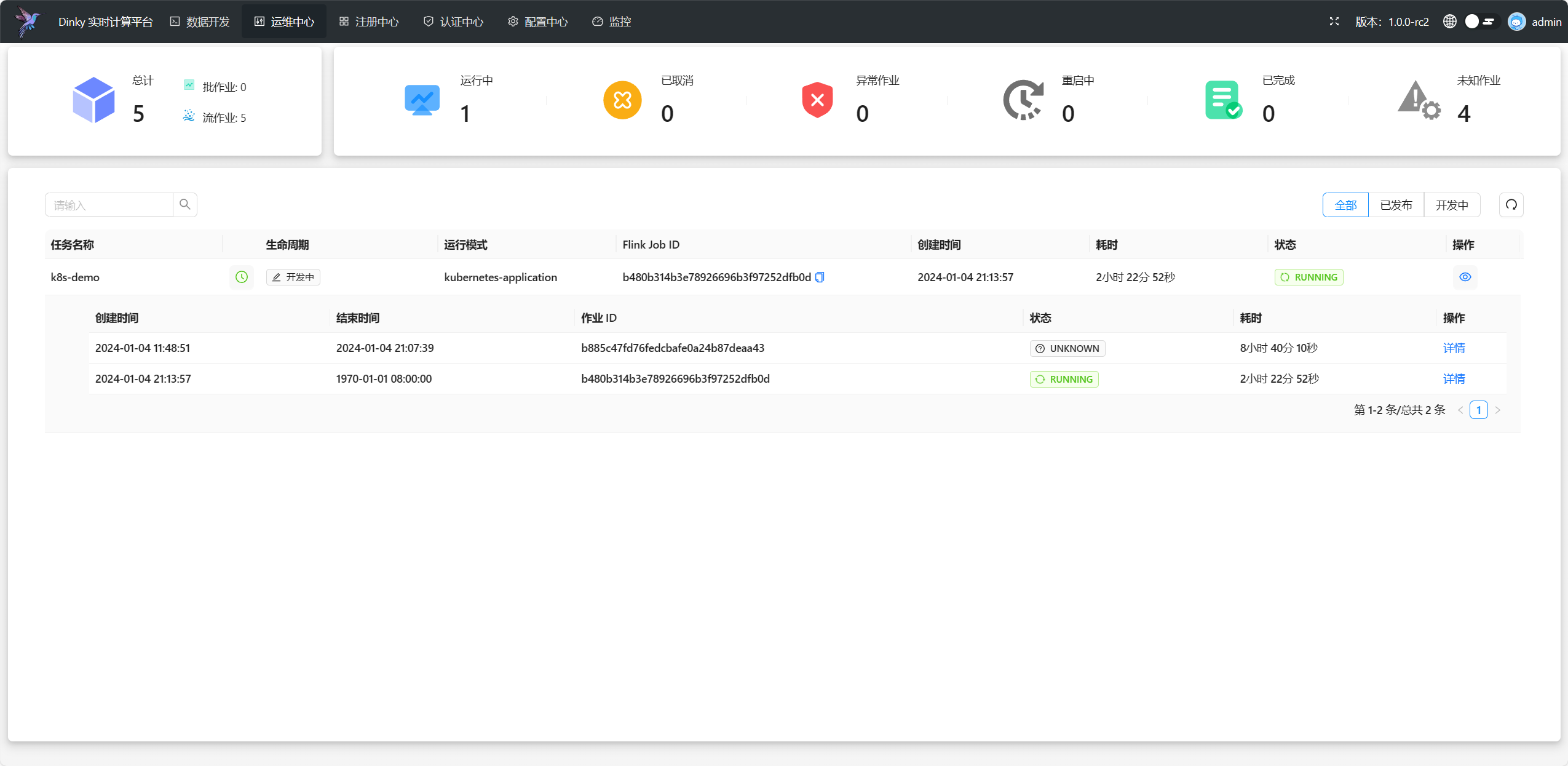

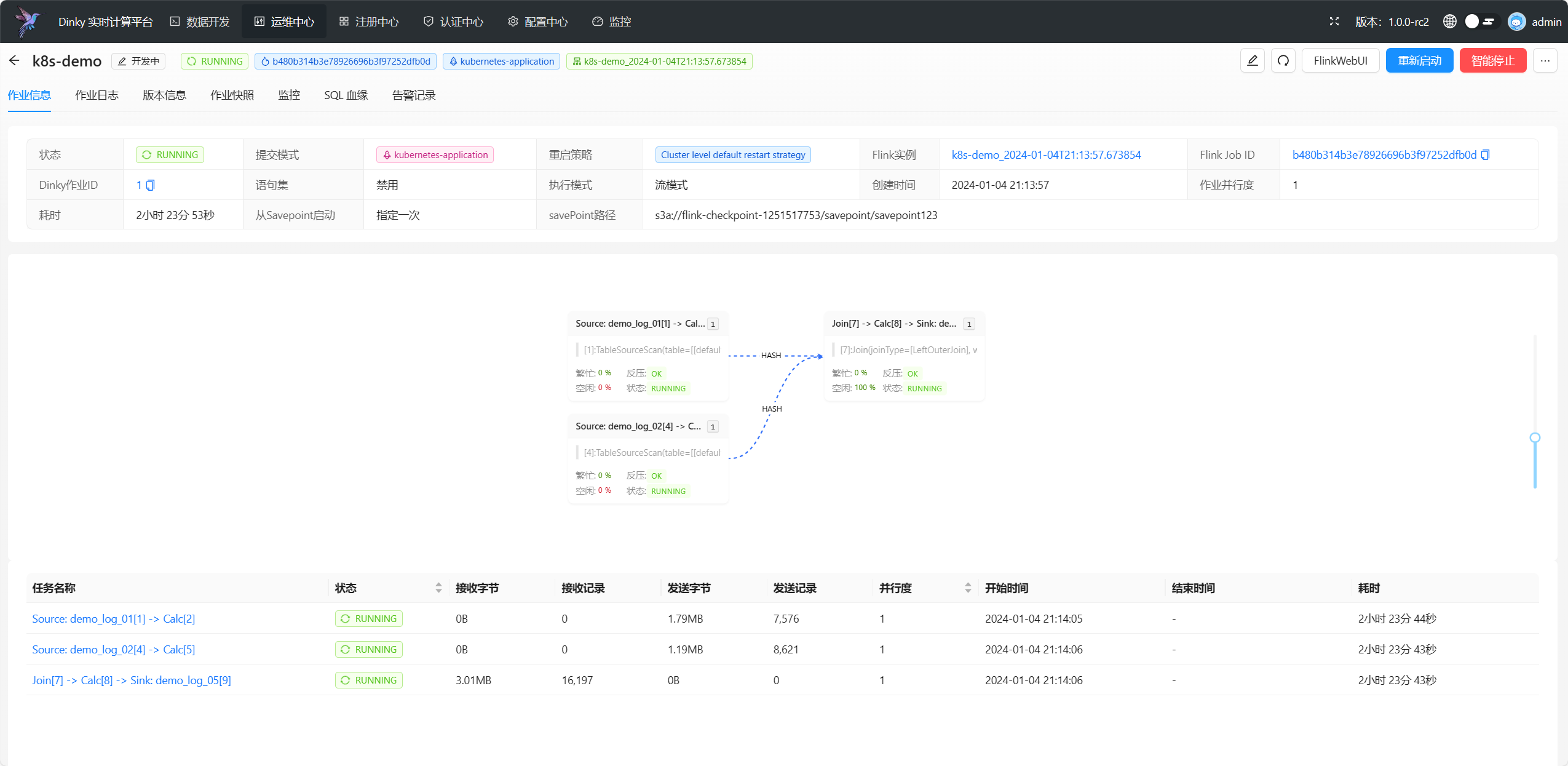

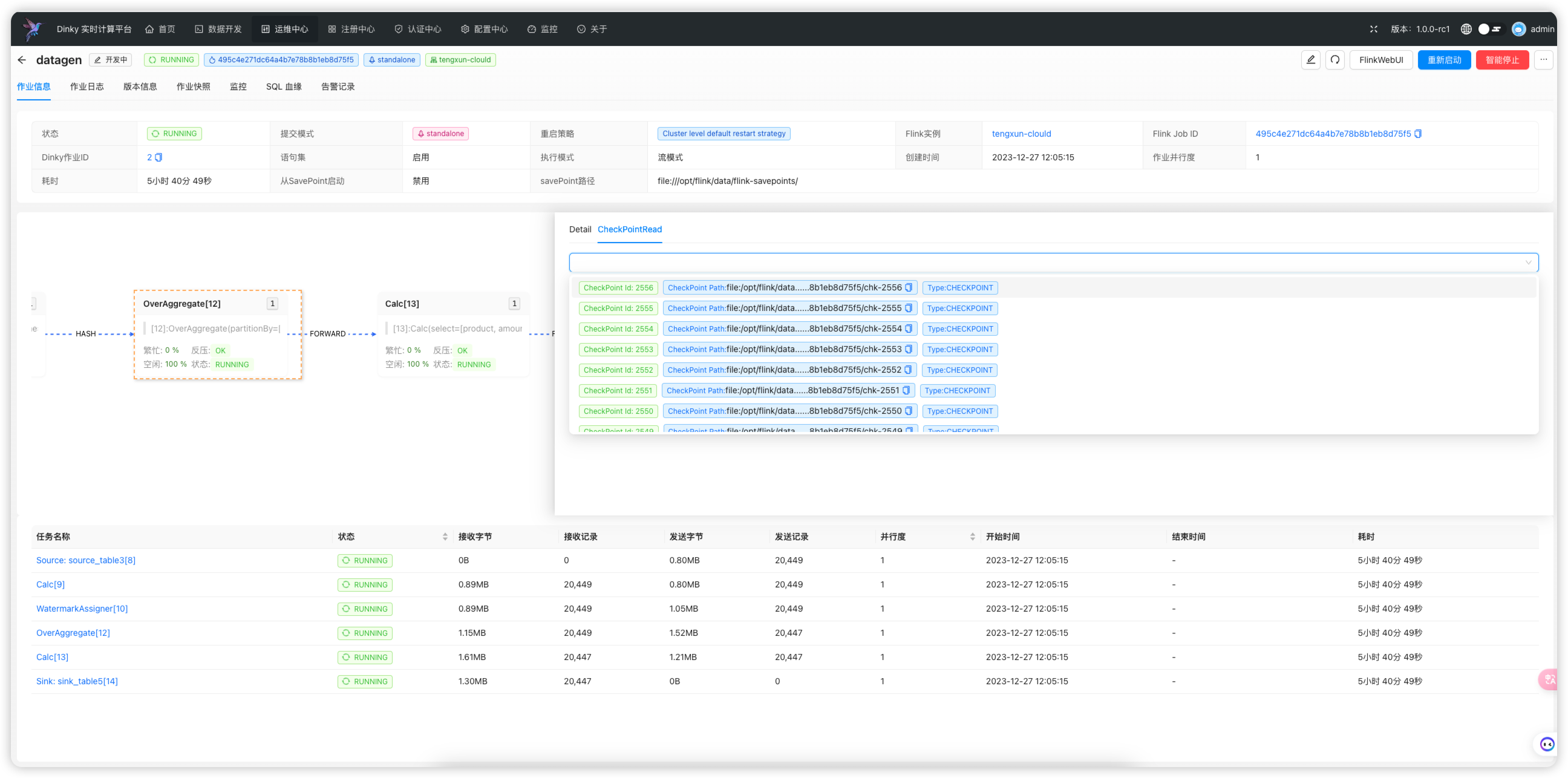

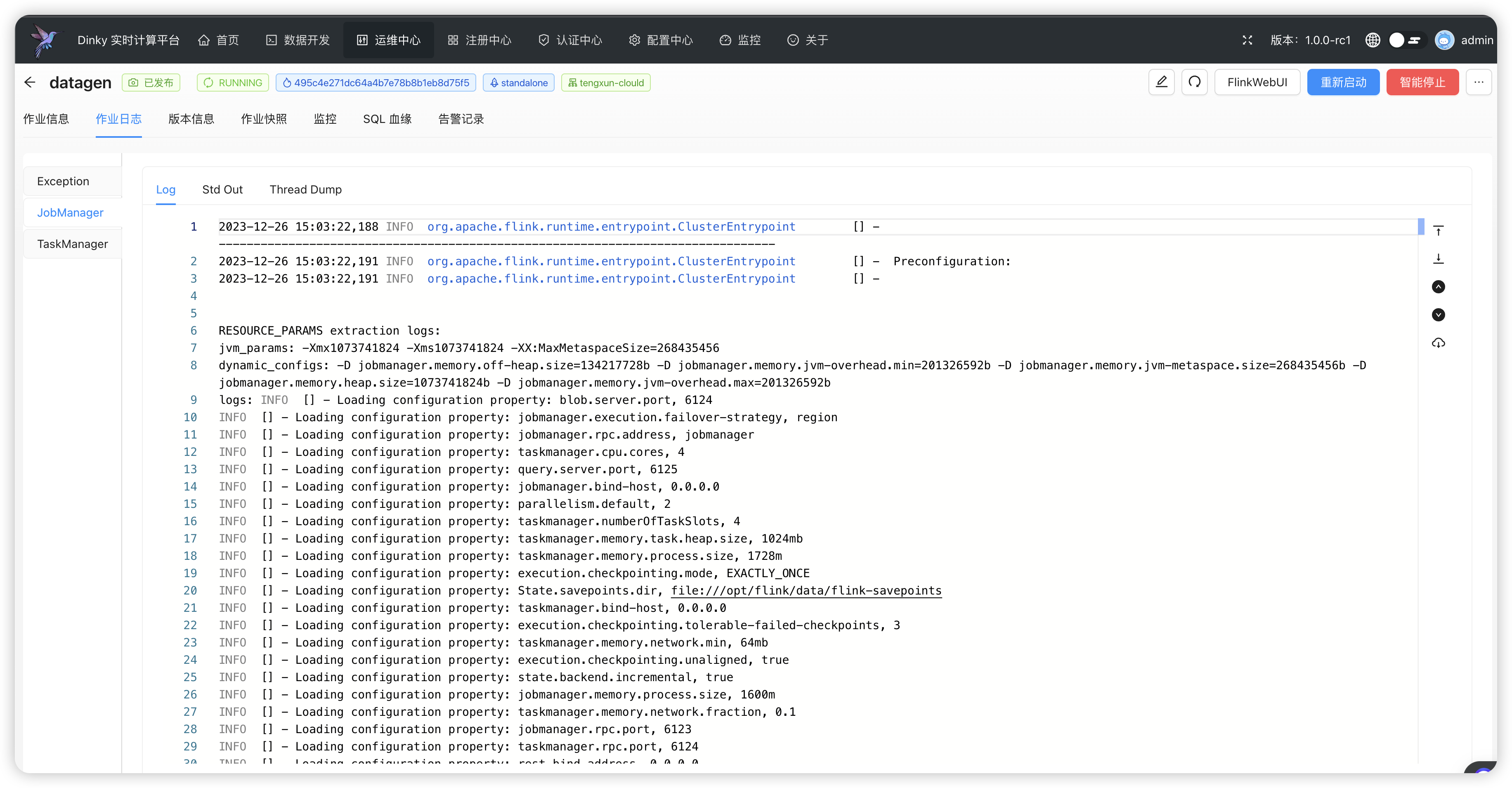

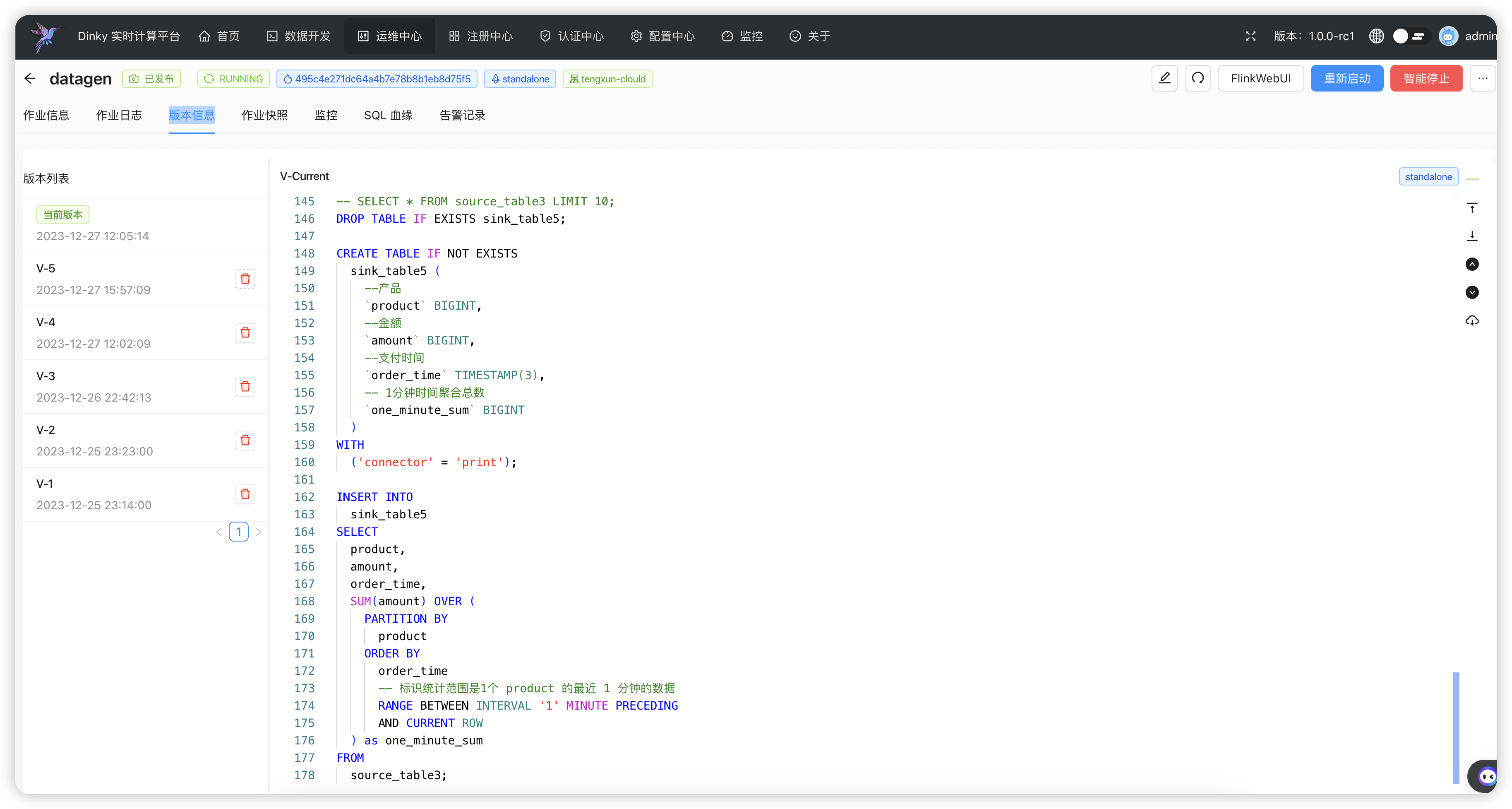

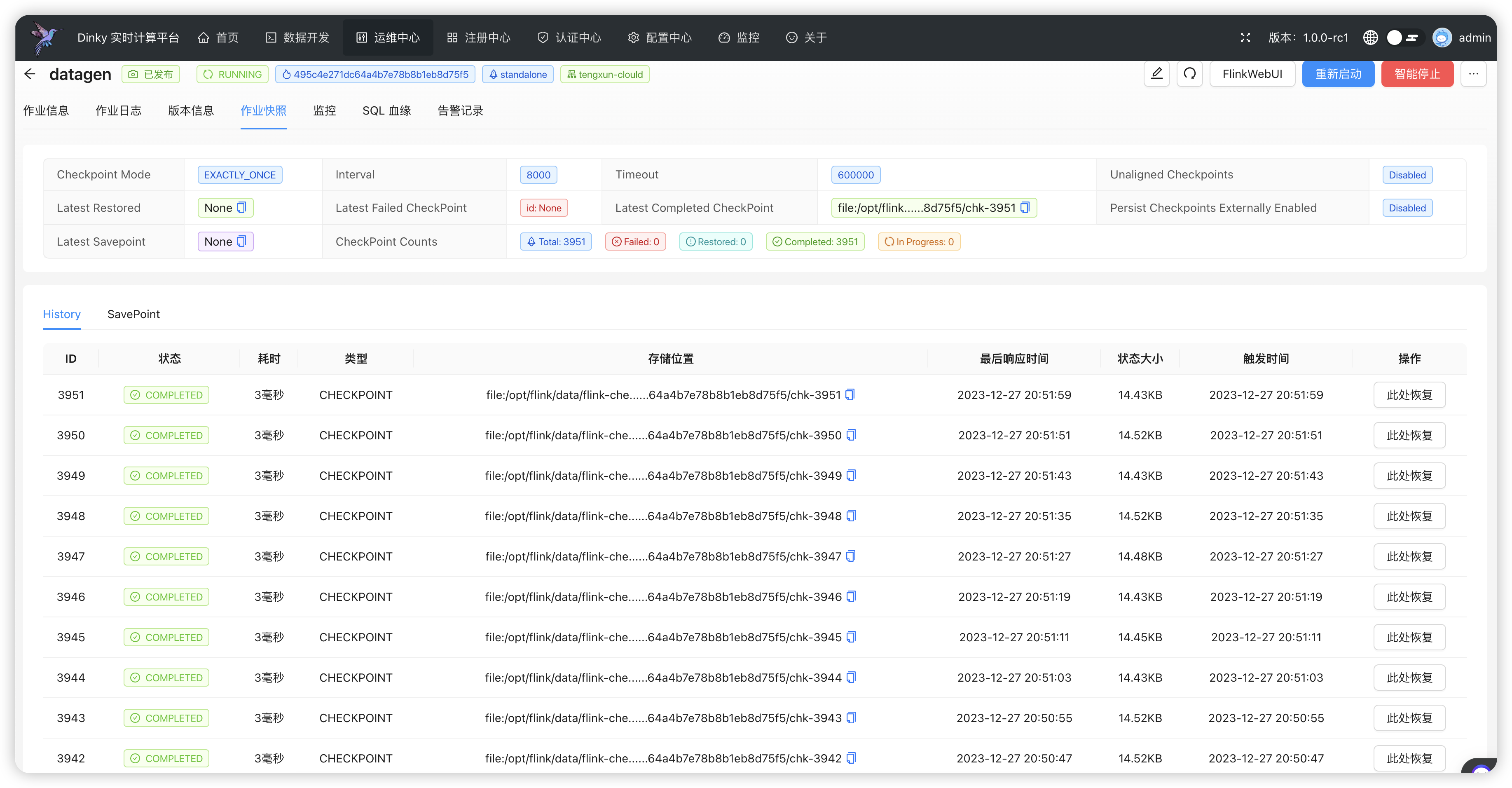

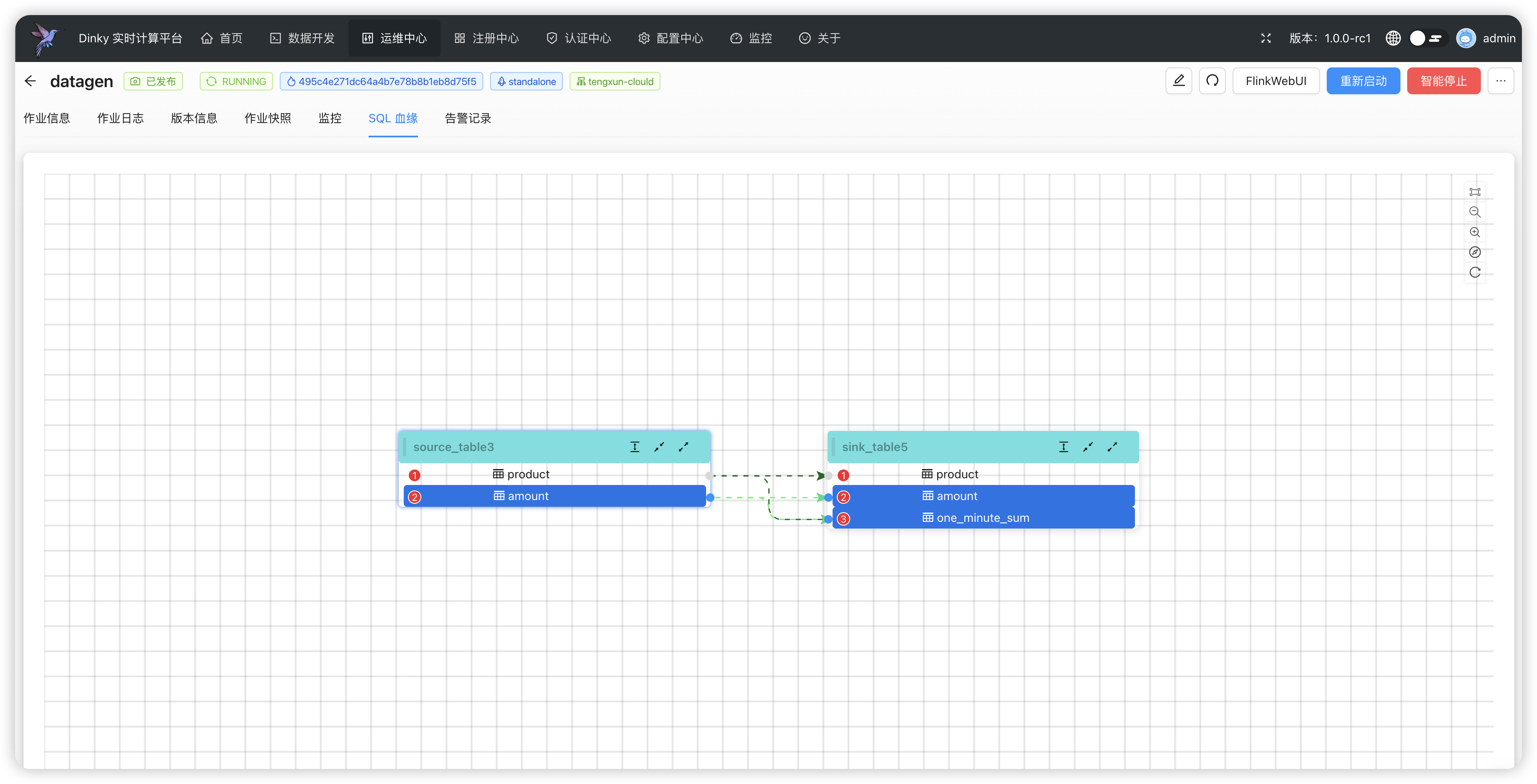

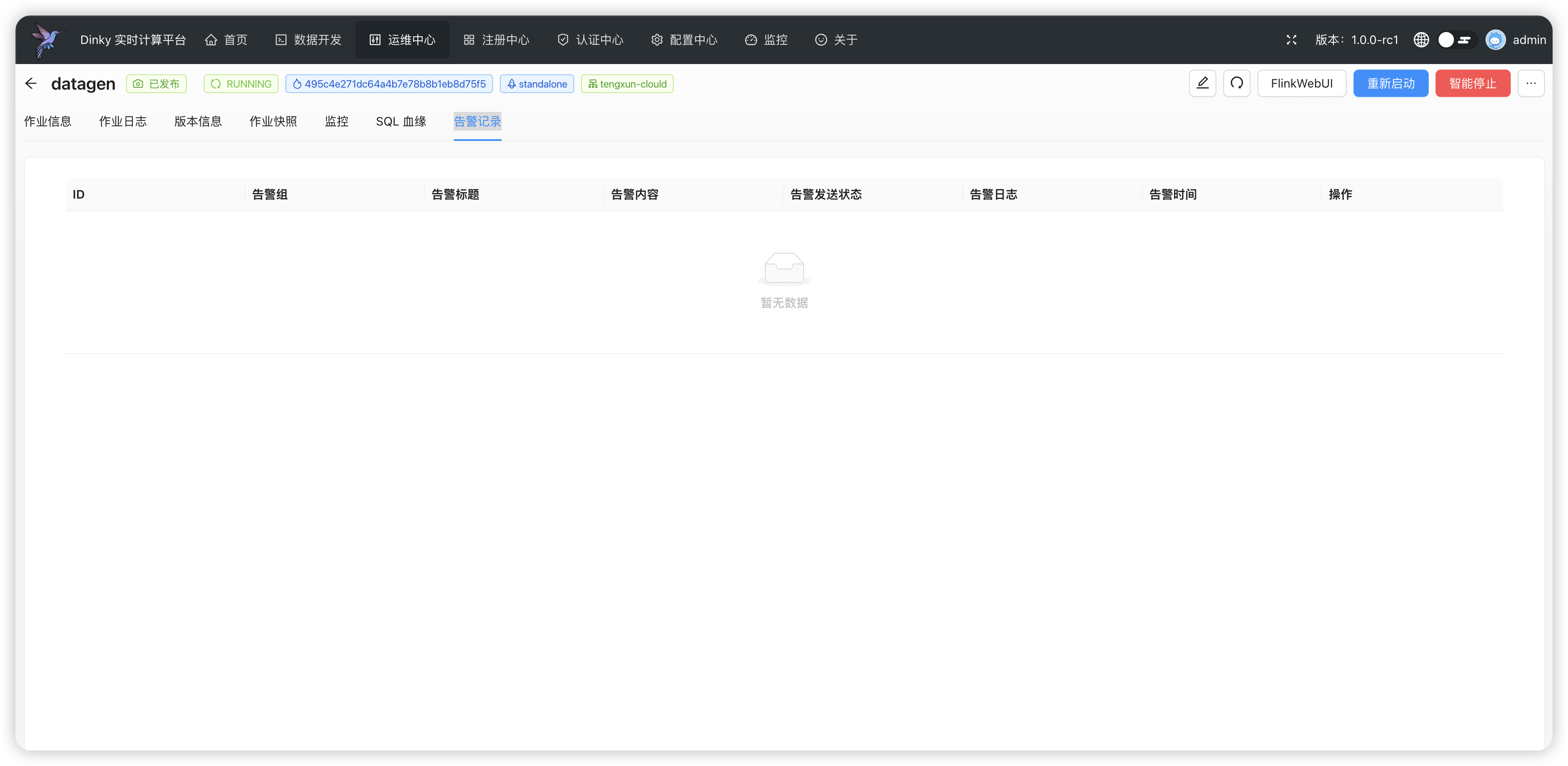

.../user_guide/devops_center/job_details.md | 112 ++++++

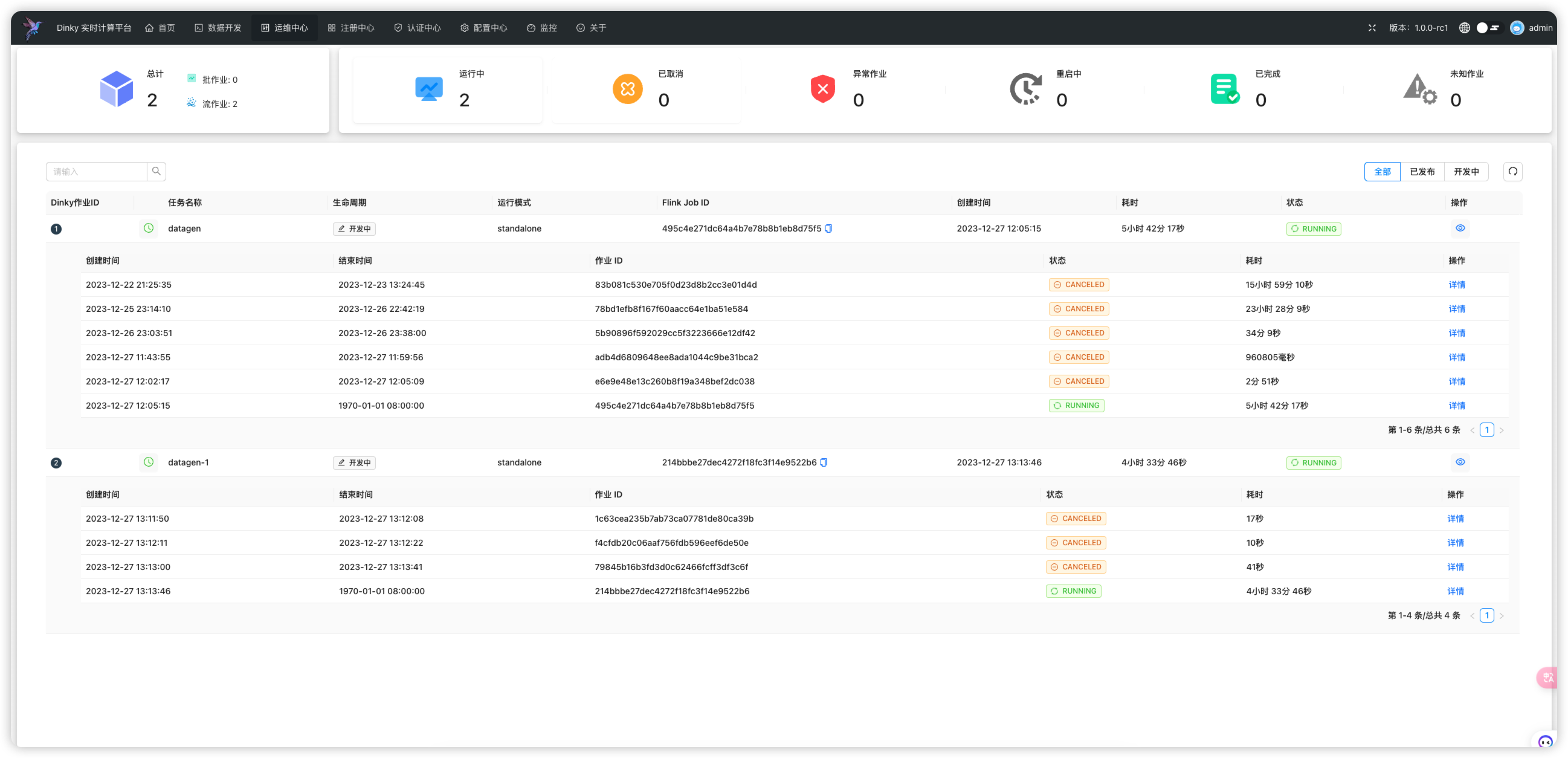

.../user_guide/devops_center/job_overview.md | 55 +++

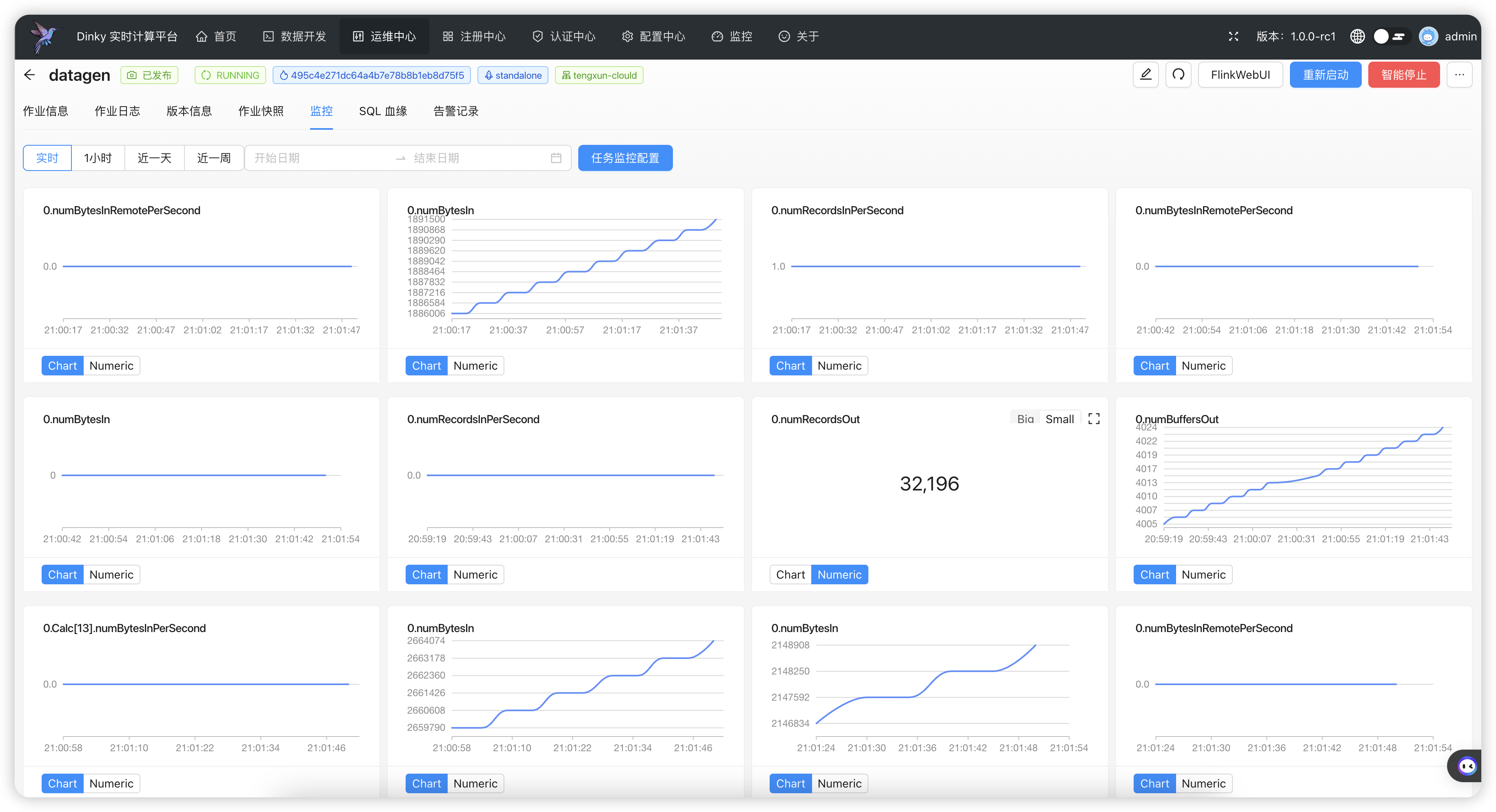

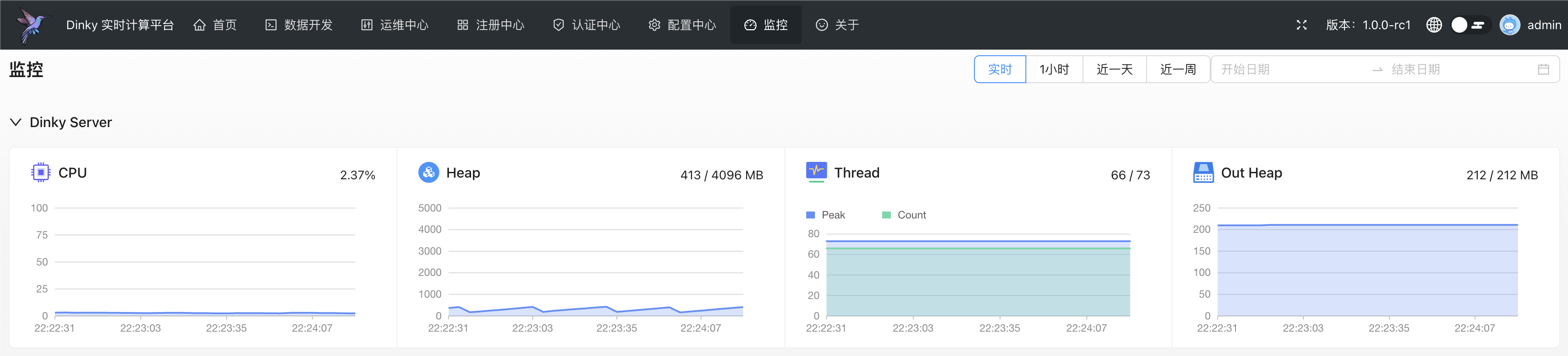

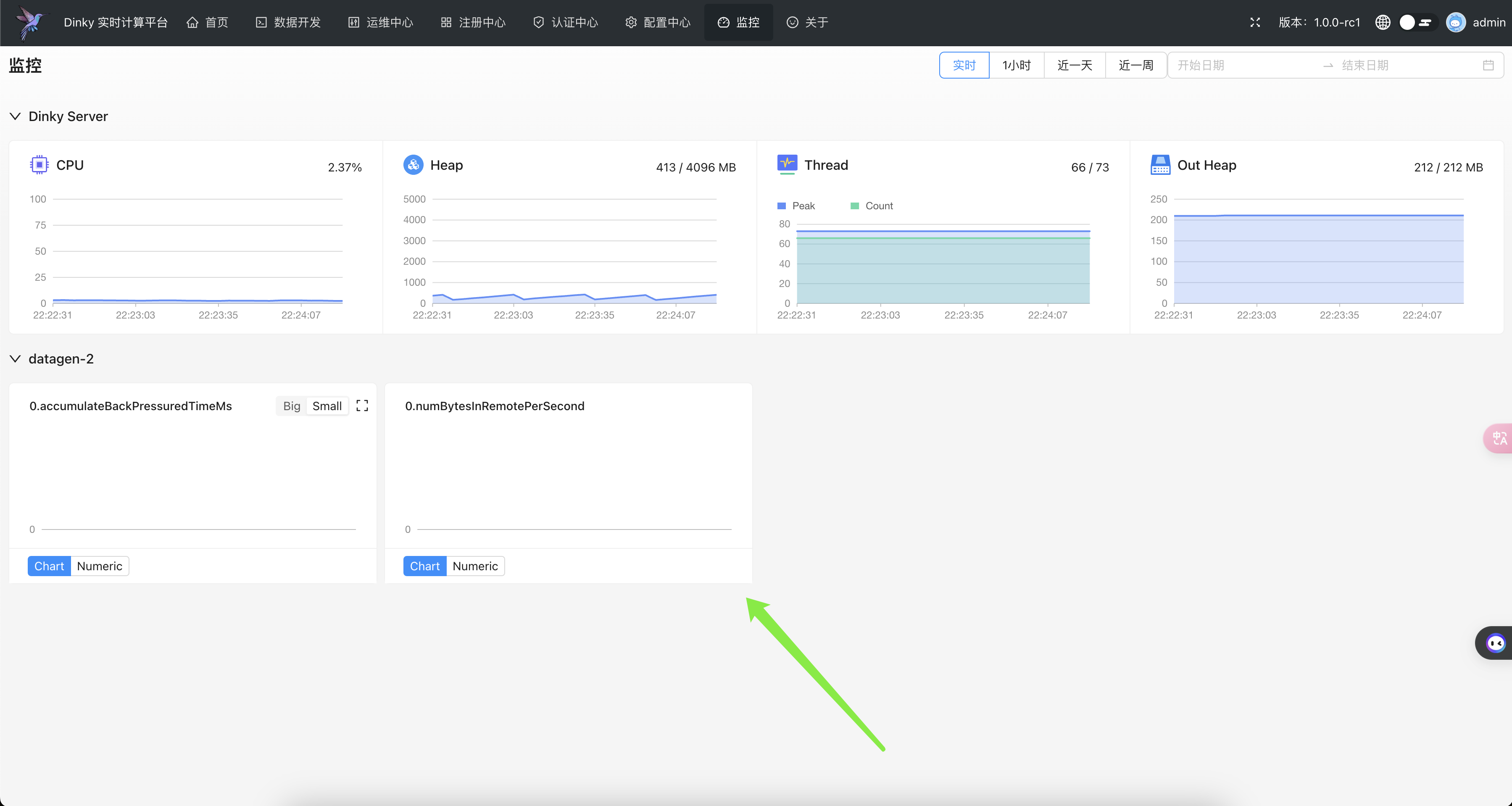

.../user_guide/metrics_overview.md | 28 ++

.../register_center/_category_.json | 4 +

.../register_center/alert/_category_.json | 4 +

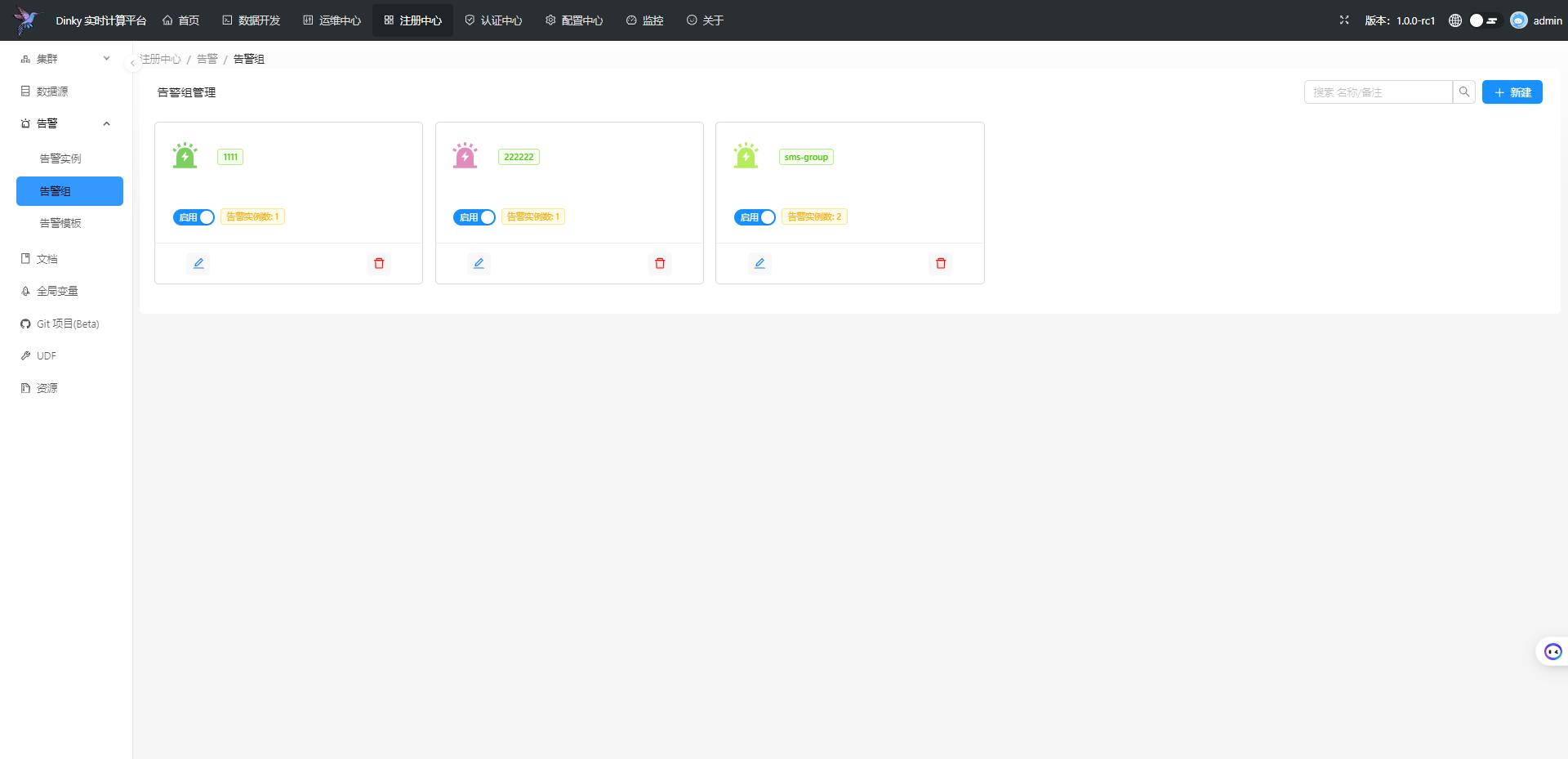

.../register_center/alert/alert_group.md | 27 ++

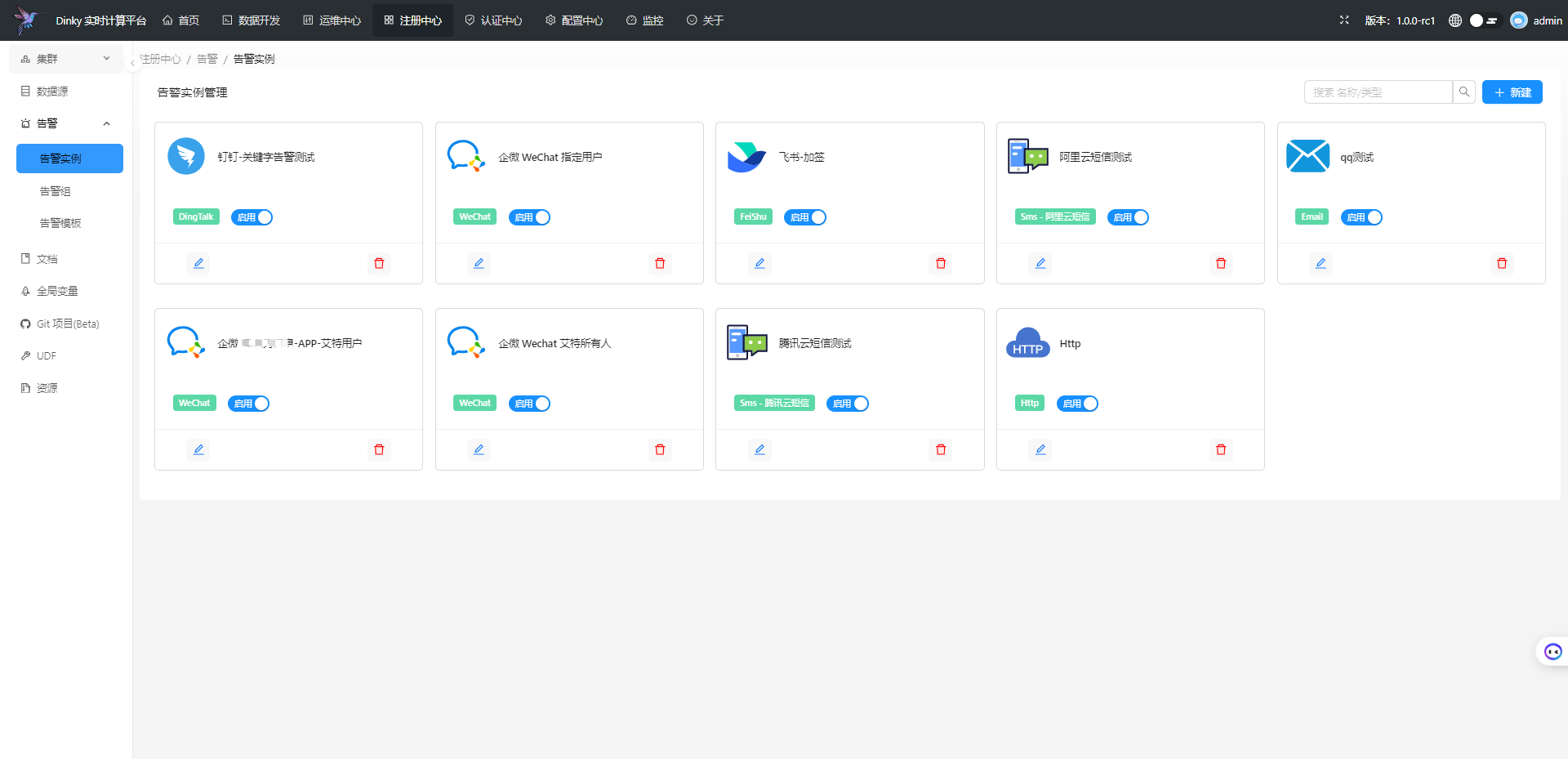

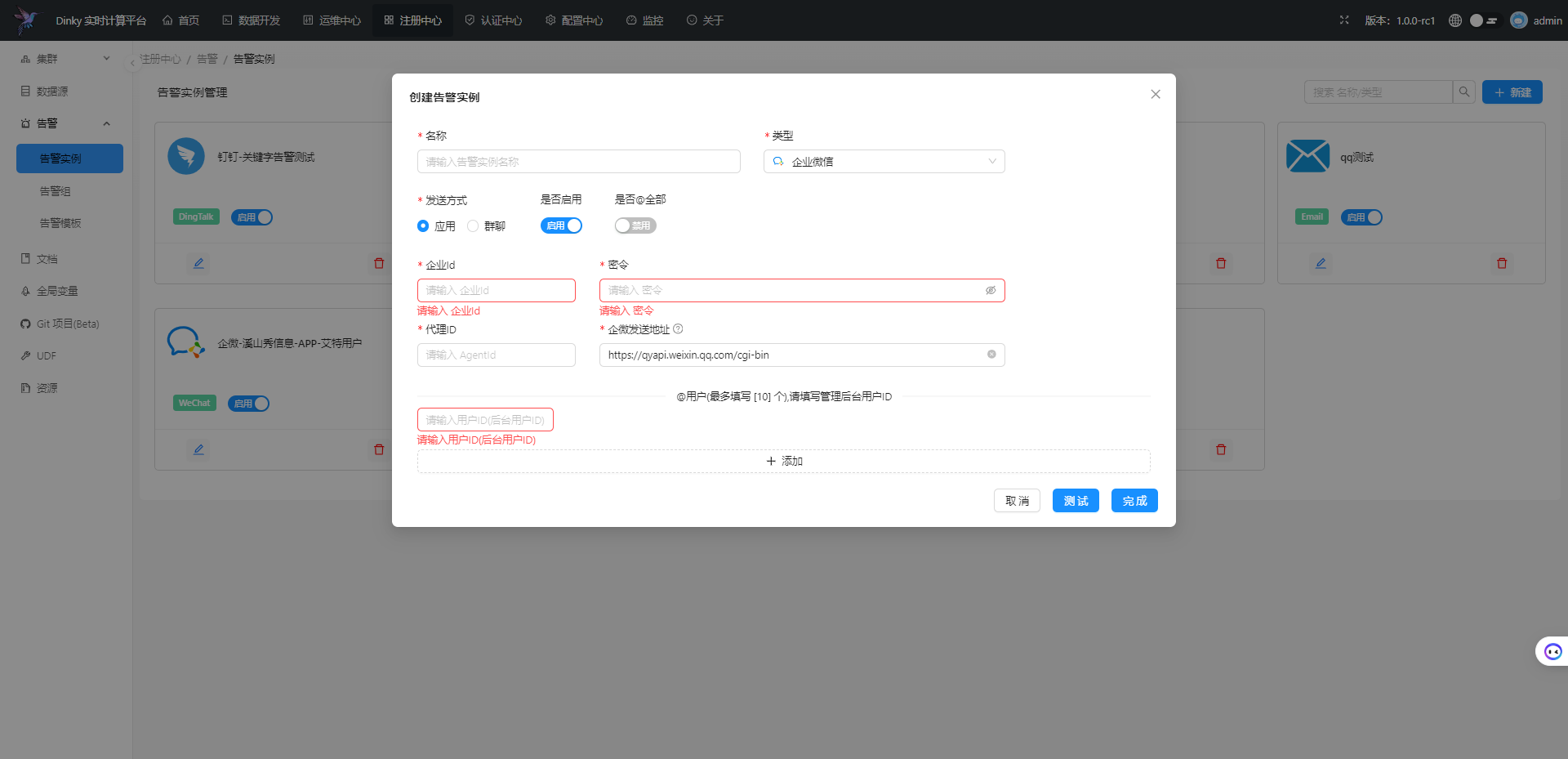

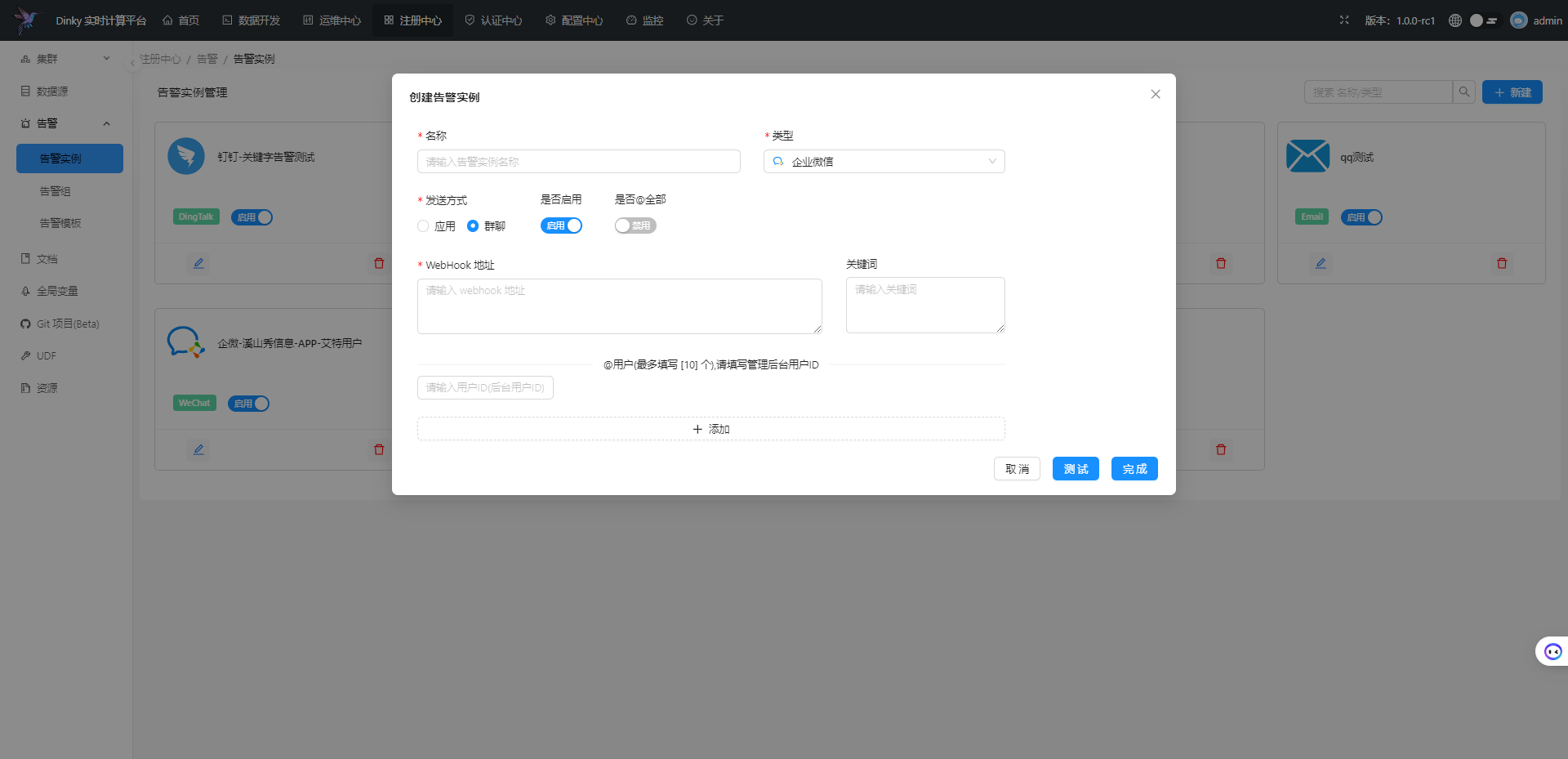

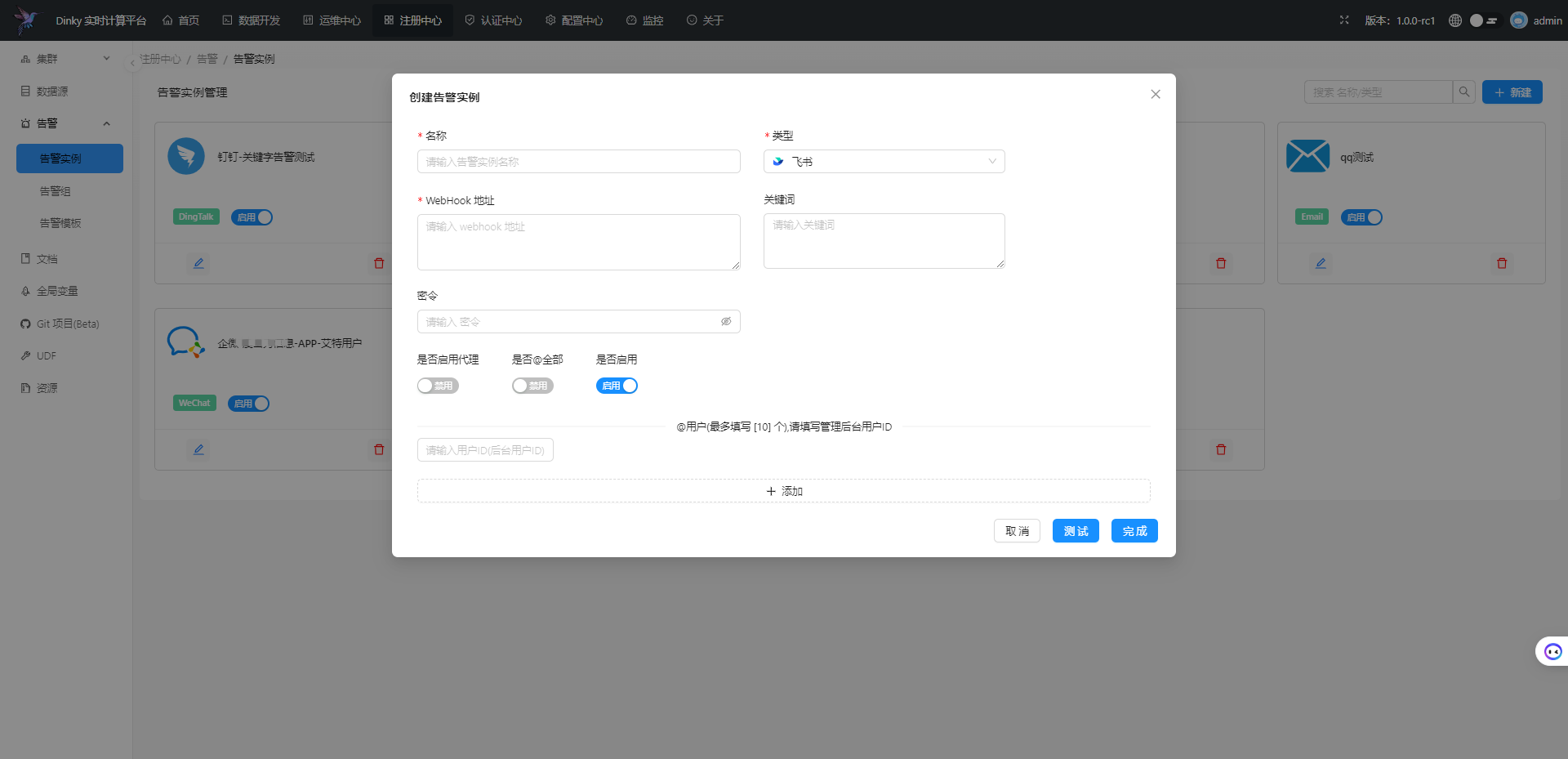

.../register_center/alert/alert_instance.md | 178 ++++++++

.../register_center/alert/alert_overview.md | 36 ++

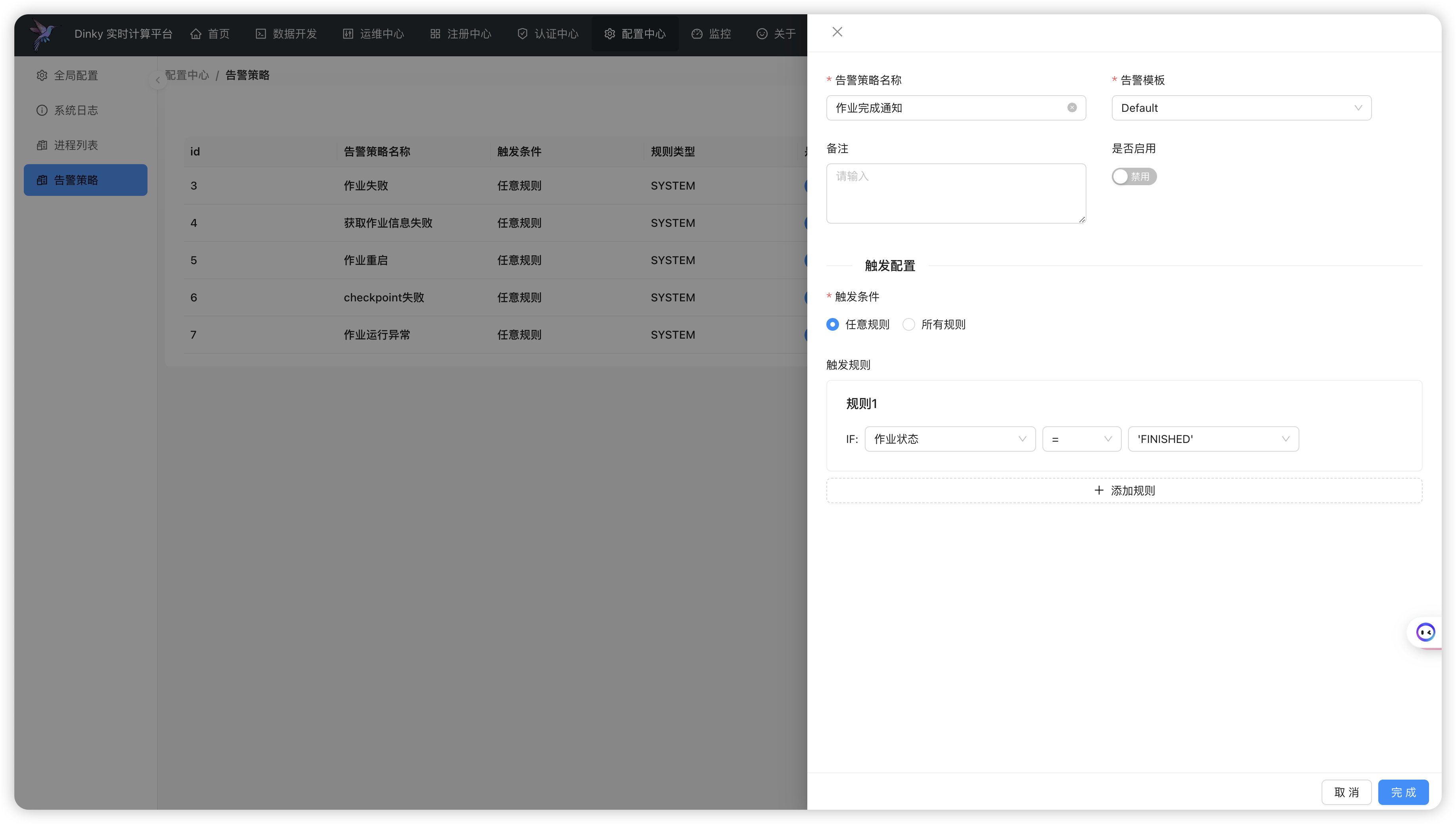

.../register_center/alert/alert_strategy.md | 50 +++

.../register_center/alert/alert_template.md | 56 +++

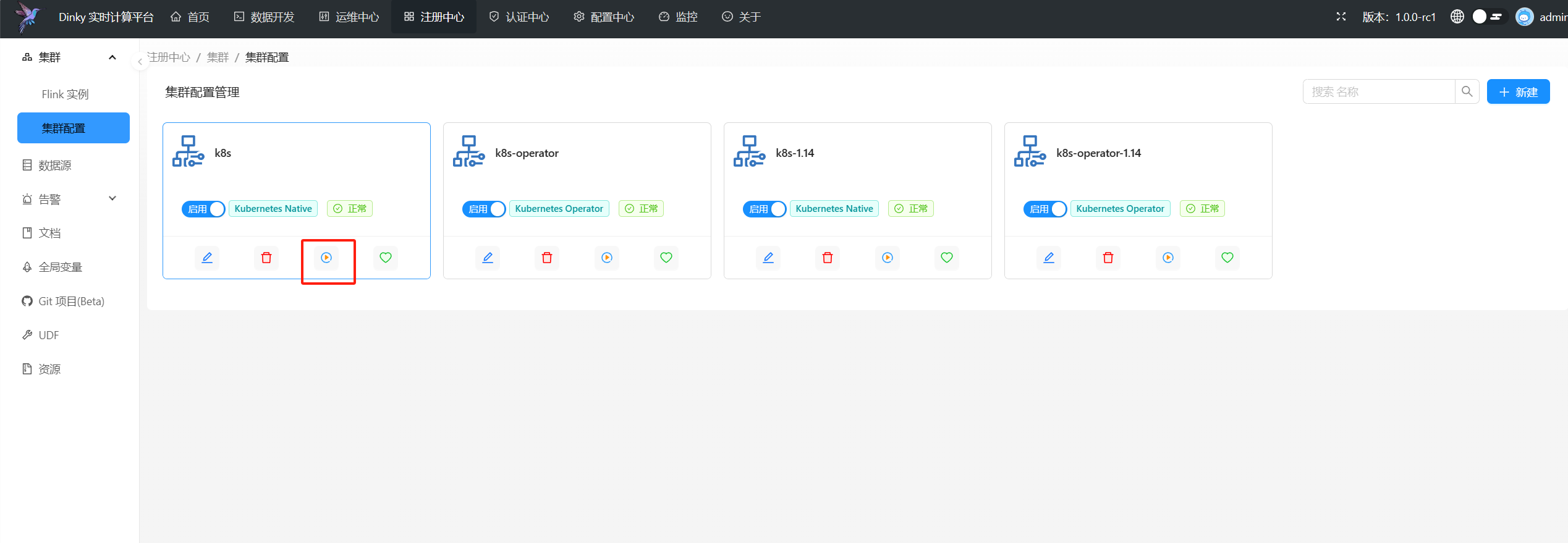

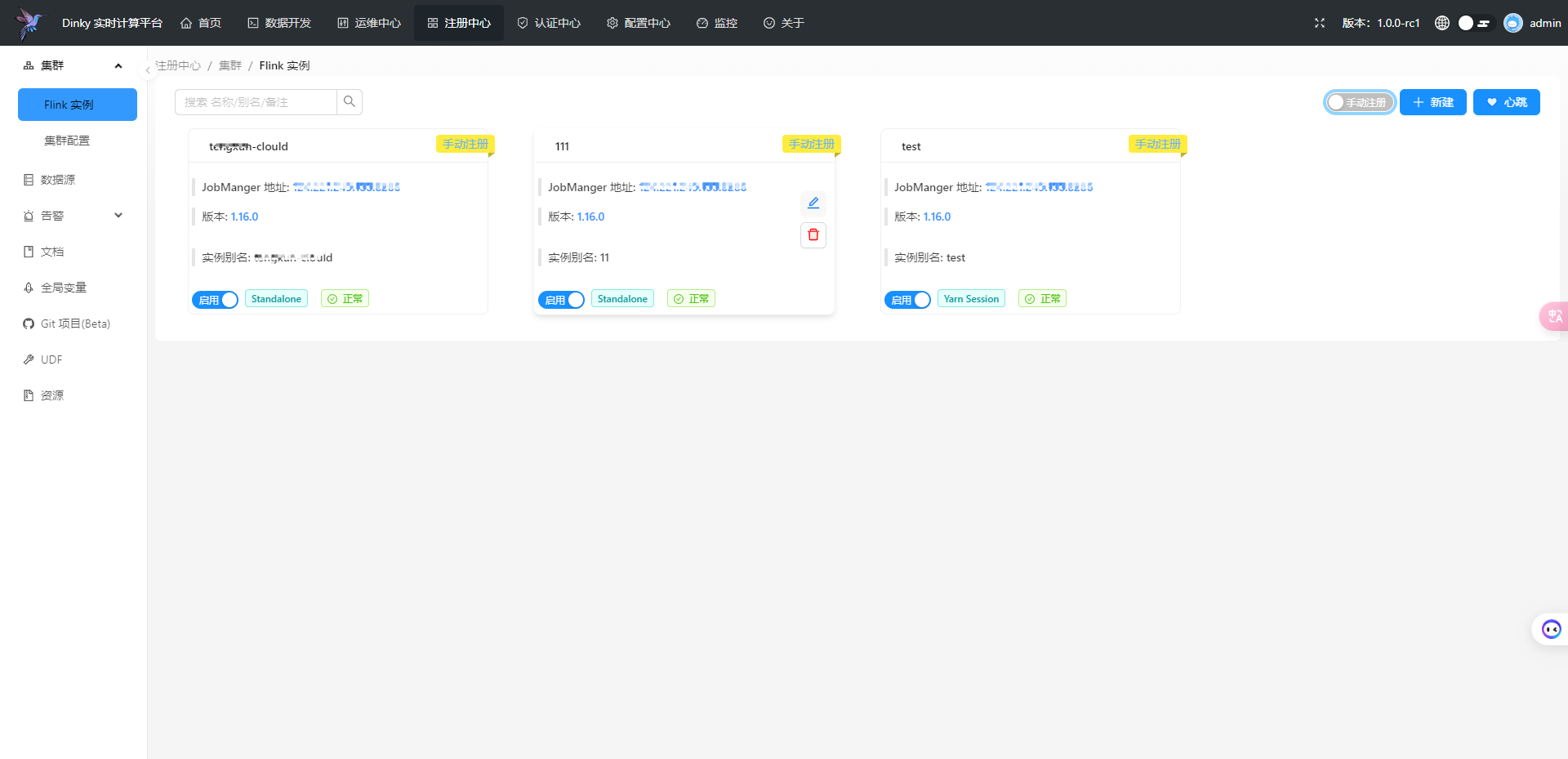

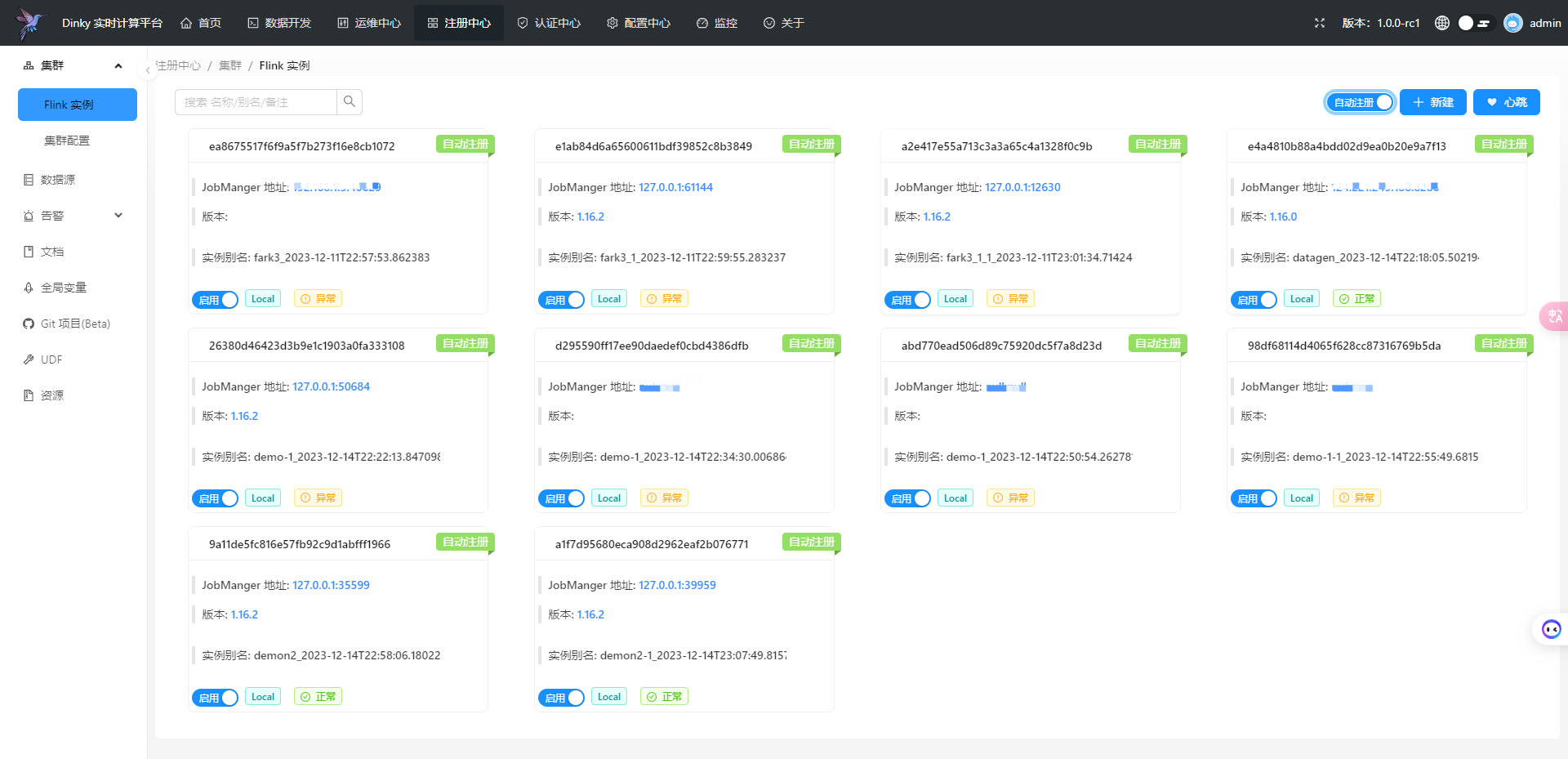

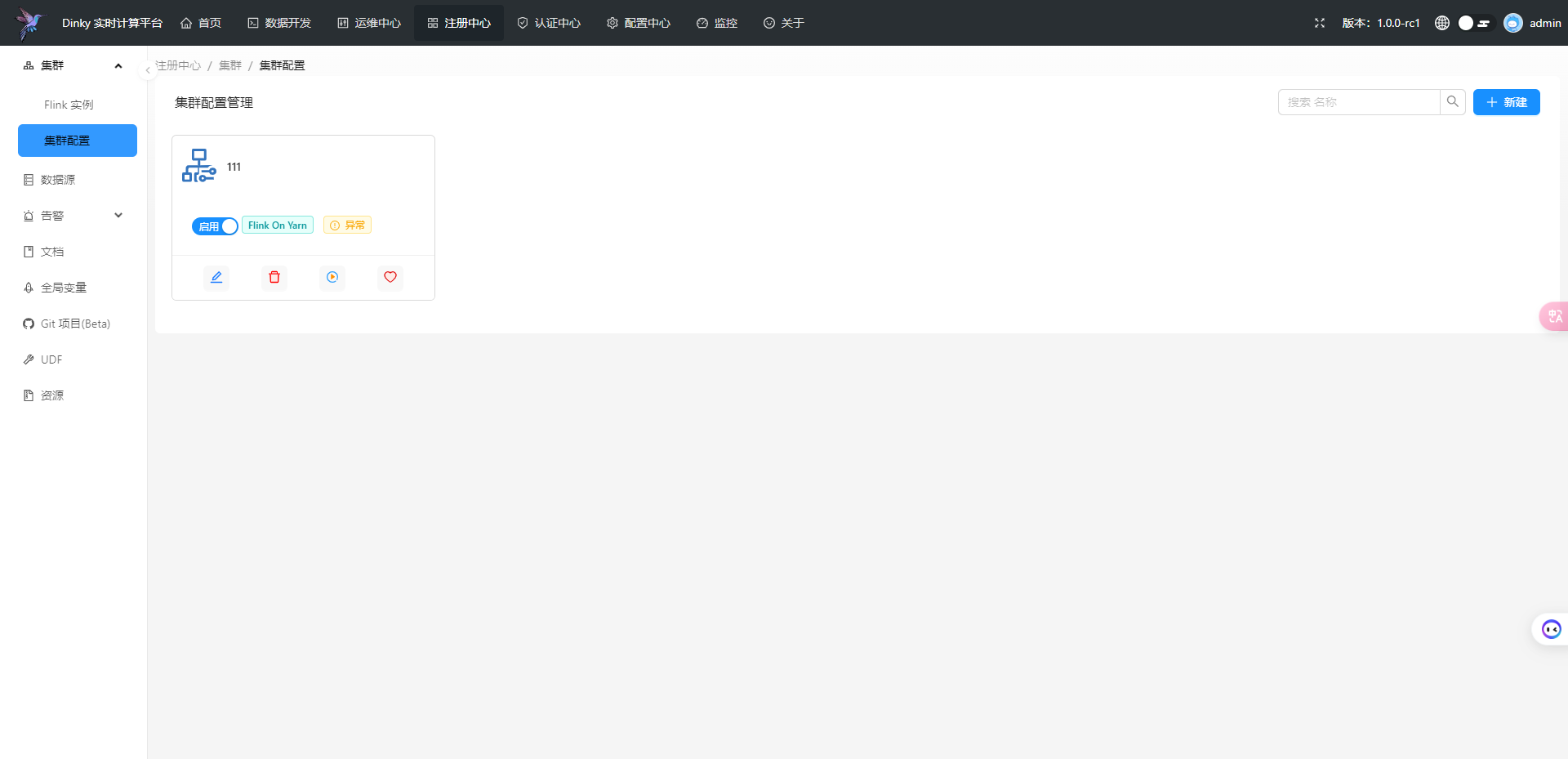

.../register_center/cluster_manage.md | 165 ++++++++

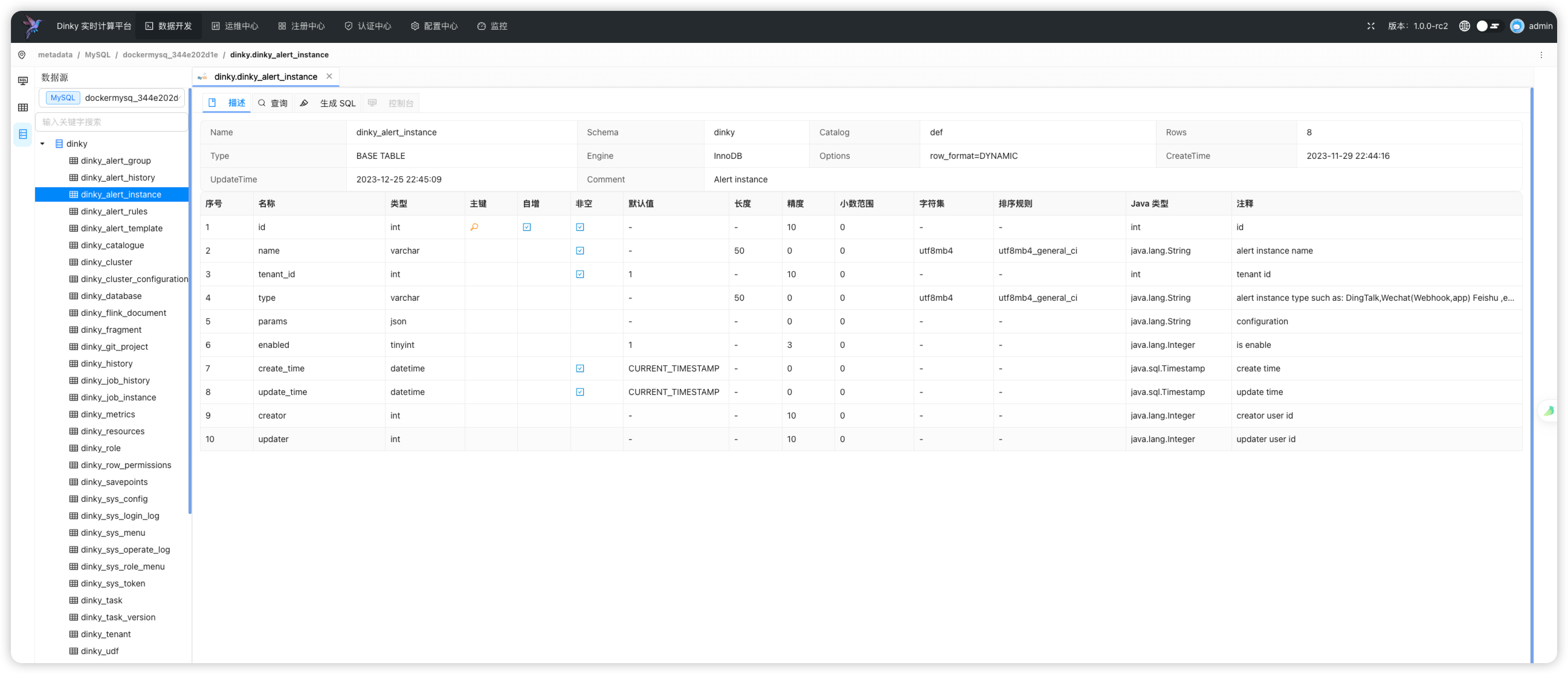

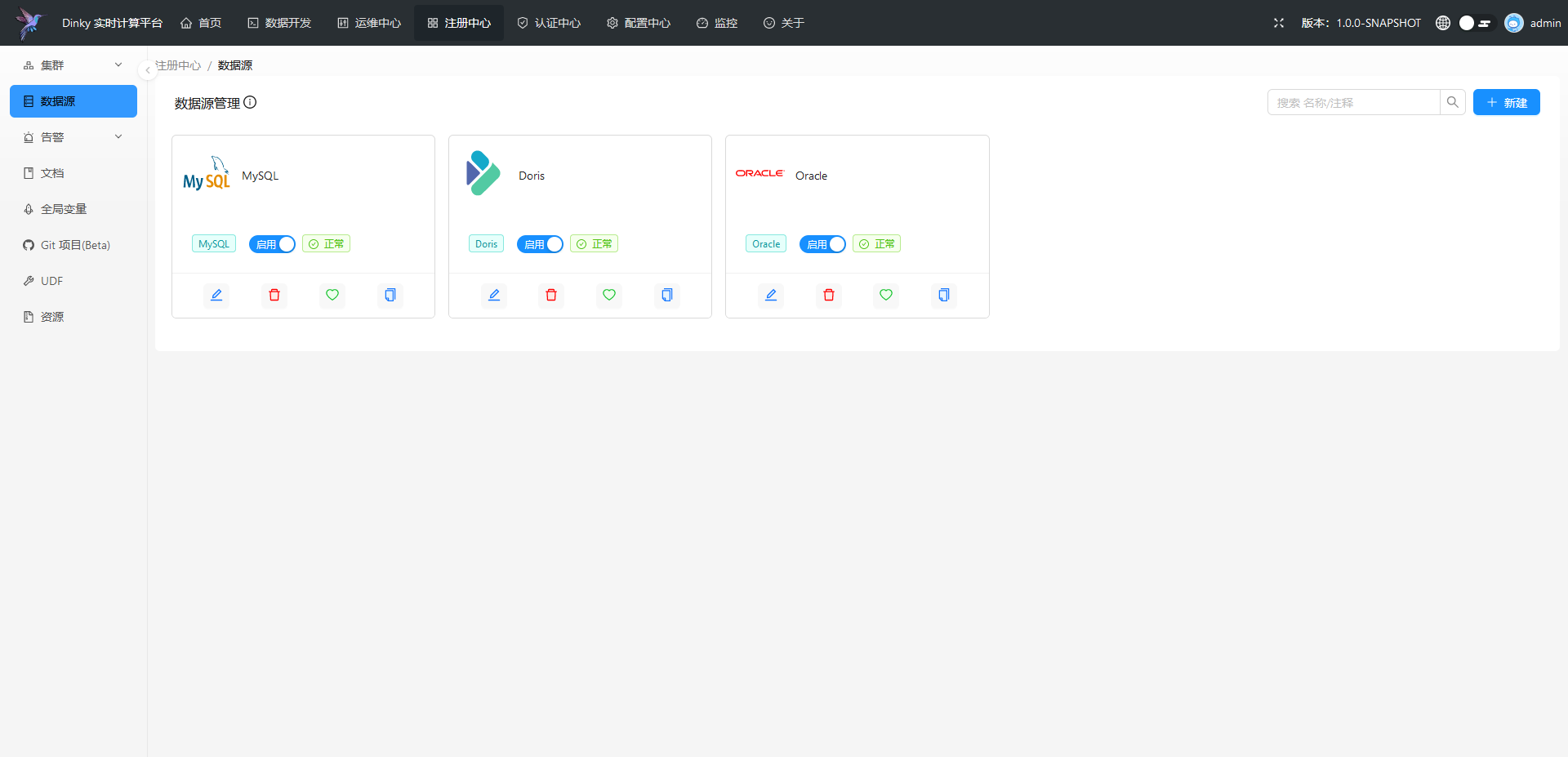

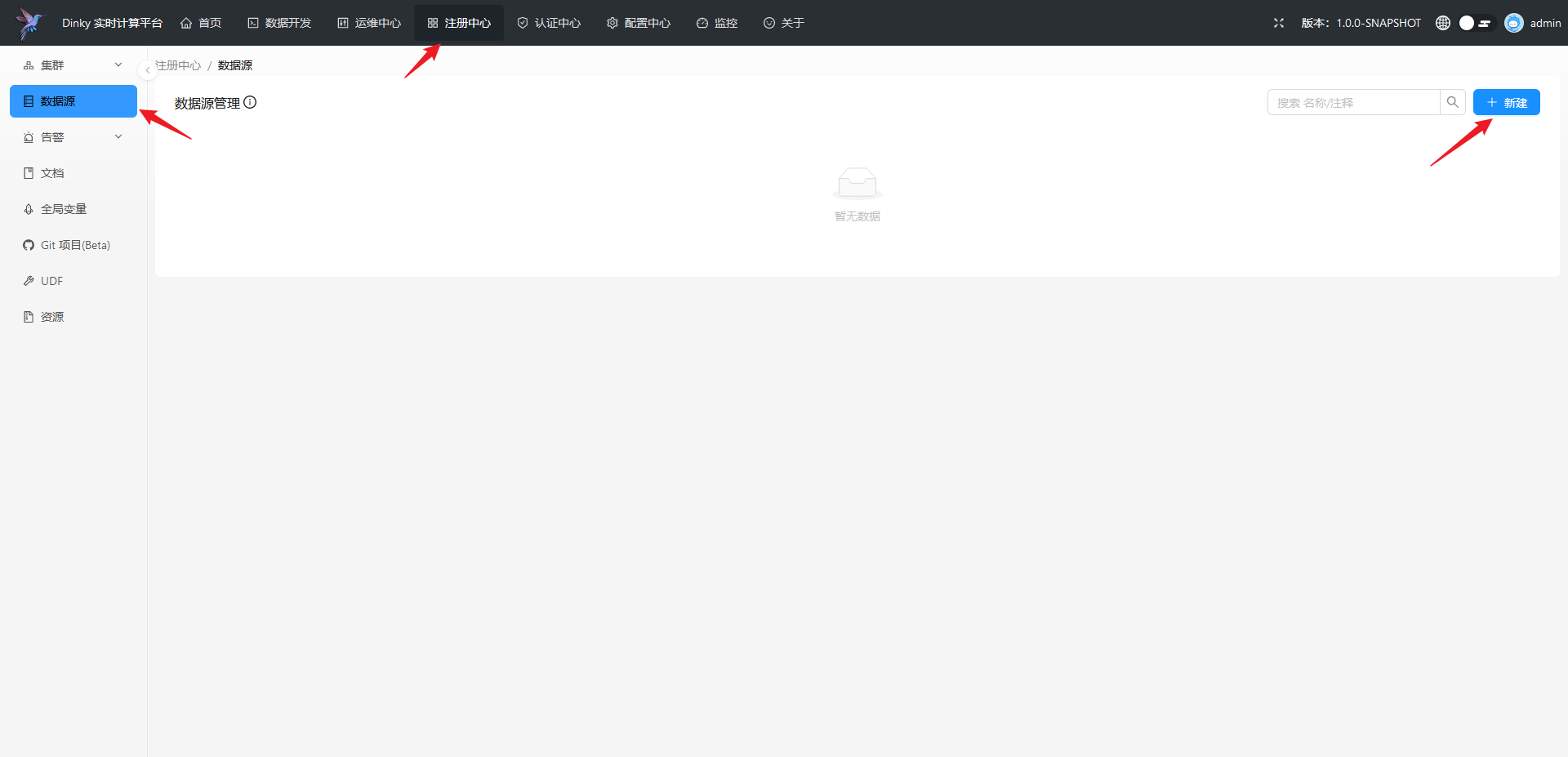

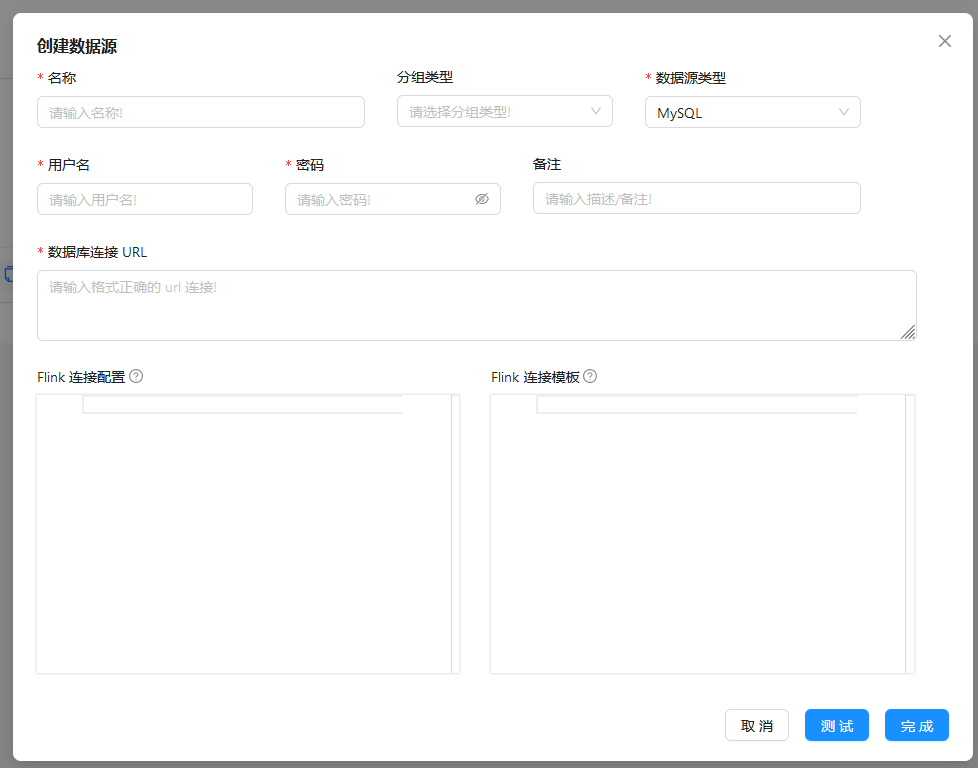

.../register_center/datasource_manage.md | 133 ++++++

.../register_center/document_manager.md | 42 ++

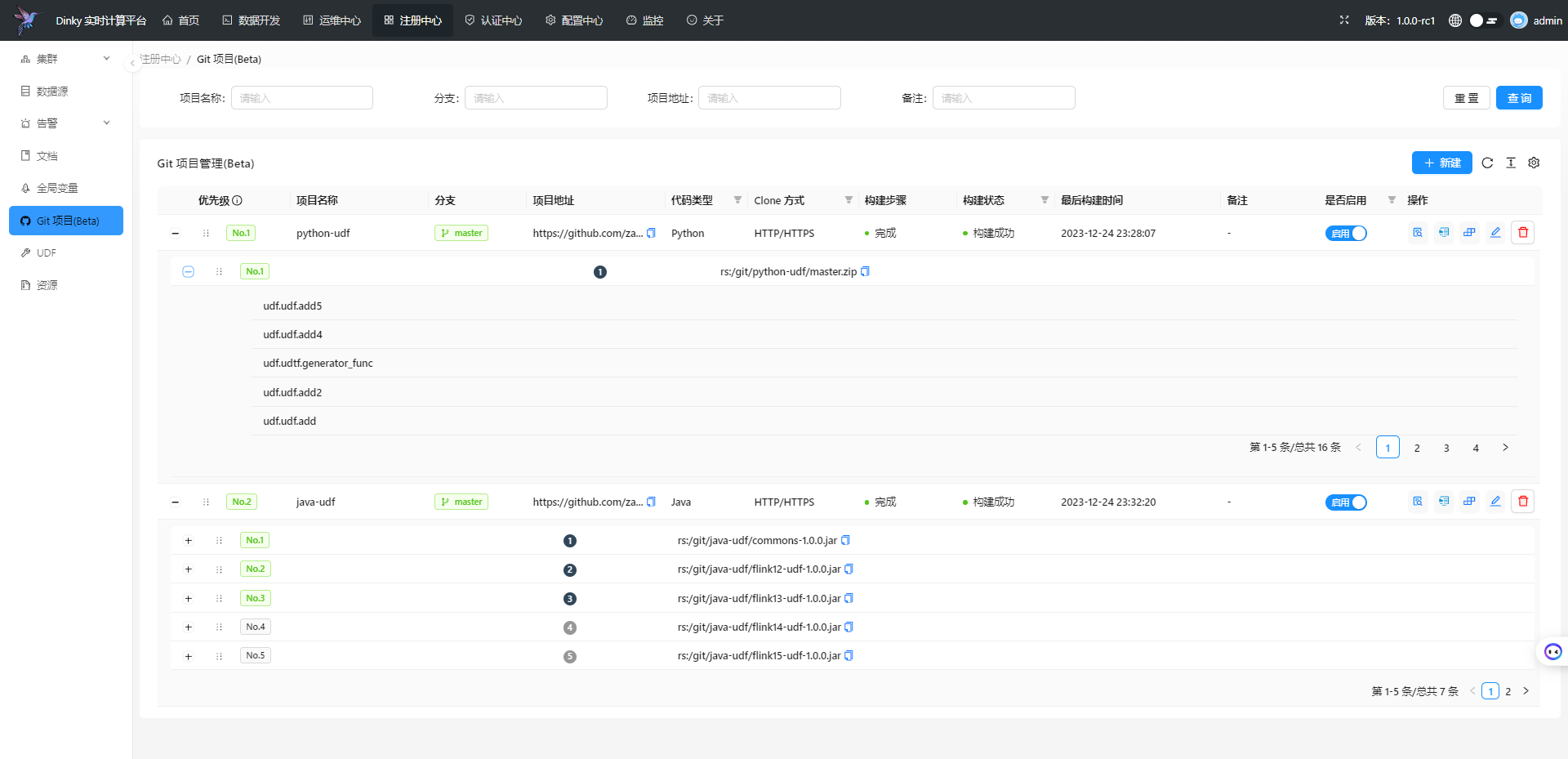

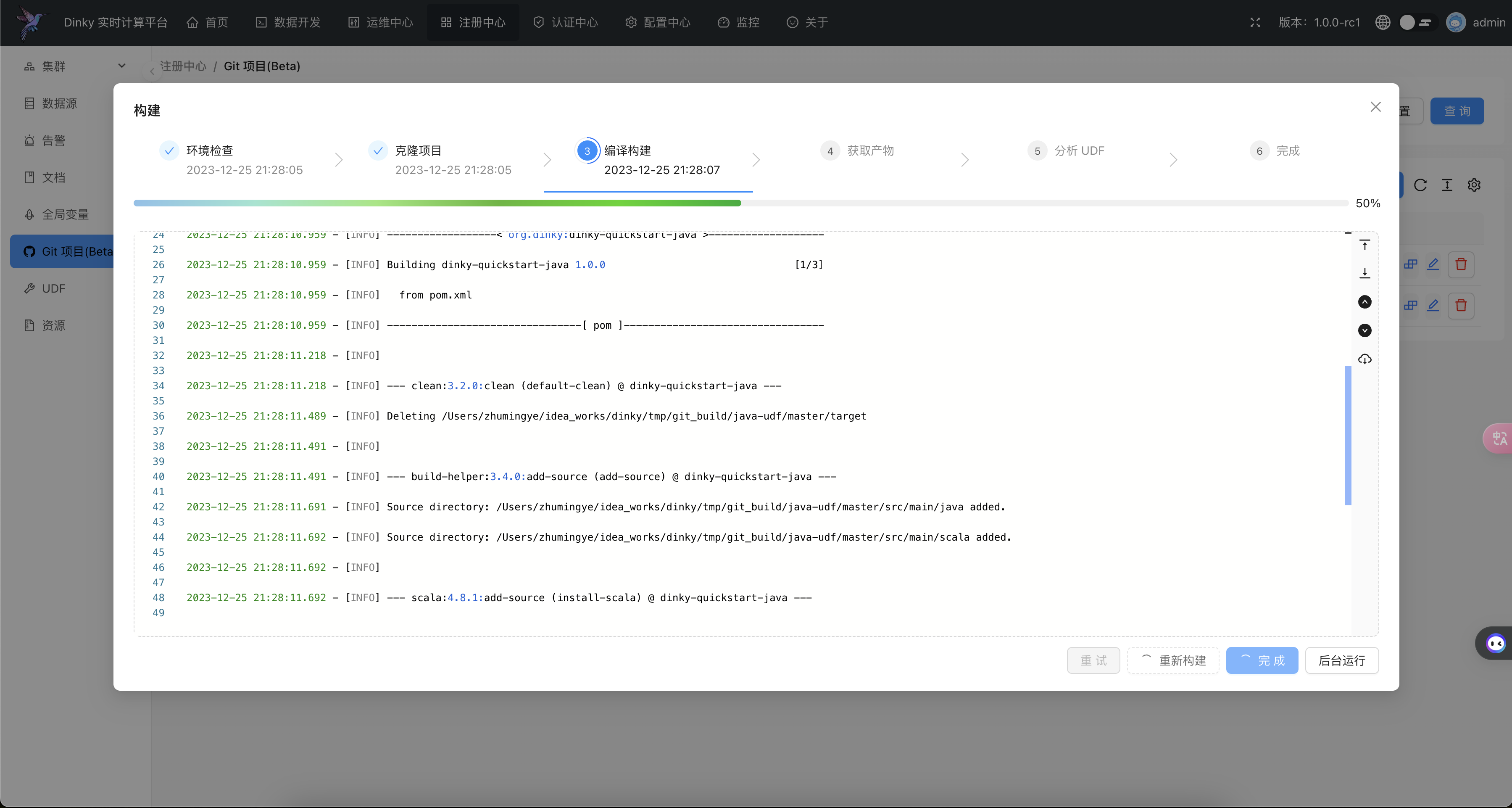

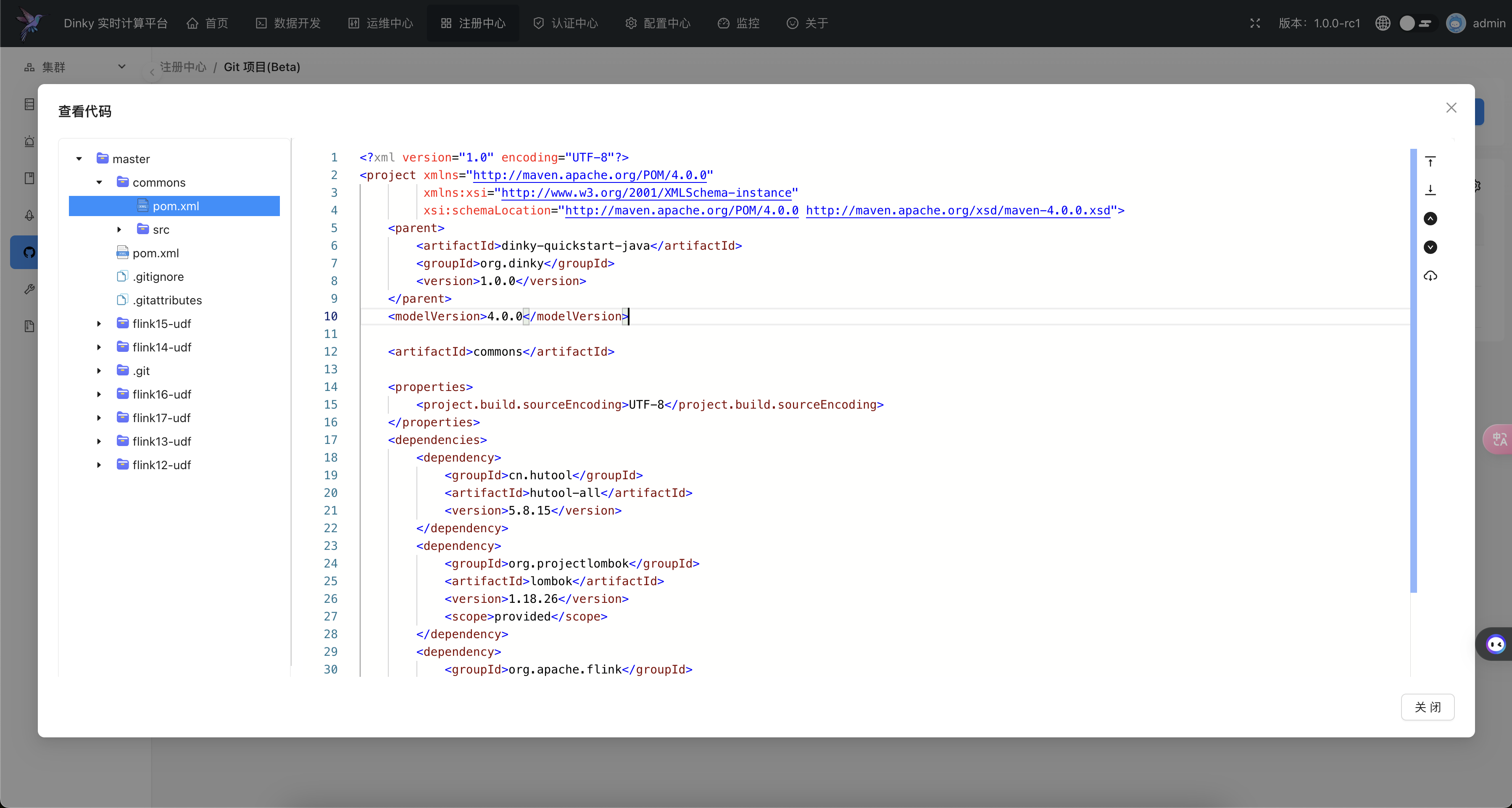

.../user_guide/register_center/git_project.md | 38 ++

.../user_guide/register_center/global_var.md | 173 ++++++++

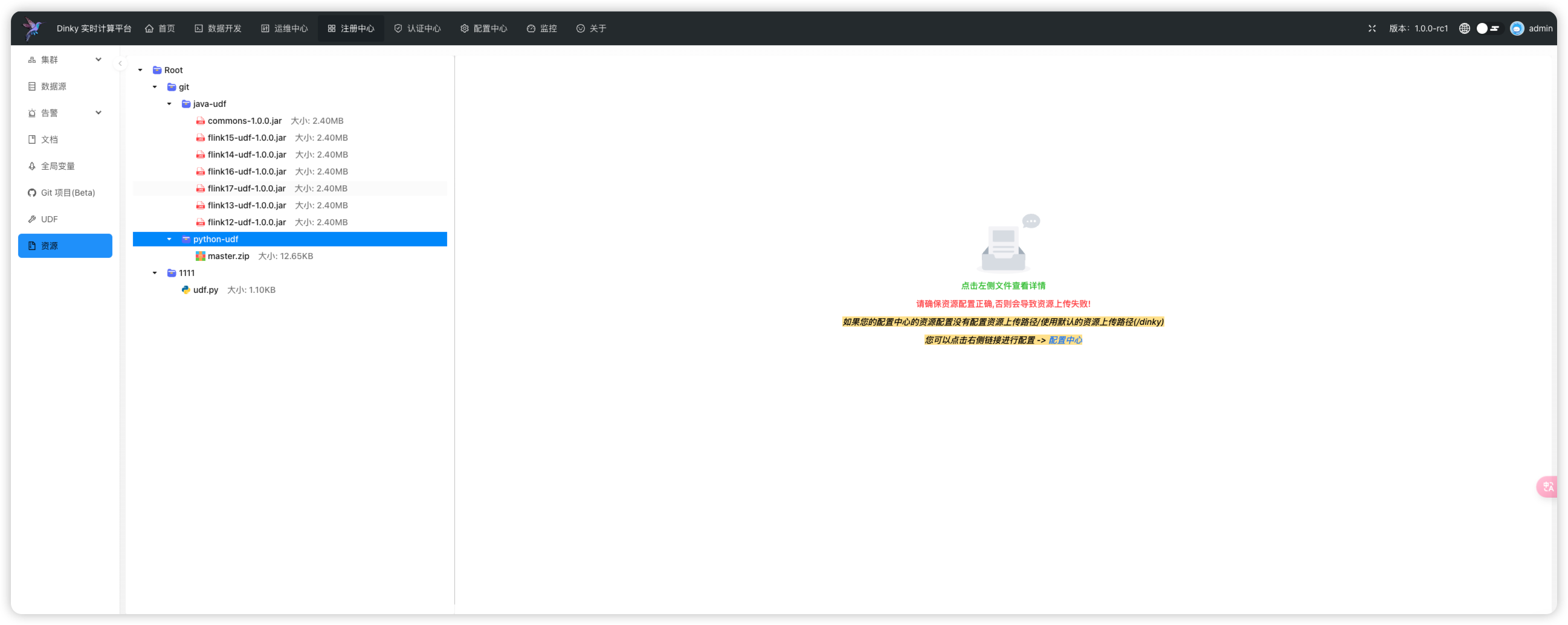

.../user_guide/register_center/resource.md | 50 +++

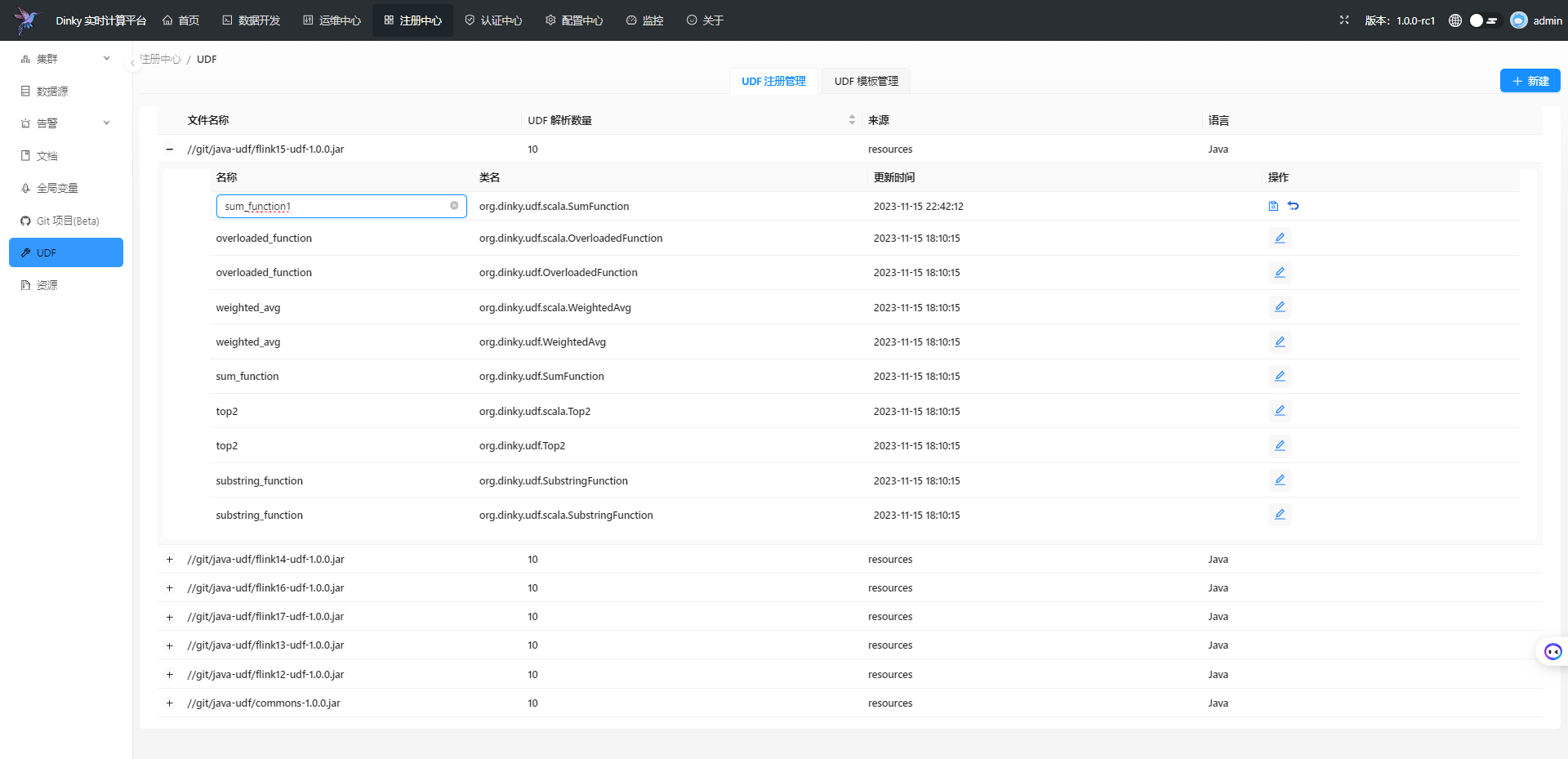

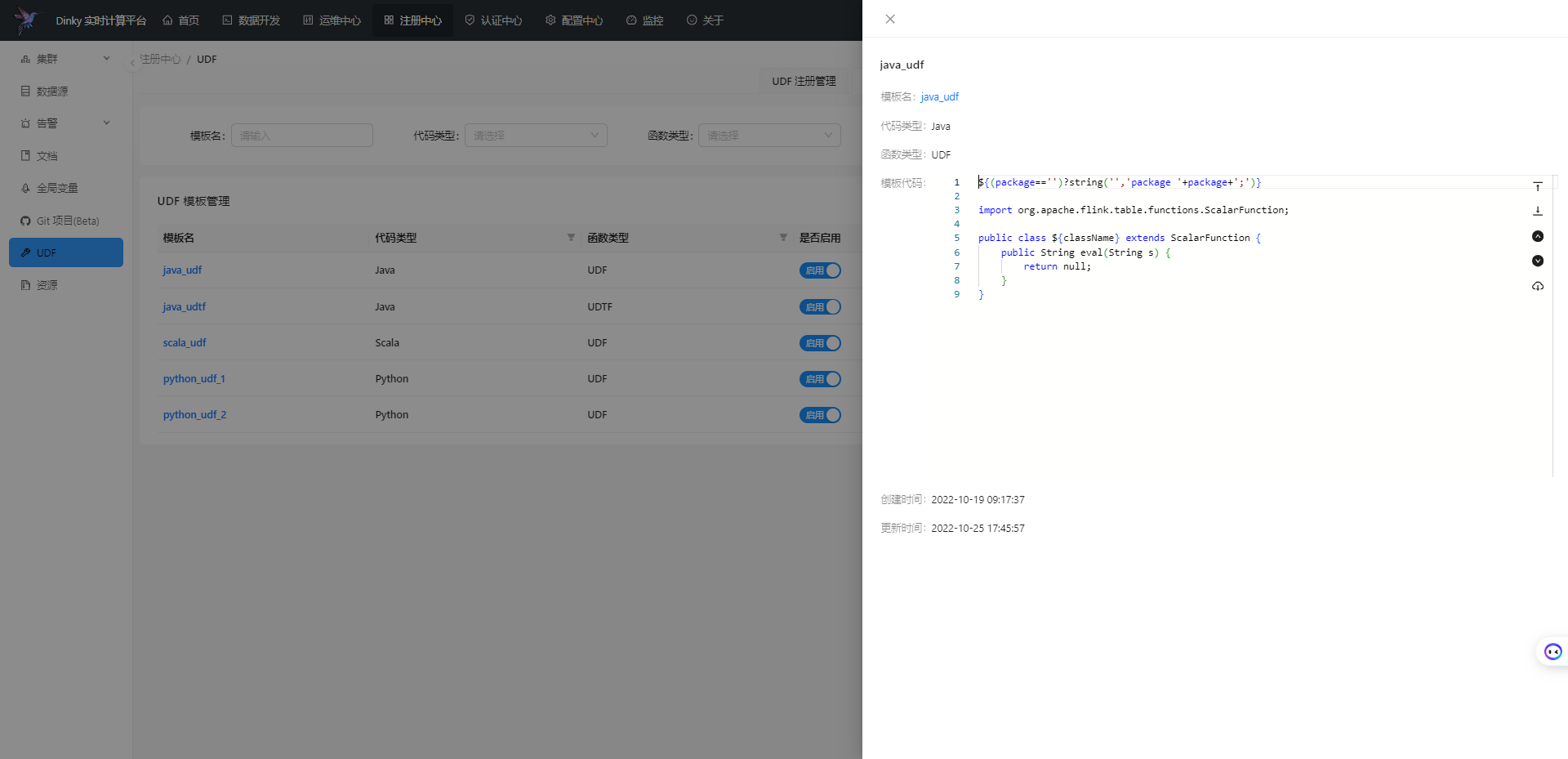

.../user_guide/register_center/udf.md | 35 ++

.../user_guide/studio/_category_.json | 4 +

.../version-1.0/user_guide/studio/catalog.md | 6 +

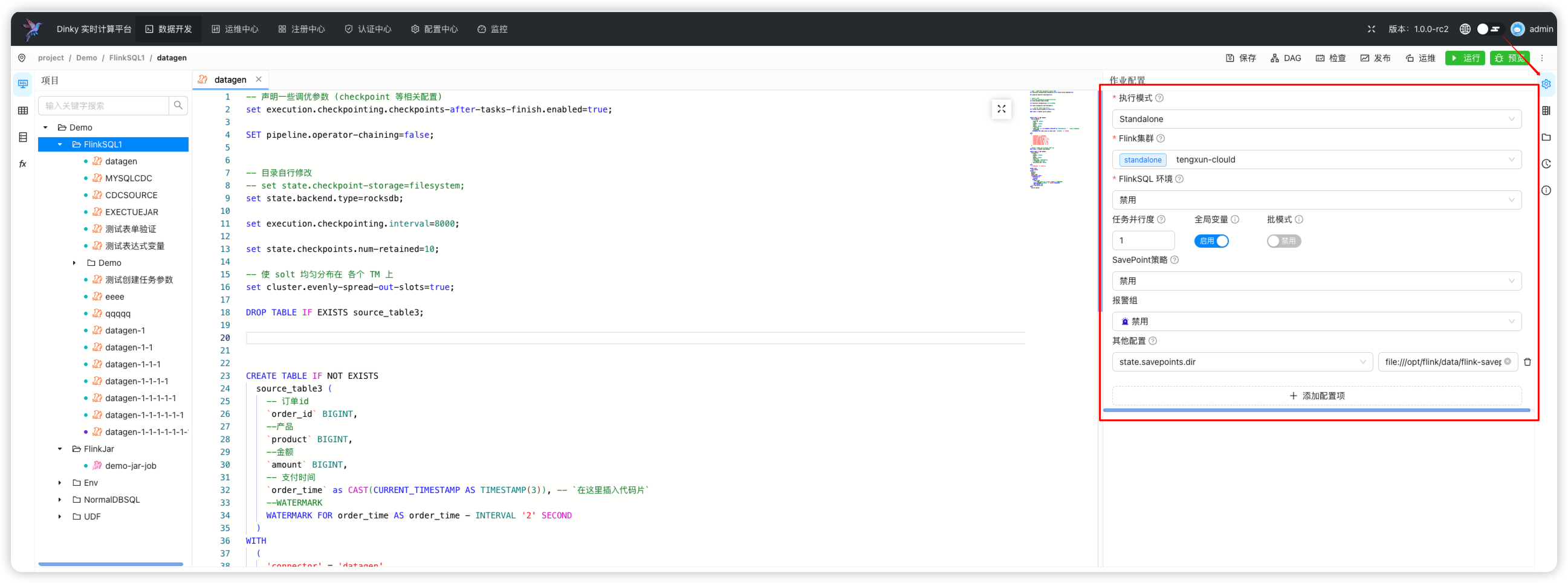

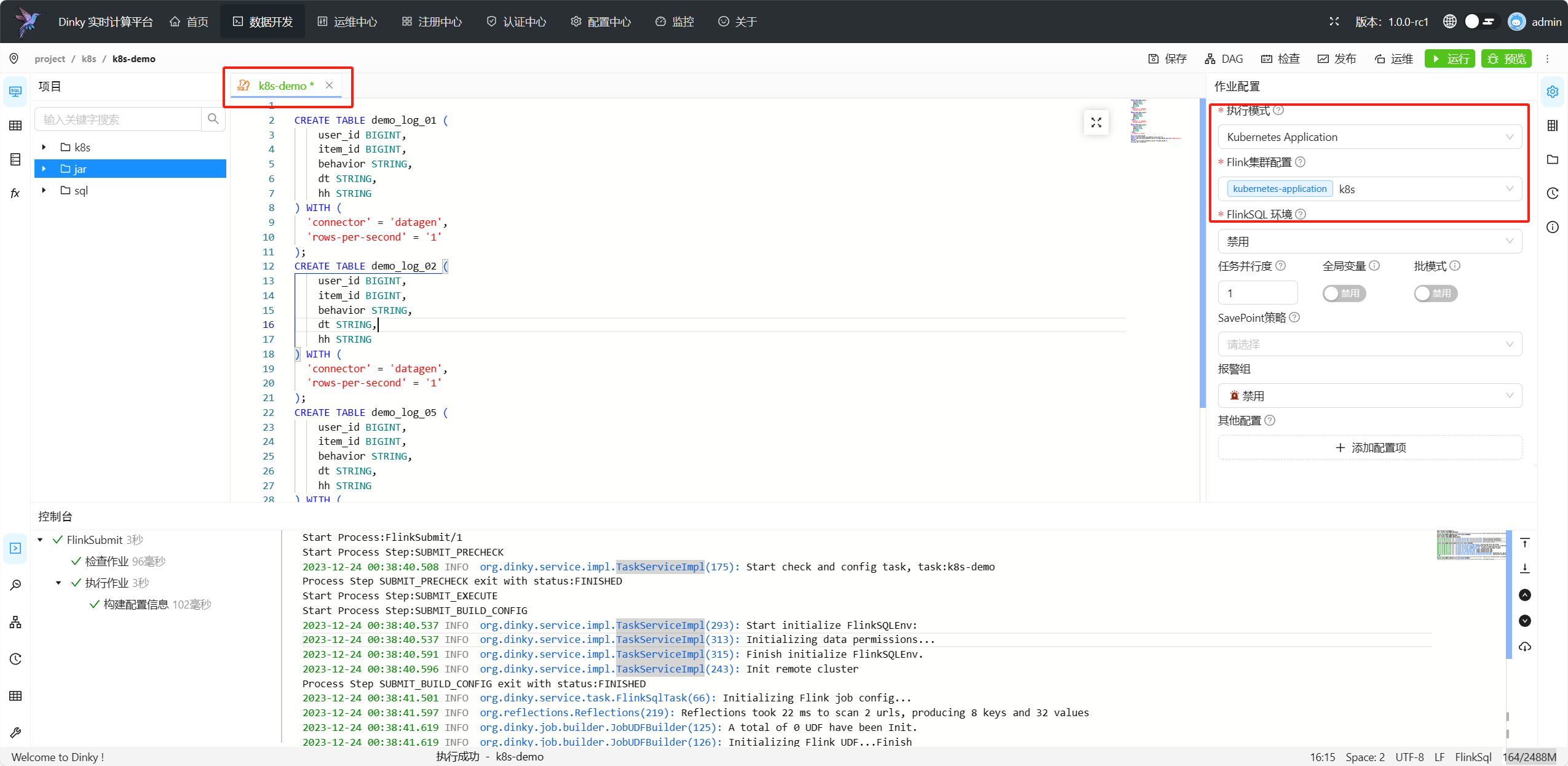

.../user_guide/studio/execute_env_config.md | 164 ++++++++

.../studio/flink_env_task_devlop.md | 6 +

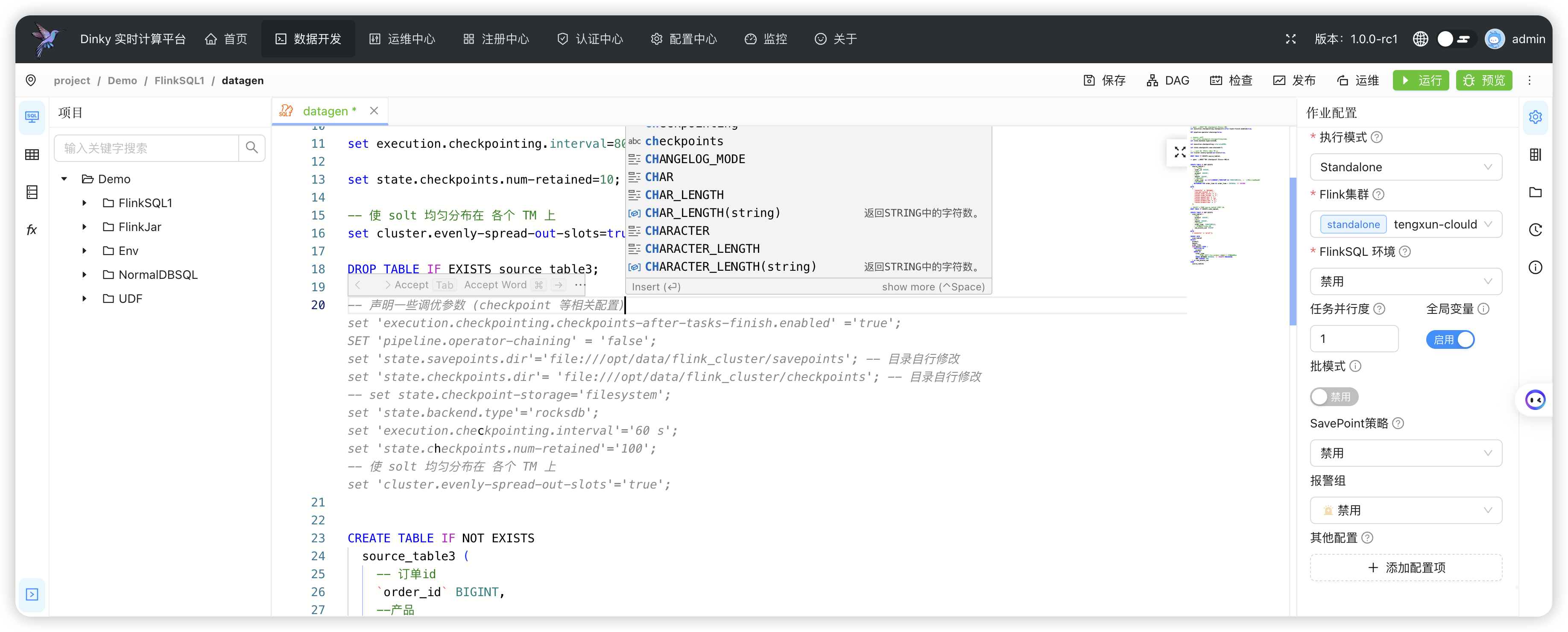

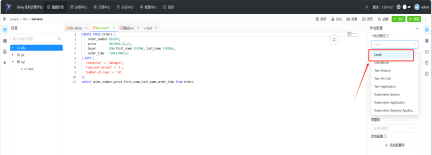

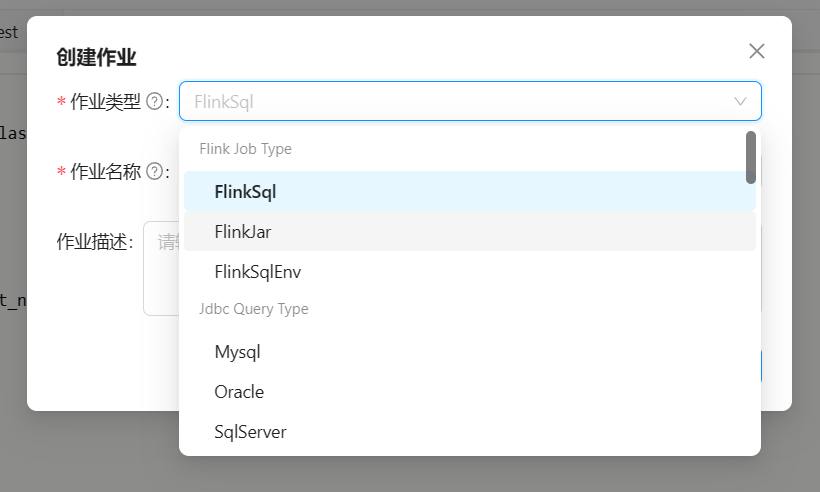

.../studio/flink_sql_task_devlop.md | 201 ++++++++++

.../user_guide/studio/jdbc_task_devlop.md | 6 +

.../user_guide/studio/studio_overview.md | 53 +++

.../user_guide/system_setting/_category_.json | 4 +

.../global_settings/_category_.json | 4 +

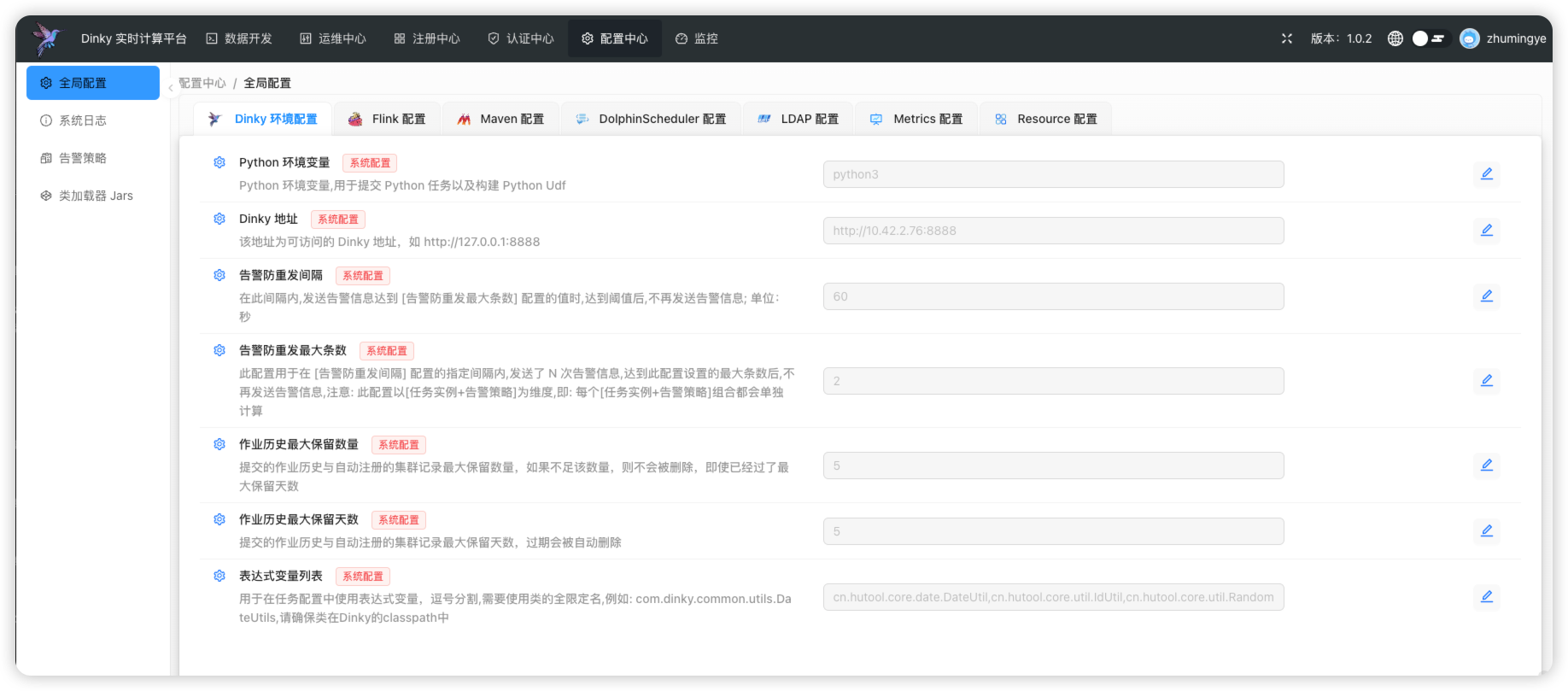

.../global_settings/dinky_setting.md | 32 ++

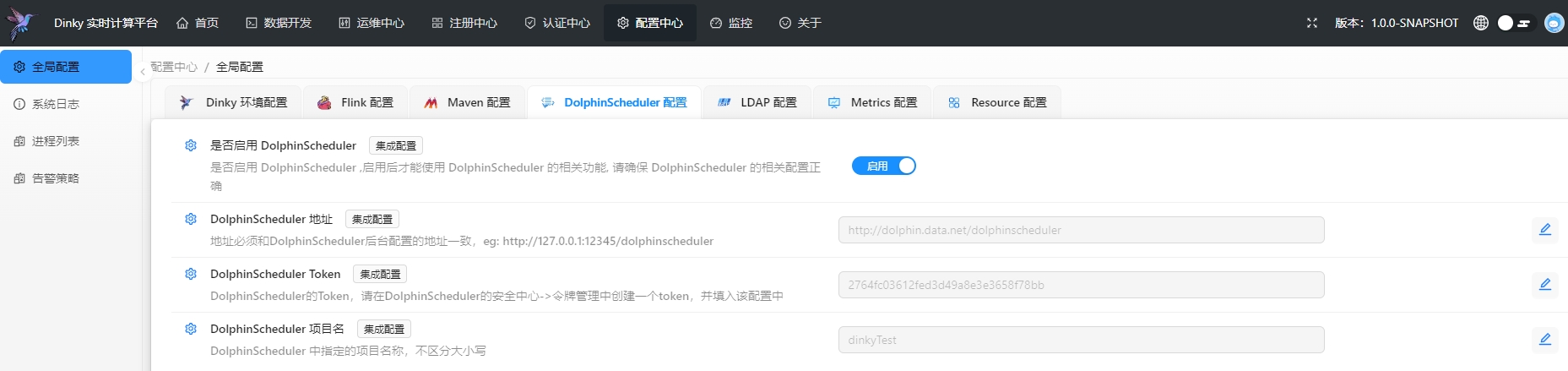

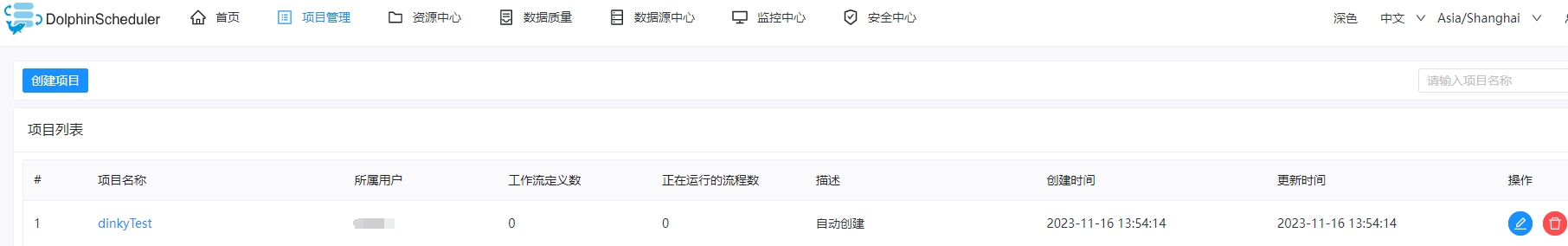

.../dolphinscheduler_setting.md | 50 +++

.../global_settings/flink_setting.md | 28 ++

.../system_setting/global_settings/ldap.md | 80 ++++

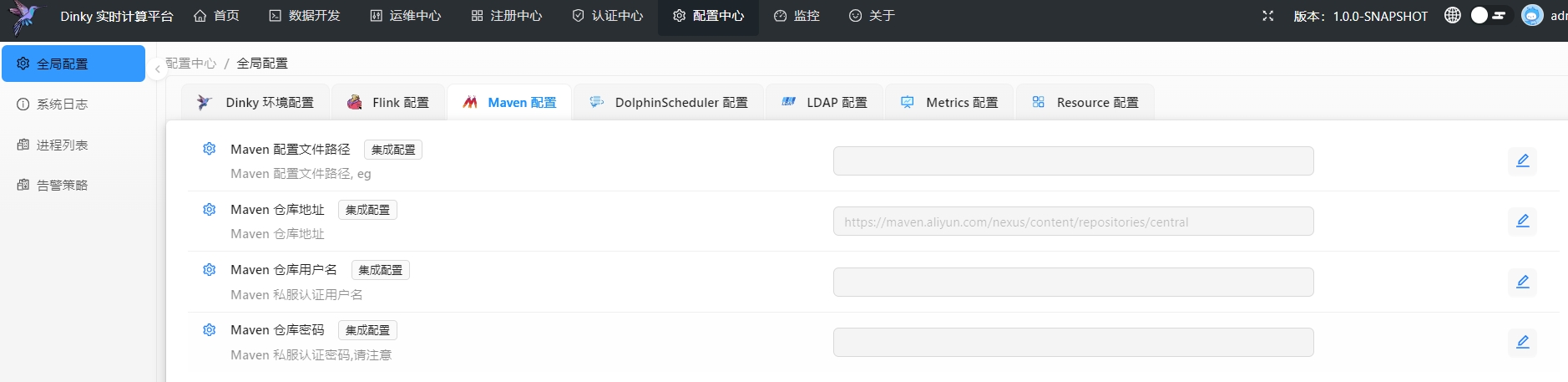

.../global_settings/maven_setting.md | 23 ++

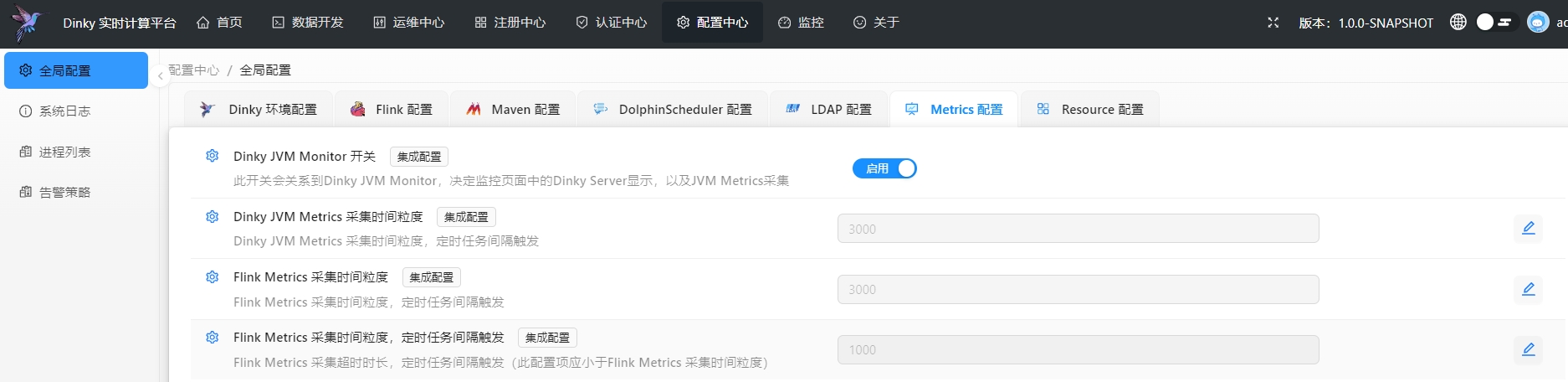

.../global_settings/metrics_setting.md | 25 ++

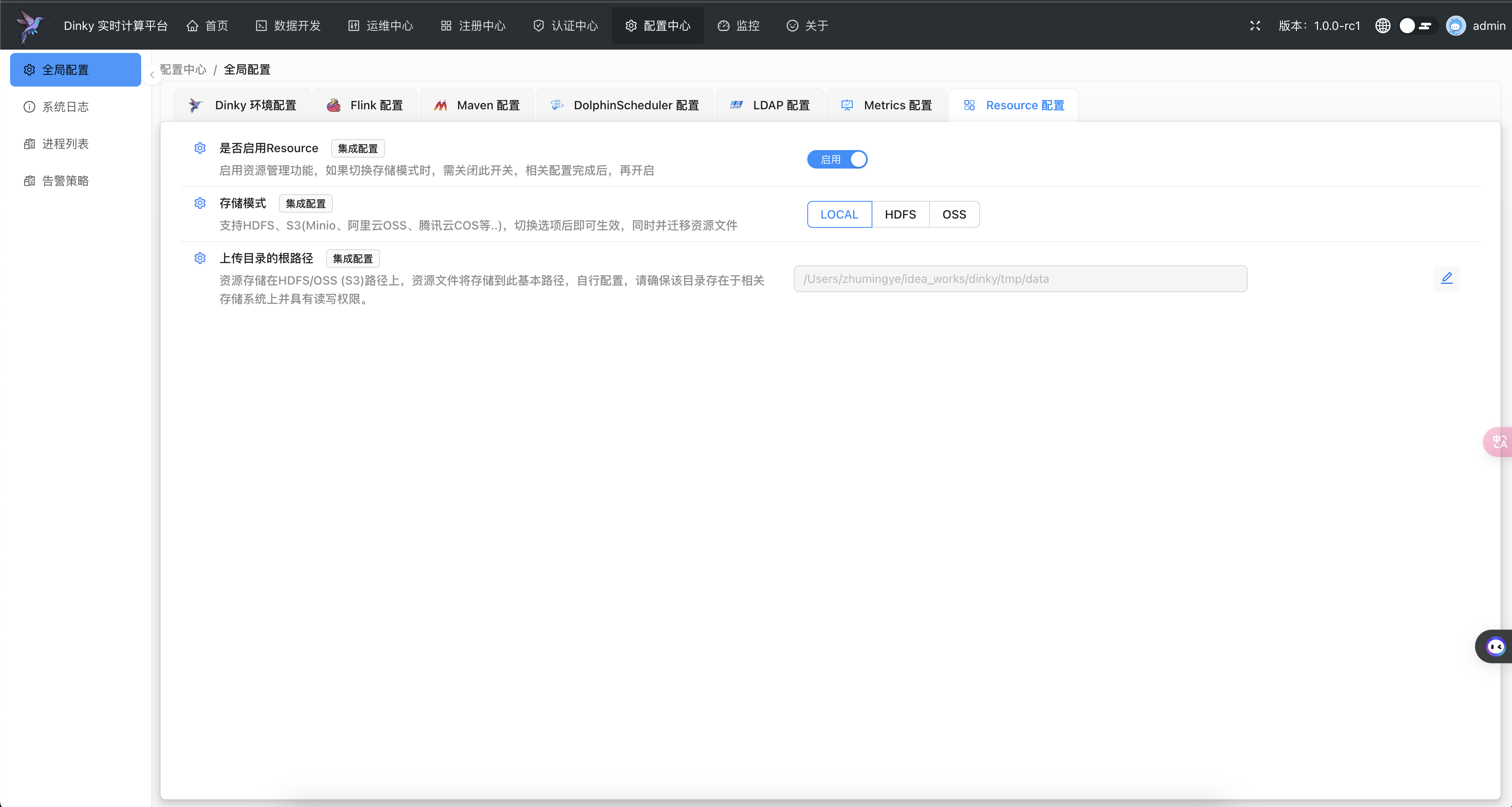

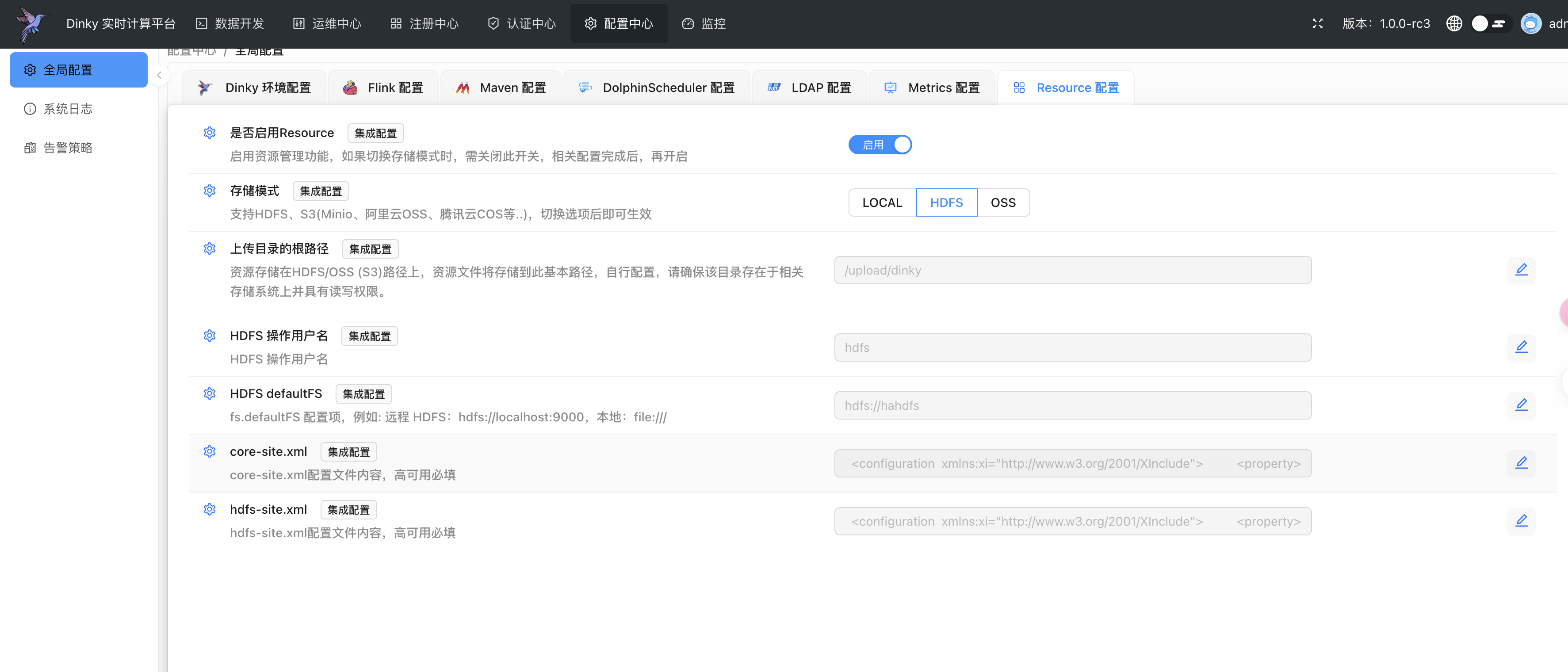

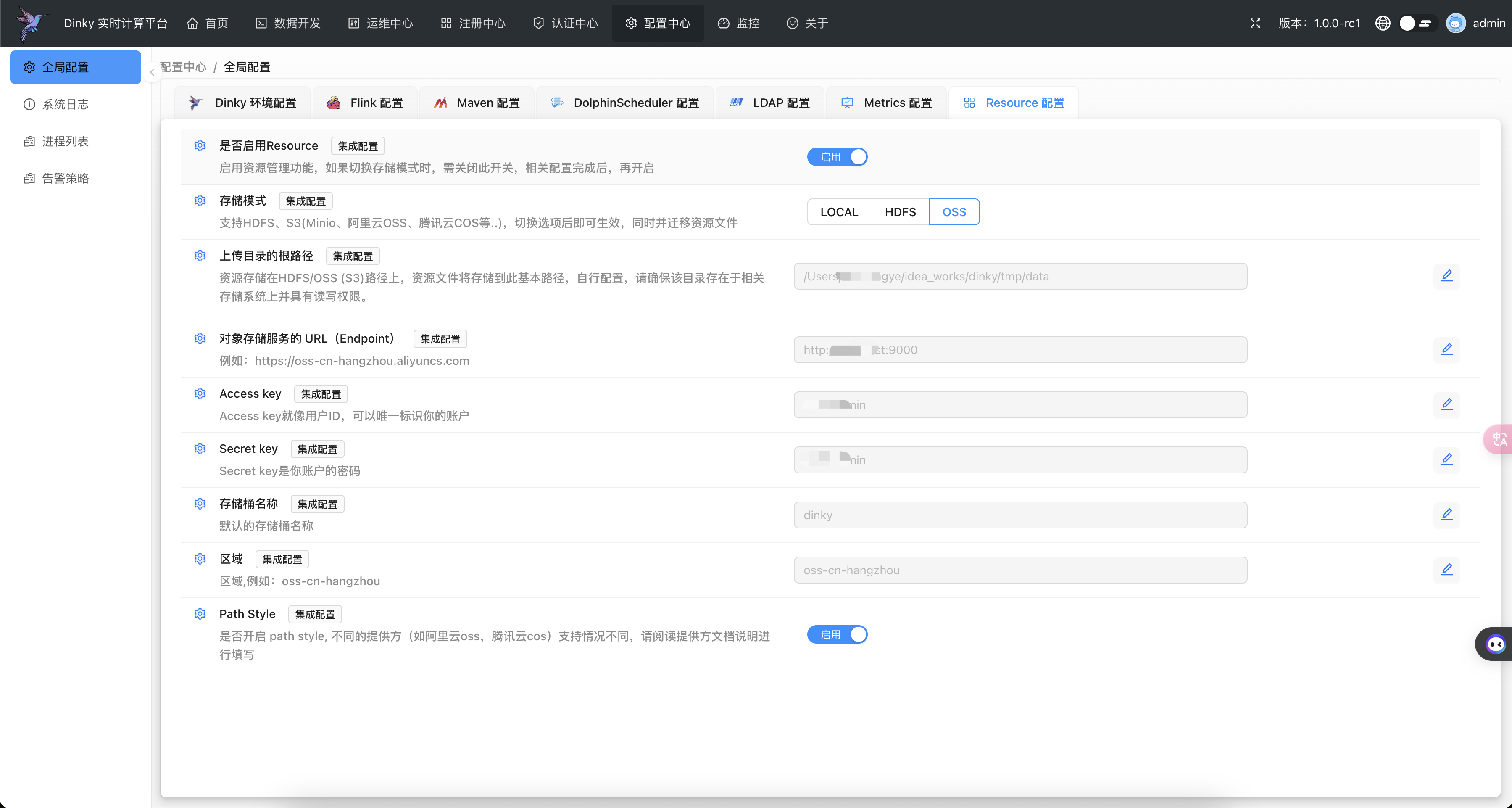

.../global_settings/resource_setting.md | 70 ++++

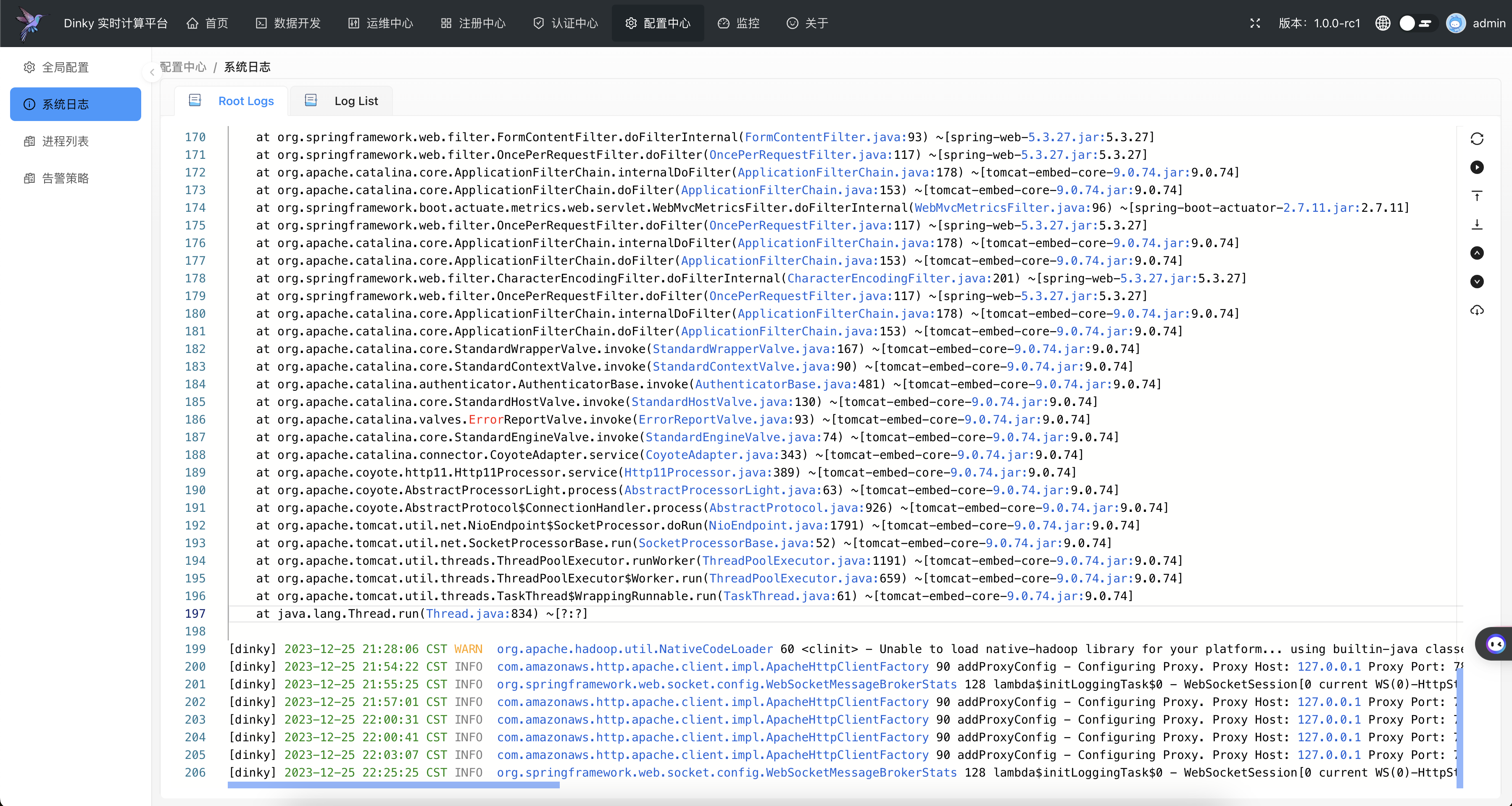

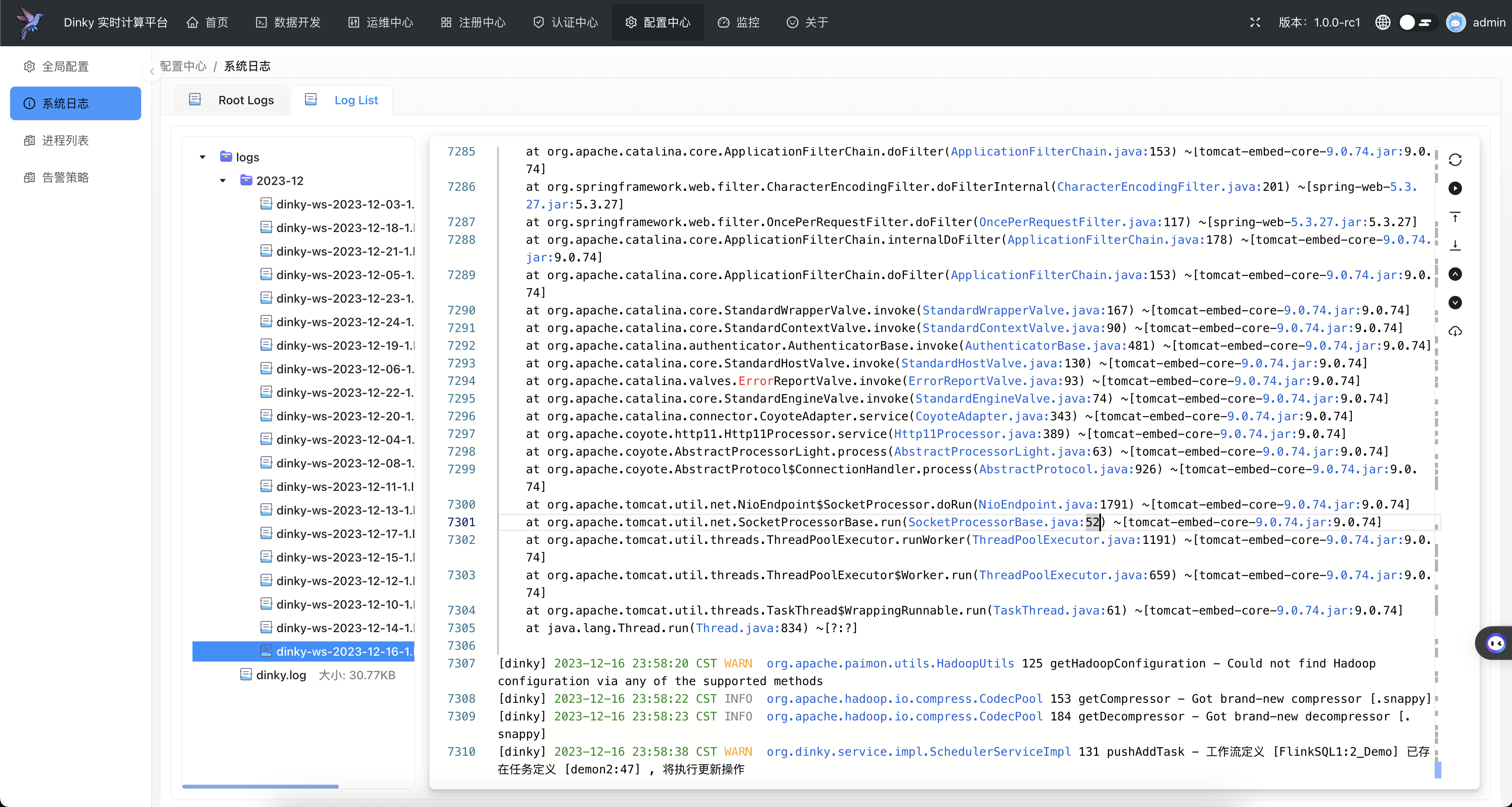

.../user_guide/system_setting/system_log.md | 26 ++

.../version-1.0-sidebars.json | 8 +

docs/versions.json | 1 +

140 files changed, 9108 insertions(+), 24 deletions(-)

create mode 100644 docs/i18n/en/docusaurus-plugin-content-docs/version-1.0.json

create mode 100644 docs/i18n/zh/docusaurus-plugin-content-docs/version-1.0.json

create mode 100644 docs/versioned_docs/version-1.0/comminicate.md

create mode 100644 docs/versioned_docs/version-1.0/deploy_guide/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/deploy_guide/compile_deploy.md

create mode 100644 docs/versioned_docs/version-1.0/deploy_guide/docker_deploy.md

create mode 100644 docs/versioned_docs/version-1.0/deploy_guide/kubernetes_deploy.md

create mode 100644 docs/versioned_docs/version-1.0/deploy_guide/normal_deploy.mdx

create mode 100644 docs/versioned_docs/version-1.0/deploy_guide/upgrade/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/deploy_guide/upgrade/upgrade_075to100.md

create mode 100644 docs/versioned_docs/version-1.0/deploy_guide/upgrade/upgrade_overview.md

create mode 100644 docs/versioned_docs/version-1.0/developer_guide/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/developer_guide/contribution/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/developer_guide/contribution/auto_sync.md

create mode 100644 docs/versioned_docs/version-1.0/developer_guide/contribution/code_format.md

create mode 100644 docs/versioned_docs/version-1.0/developer_guide/contribution/commit_code.md

create mode 100644 docs/versioned_docs/version-1.0/developer_guide/contribution/commit_message.md

create mode 100644 docs/versioned_docs/version-1.0/developer_guide/contribution/document.md

create mode 100644 docs/versioned_docs/version-1.0/developer_guide/contribution/how_contribute.md

create mode 100644 docs/versioned_docs/version-1.0/developer_guide/contribution/issue.md

create mode 100644 docs/versioned_docs/version-1.0/developer_guide/contribution/pull_request.md

create mode 100644 docs/versioned_docs/version-1.0/developer_guide/local_debug.md

create mode 100644 docs/versioned_docs/version-1.0/extend/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/extend/expand_statements/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/extend/expand_statements/add_file_statement.md

create mode 100644 docs/versioned_docs/version-1.0/extend/expand_statements/add_jar_statement.md

create mode 100644 docs/versioned_docs/version-1.0/extend/expand_statements/aggtable_statement.md

create mode 100644 docs/versioned_docs/version-1.0/extend/expand_statements/create_temporal_function.md

create mode 100644 docs/versioned_docs/version-1.0/extend/expand_statements/execute_jar.md

create mode 100644 docs/versioned_docs/version-1.0/extend/expand_statements/flinkcdc_pipeline.md

create mode 100644 docs/versioned_docs/version-1.0/extend/expand_statements/print_table.md

create mode 100644 docs/versioned_docs/version-1.0/extend/expand_statements/variable_statement.md

create mode 100644 docs/versioned_docs/version-1.0/extend/function_expansion/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/extend/function_expansion/global_var_ext.md

create mode 100644 docs/versioned_docs/version-1.0/faq.md

create mode 100644 docs/versioned_docs/version-1.0/get_started/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/get_started/overview.md

create mode 100644 docs/versioned_docs/version-1.0/get_started/quick_experience.md

create mode 100644 docs/versioned_docs/version-1.0/openapi/CancelFlinkJob.md

create mode 100644 docs/versioned_docs/version-1.0/openapi/ExplainSql.md

create mode 100644 docs/versioned_docs/version-1.0/openapi/ExportSql.md

create mode 100644 docs/versioned_docs/version-1.0/openapi/GetJobInstance.md

create mode 100644 docs/versioned_docs/version-1.0/openapi/GetJobInstanceByTaskId.md

create mode 100644 docs/versioned_docs/version-1.0/openapi/GetJobPlan.md

create mode 100644 docs/versioned_docs/version-1.0/openapi/GetStreamGraph.md

create mode 100644 docs/versioned_docs/version-1.0/openapi/GetTaskLineage.md

create mode 100644 docs/versioned_docs/version-1.0/openapi/RestartTask.md

create mode 100644 docs/versioned_docs/version-1.0/openapi/SavepointTrigger.md

create mode 100644 docs/versioned_docs/version-1.0/openapi/SubmitTaskById.md

create mode 100644 docs/versioned_docs/version-1.0/openapi/SubmitTaskJob.md

create mode 100644 docs/versioned_docs/version-1.0/openapi/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/openapi/openapi_overview.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/Integration_practice/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/Integration_practice/dinky_integration_ds.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/Integration_practice/dinky_integration_flink.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/cdcsource_practice/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/cdcsource_practice/cdcsource_faq.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/cdcsource_practice/cdcsource_mysqlcdc2ck.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/cdcsource_practice/cdcsource_mysqlcdc2dinkycatalog.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/cdcsource_practice/cdcsource_mysqlcdc2doris.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/cdcsource_practice/cdcsource_mysqlcdc2hivecatalog.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/cdcsource_practice/cdcsource_mysqlcdc2hudi.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/cdcsource_practice/cdcsource_mysqlcdc2kafka.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/cdcsource_practice/cdcsource_mysqlcdc2multiplesink.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/cdcsource_practice/cdcsource_mysqlcdc2mysql.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/cdcsource_practice/cdcsource_mysqlcdc2oracle.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/cdcsource_practice/cdcsource_mysqlcdc2paimon.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/cdcsource_practice/cdcsource_mysqlcdc2pg.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/cdcsource_practice/cdcsource_mysqlcdc2print.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/cdcsource_practice/cdcsource_mysqlcdc2starrocks.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/cdcsource_practice/cdcsource_overview.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/run_mode_practice/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/run_mode_practice/application_model_submit.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/run_mode_practice/dinky_k8s_quick_start.mdx

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/run_mode_practice/k8s_native_model_submit.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/run_mode_practice/k8s_operater_model_submit.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/run_mode_practice/k8s_session_model_submit.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/run_mode_practice/local_model_submit.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/run_mode_practice/projob_model_submit.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/run_mode_practice/standalone_model_submit.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/run_mode_practice/yarnsession_model_submit.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/scenario_practice/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/scenario_practice/mysqlcdc2doris.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/scenario_practice/mysqlcdc2hudi.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/scenario_practice/mysqlcdc2paimon.md

create mode 100644 docs/versioned_docs/version-1.0/practical_guide/scenario_practice/mysqlcdc2starrocks.md

create mode 100644 docs/versioned_docs/version-1.0/roadmap.md

create mode 100644 docs/versioned_docs/version-1.0/thanks.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/user_guide/auth_center/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/user_guide/auth_center/menu.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/auth_center/role.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/auth_center/row_limits.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/auth_center/tenant.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/auth_center/token.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/auth_center/user.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/devops_center/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/user_guide/devops_center/job_details.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/devops_center/job_overview.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/metrics_overview.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/register_center/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/user_guide/register_center/alert/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/user_guide/register_center/alert/alert_group.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/register_center/alert/alert_instance.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/register_center/alert/alert_overview.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/register_center/alert/alert_strategy.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/register_center/alert/alert_template.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/register_center/cluster_manage.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/register_center/datasource_manage.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/register_center/document_manager.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/register_center/git_project.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/register_center/global_var.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/register_center/resource.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/register_center/udf.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/studio/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/user_guide/studio/catalog.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/studio/execute_env_config.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/studio/flink_env_task_devlop.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/studio/flink_sql_task_devlop.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/studio/jdbc_task_devlop.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/studio/studio_overview.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/system_setting/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/user_guide/system_setting/global_settings/_category_.json

create mode 100644 docs/versioned_docs/version-1.0/user_guide/system_setting/global_settings/dinky_setting.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/system_setting/global_settings/dolphinscheduler_setting.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/system_setting/global_settings/flink_setting.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/system_setting/global_settings/ldap.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/system_setting/global_settings/maven_setting.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/system_setting/global_settings/metrics_setting.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/system_setting/global_settings/resource_setting.md

create mode 100644 docs/versioned_docs/version-1.0/user_guide/system_setting/system_log.md

create mode 100644 docs/versioned_sidebars/version-1.0-sidebars.json

diff --git a/docs/docs/developer_guide/local_debug.md b/docs/docs/developer_guide/local_debug.md

index 365bb68fa8..8fbe672e09 100644

--- a/docs/docs/developer_guide/local_debug.md

+++ b/docs/docs/developer_guide/local_debug.md

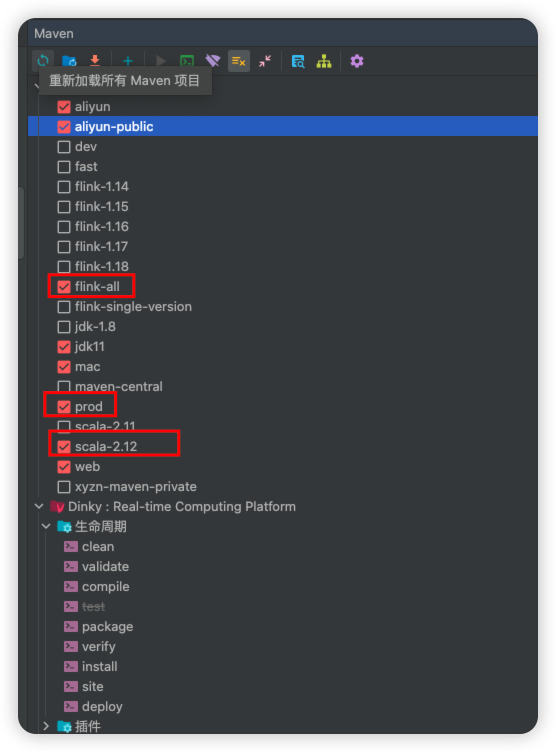

@@ -101,6 +101,8 @@ Install/Package 过程中报错代码格式化问题,请参考 [代码格式化]

### Profile 说明

+> 注意: scale 相关 profile 从 Dinky v1.1.0 版本移除,默认使用 scala 2.12 版本(Flink 1.15 及以上版本不再单独支持 scala 2.11)

+

| Profile | 说明 |

|:--------------------:|:----------------------------------------------------------------------------------:|

| dev | 开发环境/本地调试,默认不选中,此功能主要用于本地调试或者二次开发,用于加载相关依赖 |

@@ -118,8 +120,6 @@ Install/Package 过程中报错代码格式化问题,请参考 [代码格式化]

| mac | 用于适配在 mac 系统上进行调试 |

| maven-central | 用于指定 maven 仓库为中央仓库 |

| prod | 生产环境,默认选中,此功能主要用于编译打包,此 profile 会将部分依赖排除掉,不会打进最终 tar.gz 包内 |

-| scala-2.11 | 用于指定 Scala 版本为 2.11,只能单选 |

-| scala-2.12 | 用于指定 Scala 版本为 2.12,只能单选 |

| web | 打包前端资源,需要勾选 |

:::warning 注意

@@ -159,8 +159,7 @@ Dinky开发环境配置有两种模式,分别是 provided 环境和 compile

### 修改配置文件

-> 以 MySQL 为例, 如果使用 PostgreSQL/H2 请自行修改,注意: 使用 H2

-> 数据库时无需修改如下配置,直接进行 [启动后端服务](#启动后端服务)

+> 以 MySQL 为例, 如果使用 PostgresSQL/H2 请自行修改,注意: 默认使用 H2 数据库时无需修改如下配置,直接 [启动后端服务](#启动后端服务)

- 修改 dinky-admin/src/main/resources/application-mysql.yml 文件,配置相应的数据库连接信息

diff --git a/docs/docusaurus.config.js b/docs/docusaurus.config.js

index b78c5cd01c..1750b59c74 100644

--- a/docs/docusaurus.config.js

+++ b/docs/docusaurus.config.js

@@ -84,22 +84,28 @@ const config = {

/** @type {import('@docusaurus/preset-classic').Options} */

({

docs: {

- lastVersion: 'current',

+ includeCurrentVersion: true,

+ lastVersion: '1.0',

versions: {

current: {

- label: '1.0',

+ label: 'Dev',

path: '/next',

+ banner: 'unreleased',

},

- 0.6: {

- label: '0.6',

- path: '/0.6',

- banner: 'unmaintained',

+ '1.0': {

+ label: '1.0',

+ path: '/1.0',

},

0.7: {

label: '0.7',

path: '/0.7',

banner: 'unmaintained',

},

+ 0.6: {

+ label: '0.6',

+ path: '/0.6',

+ banner: 'unmaintained',

+ },

},

sidebarPath: require.resolve('./sidebars.js'),

sidebarCollapsible: true,

diff --git a/docs/i18n/en/docusaurus-plugin-content-docs/current.json b/docs/i18n/en/docusaurus-plugin-content-docs/current.json

index ead59acbed..f3cb8f83de 100644

--- a/docs/i18n/en/docusaurus-plugin-content-docs/current.json

+++ b/docs/i18n/en/docusaurus-plugin-content-docs/current.json

@@ -1,6 +1,6 @@

{

"version.label": {

- "message": "1.0",

+ "message": "Dev",

"description": "The label for version current"

},

"sidebar.tutorialSidebar.category.deploy_guide": {

@@ -103,10 +103,6 @@

"message": "Quick Use",

"description": "The label for category Quick Use in sidebar tutorialSidebar"

},

- "sidebar.tutorialSidebar.category.快速使用": {

- "message": "快速使用",

- "description": "The label for category 快速使用 in sidebar tutorialSidebar"

- },

"sidebar.tutorialSidebar.category.upgrade": {

"message": "Upgrade",

"description": "The label for category upgrade in sidebar tutorialSidebar"

diff --git a/docs/i18n/en/docusaurus-plugin-content-docs/version-1.0.json b/docs/i18n/en/docusaurus-plugin-content-docs/version-1.0.json

new file mode 100644

index 0000000000..ead59acbed

--- /dev/null

+++ b/docs/i18n/en/docusaurus-plugin-content-docs/version-1.0.json

@@ -0,0 +1,118 @@

+{

+ "version.label": {

+ "message": "1.0",

+ "description": "The label for version current"

+ },

+ "sidebar.tutorialSidebar.category.deploy_guide": {

+ "message": "Deploy Guide",

+ "description": "The label for category deploy_guide in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.studio": {

+ "message": "Data Studio",

+ "description": "The label for category studio in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.development_control": {

+ "message": "Basic Introduction",

+ "description": "The label for category development_control in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.devops_center": {

+ "message": "Devops Center",

+ "description": "The label for category devops_center in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.register_center": {

+ "message": "Register Center",

+ "description": "The label for category register_center in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.system_setting": {

+ "message": "Setting Center",

+ "description": "The label for category system_setting in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.contribution": {

+ "message": "Contribution",

+ "description": "The label for category contribution in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.extend": {

+ "message": "Extend",

+ "description": "The label for category extend in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.function_extension": {

+ "message": "Function Extension",

+ "description": "The label for category function_extension in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.practical_guide": {

+ "message": "Practical Guide",

+ "description": "The label for category practical_guide in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.get_started": {

+ "message": "Get Started",

+ "description": "The label for category get_started in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.platform_intro": {

+ "message": "Dinky Intro",

+ "description": "The label for category platform_intro in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.quick_start": {

+ "message": "SQL Quick Start",

+ "description": "The label for category quick_start in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.cdcsource_practice": {

+ "message": "CDCSource Practice",

+ "description": "The label for category cdcsource_practice in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.run_mode_practice": {

+ "message": "Flink Mode Submission Practice",

+ "description": "The label for category run_mode_practice in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.scenario_practice": {

+ "message": "Scenario Practice",

+ "description": "The label for category scenario_practice in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.Integration_practice": {

+ "message": "Integration Practice",

+ "description": "The label for category Integration_practice in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.user_guide": {

+ "message": "Manual",

+ "description": "The label for category user_guide in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.alert": {

+ "message": "Alert",

+ "description": "The label for category alert in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.auth_center": {

+ "message": "Auth Center",

+ "description": "The label for category auth_center in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.global_settings": {

+ "message": "Global Config",

+ "description": "The label for category global_settings in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.udf_develop": {

+ "message": "UDFFunction Develop",

+ "description": "The label for category udf_develop in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.developer_guide": {

+ "message": "Developer Guide",

+ "description": "The label for category developer_guide in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.extended_grammar": {

+ "message": "Extended Grammar",

+ "description": "The label for category extended_grammar in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.quick_use": {

+ "message": "Quick Use",

+ "description": "The label for category Quick Use in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.快速使用": {

+ "message": "快速使用",

+ "description": "The label for category 快速使用 in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.upgrade": {

+ "message": "Upgrade",

+ "description": "The label for category upgrade in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.openapi": {

+ "message": "OpenAPI",

+ "description": "The label for category openapi in sidebar tutorialSidebar"

+ }

+}

diff --git a/docs/i18n/en/docusaurus-theme-classic/footer.json b/docs/i18n/en/docusaurus-theme-classic/footer.json

index 3e72113470..83e2510ebc 100644

--- a/docs/i18n/en/docusaurus-theme-classic/footer.json

+++ b/docs/i18n/en/docusaurus-theme-classic/footer.json

@@ -13,11 +13,11 @@

},

"link.item.label.doc_home": {

"message": "Doc Home",

- "description": "The label of footer link with label=doc_home linking to /docs/next/platform_intro/overview"

+ "description": "The label of footer link with label=doc_home linking to /docs/next/get_started/overview"

},

"link.item.label.openapi": {

"message": "Open Api",

- "description": "The label of footer link with label=openapi linking to /docs/next/openapi"

+ "description": "The label of footer link with label=openapi linking to /docs/next/openapi/openapi_overview"

},

"link.item.label.issue": {

"message": "Issue",

diff --git a/docs/i18n/zh/docusaurus-plugin-content-docs/current.json b/docs/i18n/zh/docusaurus-plugin-content-docs/current.json

index 9c6a0e29db..45b65e0324 100644

--- a/docs/i18n/zh/docusaurus-plugin-content-docs/current.json

+++ b/docs/i18n/zh/docusaurus-plugin-content-docs/current.json

@@ -1,6 +1,6 @@

{

"version.label": {

- "message": "1.0",

+ "message": "Dev",

"description": "The label for version current"

},

"sidebar.tutorialSidebar.category.deploy_guide": {

@@ -103,10 +103,6 @@

"message": "扩展语法",

"description": "The label for category extended_grammar in sidebar tutorialSidebar"

},

- "sidebar.tutorialSidebar.category.快速使用": {

- "message": "快速使用",

- "description": "The label for category 快速使用 in sidebar tutorialSidebar"

- },

"sidebar.tutorialSidebar.category.upgrade": {

"message": "升级",

"description": "The label for category upgrade in sidebar tutorialSidebar"

diff --git a/docs/i18n/zh/docusaurus-plugin-content-docs/version-1.0.json b/docs/i18n/zh/docusaurus-plugin-content-docs/version-1.0.json

new file mode 100644

index 0000000000..9c6a0e29db

--- /dev/null

+++ b/docs/i18n/zh/docusaurus-plugin-content-docs/version-1.0.json

@@ -0,0 +1,118 @@

+{

+ "version.label": {

+ "message": "1.0",

+ "description": "The label for version current"

+ },

+ "sidebar.tutorialSidebar.category.deploy_guide": {

+ "message": "安装部署",

+ "description": "The label for category deploy_guide in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.user_guide": {

+ "message": "使用手册",

+ "description": "The label for category user_guide in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.studio": {

+ "message": "数据开发",

+ "description": "The label for category studio in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.development_control": {

+ "message": "基本介绍",

+ "description": "The label for category development_control in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.devops_center": {

+ "message": "运维中心",

+ "description": "The label for category devops_center in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.register_center": {

+ "message": "注册中心",

+ "description": "The label for category register_center in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.system_setting": {

+ "message": "配置中心",

+ "description": "The label for category system_setting in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.extend": {

+ "message": "扩展",

+ "description": "The label for category extend in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.function_extension": {

+ "message": "功能扩展",

+ "description": "The label for category function_extension in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.practical_guide": {

+ "message": "实践指南",

+ "description": "The label for category practical_guide in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.developer_guide": {

+ "message": "开发者指南",

+ "description": "The label for category developer_guide in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.contribution": {

+ "message": "参与贡献",

+ "description": "The label for category contribution in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.quick_use": {

+ "message": "快速使用",

+ "description": "The label for category 快速使用 in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.get_started": {

+ "message": "快速开始",

+ "description": "The label for category get_started in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.platform_intro": {

+ "message": "Dinky 介绍",

+ "description": "The label for category platform_intro in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.quick_start": {

+ "message": "SQL 快速入门",

+ "description": "The label for category quick_start in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.cdcsource_practice": {

+ "message": "整库同步实践",

+ "description": "The label for category cdcsource_practice in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.run_mode_practice": {

+ "message": "Flink模式提交实践",

+ "description": "The label for category run_mode_practice in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.scenario_practice": {

+ "message": "场景实践",

+ "description": "The label for category scenario_practice in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.Integration_practice": {

+ "message": "集成实践",

+ "description": "The label for category Integration_practice in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.alert": {

+ "message": "告警",

+ "description": "The label for category alert in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.auth_center": {

+ "message": "认证中心",

+ "description": "The label for category auth_center in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.global_settings": {

+ "message": "全局配置",

+ "description": "The label for category global_settings in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.udf_develop": {

+ "message": "函数开发",

+ "description": "The label for category udf_develop in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.extended_grammar": {

+ "message": "扩展语法",

+ "description": "The label for category extended_grammar in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.快速使用": {

+ "message": "快速使用",

+ "description": "The label for category 快速使用 in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.upgrade": {

+ "message": "升级",

+ "description": "The label for category upgrade in sidebar tutorialSidebar"

+ },

+ "sidebar.tutorialSidebar.category.openapi": {

+ "message": "OpenAPI",

+ "description": "The label for category openapi in sidebar tutorialSidebar"

+ }

+}

diff --git a/docs/i18n/zh/docusaurus-theme-classic/footer.json b/docs/i18n/zh/docusaurus-theme-classic/footer.json

index d959dfe385..96de541e03 100644

--- a/docs/i18n/zh/docusaurus-theme-classic/footer.json

+++ b/docs/i18n/zh/docusaurus-theme-classic/footer.json

@@ -13,11 +13,11 @@

},

"link.item.label.doc_home": {

"message": "文档首页",

- "description": "The label of footer link with label=doc_home linking to /docs/next/platform_intro/overview"

+ "description": "The label of footer link with label=doc_home linking to /docs/next/get_started/overview"

},

"link.item.label.openapi": {

"message": "Open Api",

- "description": "The label of footer link with label=openapi linking to /docs/next/openapi"

+ "description": "The label of footer link with label=openapi linking to /docs/next/openapi/openapi_overview"

},

"link.item.label.issue": {

"message": "Issue",

diff --git a/docs/versioned_docs/version-1.0/comminicate.md b/docs/versioned_docs/version-1.0/comminicate.md

new file mode 100644

index 0000000000..1017474e2f

--- /dev/null

+++ b/docs/versioned_docs/version-1.0/comminicate.md

@@ -0,0 +1,19 @@

+---

+sidebar_position: 998

+id: comminicate

+title: 交流与贡献

+---

+

+欢迎您加入社区交流分享,也欢迎您为社区贡献自己的力量。

+

+在此非常感谢大家的支持~

+

+QQ社区群:**543709668**,申请备注 “ Dinky ”,不写不批

+

+微信社区群(推荐):添加微信号 wenmo_ai 邀请进群,申请备注 “ Dinky + 企业名 + 职位”,不写不批

+

+**公众号(最新消息获取建议关注):**

+- **微信搜索公众号:** `Dinky开源`

+- **扫码关注公众号:** 扫下图二维码,关注公众号

+

+

\ No newline at end of file

diff --git a/docs/versioned_docs/version-1.0/deploy_guide/_category_.json b/docs/versioned_docs/version-1.0/deploy_guide/_category_.json

new file mode 100644

index 0000000000..8b1f05fa20

--- /dev/null

+++ b/docs/versioned_docs/version-1.0/deploy_guide/_category_.json

@@ -0,0 +1,4 @@

+{

+ "label": "deploy_guide",

+ "position": 2

+}

diff --git a/docs/versioned_docs/version-1.0/deploy_guide/compile_deploy.md b/docs/versioned_docs/version-1.0/deploy_guide/compile_deploy.md

new file mode 100644

index 0000000000..29ea26478d

--- /dev/null

+++ b/docs/versioned_docs/version-1.0/deploy_guide/compile_deploy.md

@@ -0,0 +1,127 @@

+---

+sidebar_position: 3

+position: 3

+id: compile_deploy

+title: 编译部署

+---

+

+:::tip 提示

+1. 如果你只想部署 Dinky,可以跳过本章节,直接查看[常规部署](./normal_deploy)章节

+

+2. 如果你想对 Dinky 做二次开发,参考[本地调试](../developer_guide/local_debug)章节,从而搭建开发环境。开发完成之后,再参考本章节,进行编译。

+

+3. 自 Dinky v1.0.0 版本开始,Dinky 在打包时仅支持单个版本的打包方式,即: 你只能选择一个 Flink 版本进行打包,而不能同时打包多个版本。

+:::

+

+

+## 环境准备

+

+环境要求请参考 [本地调试-环境要求](../developer_guide/local_debug#环境要求) 章节! 各个环境安装请自行搜索

+

+

+---

+

+

+:::warning 注意

+当你看到这里的时候,说明你已经完成了所有的环境准备,接下来就是编译 Dinky 了。

+

+接下来将从 IDEA 和 Linux Shell 两个方面介绍如何编译 Dinky。请注意环境要求是一致的,否则可能会出现编译失败的情况。

+:::

+

+### IDEA 编译

+

+> 推荐使用 IDEA 进行编译,因为 IDEA 在打开项目时会自动下载依赖,而且编译速度快,方便调试.

+

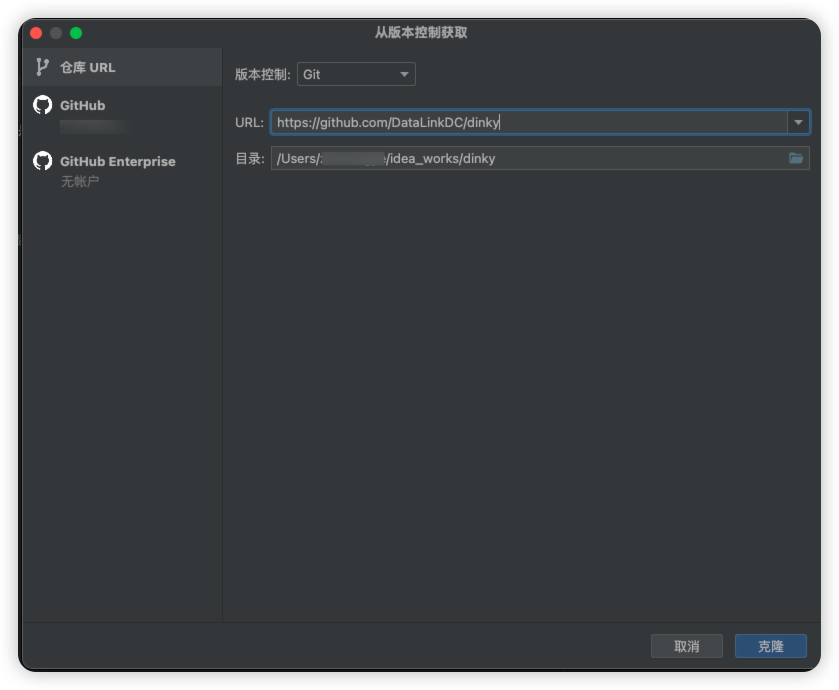

+#### Clone 项目

+> 注意: 本次直接 clone 的是 Dinky 主仓库,如果你想要二次开发/基于自己的仓库进行二次开发,请先 fork 项目,然后再 clone 你自己的仓库

+

+

+

+Clone 完成后, 等待 IDEA 自动下载依赖(前提 IDEA 已经正确配置了 Maven) ,下载完成后, 请按照下一步中的步骤(Profile)进行编译

+

+

+#### 编译打包

+

+

+:::danger 注意

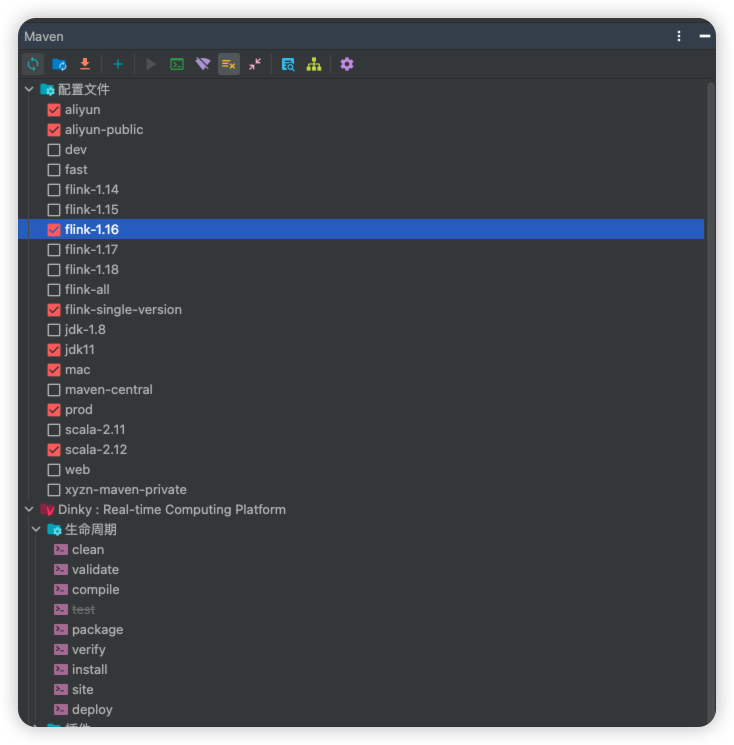

+请注意: 有关于各个 Profile 的详细介绍,请查看 [Profile 说明](../developer_guide/local_debug#Profile-说明)

+:::

+

+

+- 打包 Profile

+

+> 注意: 需要勾选 web,否则无法打包前端资源

+

+

+

+

+

+

+:::danger 注意

+1. 请严格按照上述 Profile 进行编译打包,否则可能会出现编译失败的情况。如出现编译失败,请检查环境是否正确,Profile 是否正确。请务必仔细核对。

+2. 如果出现编译失败,请查看 IDEA 控制台输出的错误信息,根据错误信息自行进行排查。如果无法解决,请百度/谷歌/Stackoverflow 解决。最后如果还是无法解决,请提交 [Issue](https://github.com/DataLinkDC/dinky/issues/new/choose)

+3. 编译完成后,请查看编译后的目录,如果编译成功,会在 `dinky/build` 目录下生成对应的版本的 jar 包。

+:::

+

+#### 编译结果

+

+编译完成后,请查看编译后的目录,如果编译成功,会在 `dinky/build` 目录下生成对应的版本的 tar.gz 包。

+

+

+以上就是 IDEA 编译 Dinky 的详细步骤,接下来将介绍如何使用 Linux Shell 进行编译。

+

+---

+

+### Linux Shell 编译

+

+> 注意: 本次直接 clone 的是 Dinky 主仓库,如果你想要二次开发/基于自己的仓库进行二次开发,请先 fork 项目,然后再 clone 你自己的仓库

+

+#### Clone 项目

+

+```bash

+# 创建某一路径用来存放 Dinky 源码

+mkdir -p /opt/dinky-source-code

+cd /opt/dinky-source-code

+# Clone 项目

+git clone https://github.com/DataLinkDC/dinky.git

+```

+

+#### 编译打包

+

+> 如果你看到此处,那么默认你是对 Maven 有一定了解并熟练使用的,如果你不了解 Maven/不会使用 Maven,请自行百度/谷歌/Stackoverflow...解决

+

+```bash

+cd /opt/dinky-source-code

+

+# 编译打包 Profile, 注意 scala 支持 2.11 和 2.12, 请根据实际情况进行选择,jdk 支持 8/11,请根据实际情况进行选择,不选jdk11默认使用系统内的jdk8

+mvn clean package -DskipTests=true -P prod,jdk11,flink-single-version,scala-2.12,aliyun,flink-1.16,web

+

+```

+

+:::danger 注意

+请注意: 有关于各个 Profile 的详细介绍,请查看 [Profile 说明](../developer_guide/local_debug#Profile-说明)

+:::

+

+:::danger 注意

+1. 请严格按照上述 Profile 进行编译打包,否则可能会出现编译失败的情况。如出现编译失败,请检查环境是否正确,Profile 是否正确。请务必仔细核对。

+2. 如果出现编译失败,请查看 IDEA 控制台输出的错误信息,根据错误信息自行进行排查。如果无法解决,请百度/谷歌/Stackoverflow 解决。最后如果还是无法解决,请提交 [Issue](https://github.com/DataLinkDC/dinky/issues)

+:::

+

+#### 编译结果

+

+编译完成后,请查看编译后的目录,如果编译成功,会在 `dinky/build` 目录下生成对应的版本的 tar.gz 包。

+

+以上就是 Linux Shell 编译 Dinky 的详细步骤,

+

+---

+

+:::info

+上述两种方式,任选其一即可。如果已经正常编译成功,接下来将你可以按照 [部署文档](./normal_deploy) 进行部署了。

+:::

+

+

+

+

+

+

+

diff --git a/docs/versioned_docs/version-1.0/deploy_guide/docker_deploy.md b/docs/versioned_docs/version-1.0/deploy_guide/docker_deploy.md

new file mode 100644

index 0000000000..67cdda9f8a

--- /dev/null

+++ b/docs/versioned_docs/version-1.0/deploy_guide/docker_deploy.md

@@ -0,0 +1,131 @@

+---

+sidebar_position: 2

+position: 2

+id: docker_deploy

+title: Docker 部署

+---

+

+:::danger 注意

+

+Dinky v1.0.0 的 Docker 镜像正在开发中,敬请期待。以下步骤目前由于镜像未发布,无法使用。请耐心等待。如您对 Docker 镜像有兴趣,欢迎加入我们的开发群,一起参与开发。

+

+:::

+

+

+## Docker 快速使用教程

+本教程使用三种不同的方式通过 Docker 完成 Dinky 的部署,如果你想要快速体验,推荐使用 standalone-server 镜像, 如果你想要体验比较完整的服务,推荐使用 docker-compose 启动服务。如果你已经有自己的数据库服务 你想要沿用这些基础服务,你可以参考沿用已有的 Mysql 、 Hadoop 和 Flink 服务完成部署。

+

+## 前置条件

+- Docker 1.13.1+

+- Docker Compose 1.28.0+(可选)

+

+## Docker启动

+使用 H2 本地数据库快速启动

+```shell

+docker run --restart=always -p 8888:8888 \

+ --name dinky \

+ dinky/dinky:1.0.3-flink1.17

+

+```

+使用 外部mysql数据库

+```bash

+docker run --restart=always -p 8888:8888 \

+ --name dinky \

+ -e DB_ACTIVE=mysql \

+ -e MYSQL_ADDR=127.0.0.1:3306 \

+ -e MYSQL_DATABASE=dinky \

+ -e MYSQL_USERNAME=dinky \

+ -e MYSQL_PASSWORD=dinky \

+ -v /opt/lib:/opt/flink/lib/customJar/ \

+ dinky/dinky:1.0.3-flink1.17

+

+```

+:::tip 说明

+由于mysql与Apache 2.0协议不兼容,dinky无法默认提供mysql驱动,所以需要您手动提供mysql依赖并放到`/opt/flink/lib/customJar/`

+下面,上面已经给出了映射,如果你有自己的依赖目录,修改即可

+:::

+

+使用 外部postgres数据库

+```bash

+docker run --restart=always -p 8888:8888 \

+ --name dinky \

+ -e DB_ACTIVE=pgsql \

+ -e POSTGRES_ADDR=127.0.0.1:5432 \

+ -e POSTGRES_DATABASE=dinky \

+ -e POSTGRES_USERNAME=dinky \

+ -e POSTGRES_PASSWORD=dinky \

+ -v /opt/lib:/opt/flink/lib/customJar/ \

+ dinky/dinky:1.0.3-flink1.17

+```

+---

+### 使用docker-compose

+docker-compose可快速帮你搭建起来dinky与flink集群环境,

+下载dinky源码后,在 `deploy/docker` 下面即可找到`docker-compose.yml`和 `.env` 文件,

+```bash

+cd deploy/docker/

+ls -al

+-rwxrwxrwx 1 root root 765 May 29 11:29 docker-compose.dev.yml

+-rwxrwxrwx 1 root root 699 May 29 11:29 docker-compose.yml

+-rwxrwxrwx 1 root root 1603 May 29 11:29 Dockerfile

+-rwxrwxrwx 1 root root 1718 May 29 11:46 .env

+

+```

+编辑 `.env` 文件,修改你想要的配置,如果只是快速体验,无需修改任何内容

+```shell

+#定义dinky版本号

+DINKY_VERSION=1.0.3

+#定义Flink版本(不要写小版本号)

+FLINK_VERSION=1.17

+

+# 自定义jar包依赖本地路径(例如:mysql驱动)

+CUSTOM_JAR_PATH=/opt/dinky/extends/

+

+# 使用那种数据库,默认h2

+DB_ACTIVE=h2

+# h2数据库持久化文件路径

+H2_DB=./tmp/db/h2

+

+## 使用mysql数据库时打开注释并填写内容

+## 如果 DB_ACTIVE 配置为mysaql,请修改下面配置,否则忽略

+##MYSQL_ADDR=127.0.0.1:3306

+#MYSQL_DATABASE=dinky

+#MYSQL_USERNAME=dinky

+#MYSQL_PASSWORD=dinky

+

+## 使用pg数据库时打开注释并填写内容

+## 如果 DB_ACTIVE 配置为pgsql,请修改下面配置,否则忽略

+##POSTGRES_USER=dinky

+#POSTGRES_PASSWORD=dinky

+#POSTGRES_ADDR=localhost:5432

+#POSTGRES_DB=dinky

+

+# 时区

+TZ=Asia/Shanghai

+# 自带Flink集群配置,一般不用改

+FLINK_PROPERTIES="jobmanager.rpc.address: jobmanager"

+

+```

+启动集群

+```shell

+docker-compose up -d

+```

+

+

+## 本地开发

+

+可使用

+```shell

+docker compose --profile standalone -f docker-compose.yml -f docker-compose.dev.yml up

+```

+进行docker镜像的构建及运行(/docker/.env文件配置相关环境变量).

+

+如果需要前后端分离, 可使用

+```shell

+docker compose --profile ms -f docker-compose.yml -f docker-compose.dev.yml up

+```

+(适配自身nginx的docker/web/default.conf配置)

+对于1.15上版本,需要手动将容器中/opt/diny/plugin/flink{version}/flink-table-planner-loader*.jar移除,

+替换为相应版本的flink-table-planner_*.jar文件.

+创建容器时,可映射到容器/opt/diny/customJar文件夹,添加自定义jar包.

+

+欢迎补充

diff --git a/docs/versioned_docs/version-1.0/deploy_guide/kubernetes_deploy.md b/docs/versioned_docs/version-1.0/deploy_guide/kubernetes_deploy.md

new file mode 100644

index 0000000000..aa22074922

--- /dev/null

+++ b/docs/versioned_docs/version-1.0/deploy_guide/kubernetes_deploy.md

@@ -0,0 +1,363 @@

+---

+sidebar_position: 4

+position: 4

+id: kubernetes_deploy

+title: kubernetes 部署

+---

+

+Kubernetes 部署目的是在 Kubernetes 集群中部署 dinky 服务,能快速、便捷在生产中部署。

+

+## 前置条件

+- Helm 3.1.0+

+- Kubernetes 1.12+

+

+## 安装 dinky

+### 下载安装包

+https://www.dinky.org.cn/download/download

+

+### 修改配置

+#### 修改镜像地址

+cd dinky-release-${FLINK-VERSION}-${DINKY-VERSION}/deploy/kubernetes/helm/dinky

+```yaml

+image:

+ repository: "docker.dinky.org.cn:32451/dinky/dev/dinky-txh"

+ pullPolicy: "Always"

+ tag: "1.0.2"

+ pullSecret: ""

+```

+#### 内部数据源(同一个k8环境中部署mysql服务)

+修改values.yaml 为mysql数据源

+```yaml

+mysql:

+ enabled: true

+ url: "172.168.1.111:31476"

+ auth:

+ username: "dinky"

+ password: "bigdata123!@#"

+ database: "dinky-dev-1-17"

+```

+如果数据源为postgresql,则修改如下

+```yaml

+postgresql:

+ enabled: true

+ url: "172.168.1.111:31476"

+ auth:

+ username: "dinky"

+ password: "bigdata123!@#"

+ database: "dinky-dev-1-17"

+```

+修改flink版本,如下修改为1.17版本

+```yaml

+spec:

+ replicaCount: 1

+ containerPort: 8888

+ name: rest

+ extraEnv:

+ flinkVersion: "1.17"

+```

+例如,mysql数据源完整配置如下:

+完整配置如下:

+```yaml

+#

+# Licensed to the Apache Software Foundation (ASF) under one or more

+# contributor license agreements. See the NOTICE file distributed with

+# this work for additional information regarding copyright ownership.

+# The ASF licenses this file to You under the Apache License, Version 2.0

+# (the "License"); you may not use this file except in compliance with

+# the License. You may obtain a copy of the License at

+#

+# http://www.apache.org/licenses/LICENSE-2.0

+#

+# Unless required by applicable law or agreed to in writing, software

+# distributed under the License is distributed on an "AS IS" BASIS,

+# WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

+# See the License for the specific language governing permissions and

+# limitations under the License.

+#

+#

+

+timezone: "Asia/Shanghai"

+

+nameOverride: ""

+fullnameOverride: ""

+

+image:

+ repository: "docker.dinky.org.cn:32451/dinky/dev/dinky-txh"

+ pullPolicy: "Always"

+ tag: "1.0.2"

+ pullSecret: ""

+

+mysql:

+ enabled: true

+ url: "172.168.1.111:31476"

+ auth:

+ username: "dinky"

+ password: "bigdata123!@#"

+ database: "dinky-dev-1-17"

+

+postgresql:

+ enabled: false

+ url: "172.168.1.111:31476"

+ auth:

+ username: "dinky"

+ password: "bigdata123!@#"

+ database: "dinky-dev-1-17"

+

+externalDatabase:

+ enabled: false

+ type: "mysql"

+ url: "10.43.2.12:3306"

+ auth:

+ username: "root"

+ password: "Dinky@1234567!"

+ database: "dinky"

+

+externalDatabaseService:

+ clusterIP: 10.43.2.12

+ port: 3306

+

+externalDatabaseEndpoints:

+ ip: 172.168.1.110

+ port: 3306

+

+rbac:

+ create: true

+

+spec:

+ replicaCount: 1

+ containerPort: 8888

+ name: rest

+ extraEnv:

+ flinkVersion: "1.17"

+

+ affinity: {}

+ nodeSelector: {}

+ tolerations: []

+ resources: {}

+ # resources:

+ # limits:

+ # memory: "2Gi"

+ # cpu: "1"

+ # requests:

+ # memory: "1Gi"

+ # cpu: "500m"

+ livenessProbe:

+ enabled: true

+ initialDelaySeconds: "90"

+ periodSeconds: "30"

+ timeoutSeconds: "20"

+ failureThreshold: "3"

+ successThreshold: "1"

+

+ readinessProbe:

+ enabled: true

+ initialDelaySeconds: "90"

+ periodSeconds: "30"

+ timeoutSeconds: "20"

+ failureThreshold: "3"

+ successThreshold: "1"

+

+ingress:

+ enabled: false

+ className: ""

+ annotations: {}

+ # kubernetes.io/ingress.class: nginx

+ # kubernetes.io/tls-acme: "true"

+ hosts:

+ - host: demo.dinky.org.cn

+ paths:

+ - path: /

+ pathType: ImplementationSpecific

+ tls: []

+

+

+service:

+ ## type determines how the Service is exposed. Defaults to ClusterIP. Valid options are ExternalName, ClusterIP, NodePort, and LoadBalancer

+ type: "ClusterIP"

+ name: "dinky"

+

+dinkyDefaultConfiguration:

+ create: true

+ append: true

+

+dinkyServiceAccount:

+ create: true

+ annotations: {}

+ name: "dinky"

+```

+注意:数据源只能启用一个,不能同时启用mysql和postgresql

+

+#### 外部数据源

+修改k8s集群外mysql服务配置

+```yaml

+externalDatabaseEndpoints:

+ ip: 172.168.1.110

+ port: 3306

+```

+修改k8s集群内映射mysql服务配置

+```yaml

+externalDatabaseService:

+ clusterIP: 10.43.2.12

+ port: 3306

+```

+修改mysql服务配置

+```yaml

+externalDatabase:

+ enabled: true

+ type: "mysql"

+ url: "10.43.2.12:3306"

+ auth:

+ username: "root"

+ password: "Dinky@1234567!"

+ database: "dinky"

+```

+

+完整案例如下:

+```yaml

+#

+# Licensed to the Apache Software Foundation (ASF) under one or more

+# contributor license agreements. See the NOTICE file distributed with

+# this work for additional information regarding copyright ownership.

+# The ASF licenses this file to You under the Apache License, Version 2.0

+# (the "License"); you may not use this file except in compliance with

+# the License. You may obtain a copy of the License at

+#

+# http://www.apache.org/licenses/LICENSE-2.0

+#

+# Unless required by applicable law or agreed to in writing, software

+# distributed under the License is distributed on an "AS IS" BASIS,

+# WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

+# See the License for the specific language governing permissions and

+# limitations under the License.

+#

+#

+

+timezone: "Asia/Shanghai"

+

+nameOverride: ""

+fullnameOverride: ""

+

+image:

+ repository: "docker.dinky.org.cn:32451/dinky/dev/dinky-txh"

+ pullPolicy: "Always"

+ tag: "1.0.2"

+ pullSecret: ""

+

+mysql:

+ enabled: false

+ url: "172.168.1.111:31476"

+ auth:

+ username: "dinky"

+ password: "bigdata123!@#"

+ database: "dinky-dev-1-17"

+

+postgresql:

+ enabled: false

+ url: "172.168.1.111:31476"

+ auth:

+ username: "dinky"

+ password: "bigdata123!@#"

+ database: "dinky-dev-1-17"

+

+externalDatabase:

+ enabled: true

+ type: "mysql"

+ url: "10.43.2.12:3306"

+ auth:

+ username: "root"

+ password: "Dinky@1234567!"

+ database: "dinky"

+

+externalDatabaseService:

+ clusterIP: 10.43.2.12

+ port: 3306

+

+externalDatabaseEndpoints:

+ ip: 172.168.1.110

+ port: 3306

+

+rbac:

+ create: true

+

+spec:

+ replicaCount: 1

+ containerPort: 8888

+ name: rest

+ extraEnv:

+ flinkVersion: "1.17"

+

+ affinity: {}

+ nodeSelector: {}

+ tolerations: []

+ resources: {}

+ # resources:

+ # limits:

+ # memory: "2Gi"

+ # cpu: "1"

+ # requests:

+ # memory: "1Gi"

+ # cpu: "500m"

+ livenessProbe:

+ enabled: true

+ initialDelaySeconds: "90"

+ periodSeconds: "30"

+ timeoutSeconds: "20"

+ failureThreshold: "3"

+ successThreshold: "1"

+

+ readinessProbe:

+ enabled: true

+ initialDelaySeconds: "90"

+ periodSeconds: "30"

+ timeoutSeconds: "20"

+ failureThreshold: "3"

+ successThreshold: "1"

+

+ingress:

+ enabled: false

+ className: ""

+ annotations: {}

+ # kubernetes.io/ingress.class: nginx

+ # kubernetes.io/tls-acme: "true"

+ hosts:

+ - host: demo.dinky.org.cn

+ paths:

+ - path: /

+ pathType: ImplementationSpecific

+ tls: []

+

+

+service:

+ ## type determines how the Service is exposed. Defaults to ClusterIP. Valid options are ExternalName, ClusterIP, NodePort, and LoadBalancer

+ type: "ClusterIP"

+ name: "dinky"

+

+dinkyDefaultConfiguration:

+ create: true

+ append: true

+

+dinkyServiceAccount:

+ create: true

+ annotations: {}

+ name: "dinky"

+```

+

+### 部署

+将名为 dinky 的版本(release) 发布到 dinky 的命名空间中:

+```shell

+cd dinky-release-${FLINK-VERSION}-${DINKY-VERSION}/deploy/kubernetes/helm/dinky

+

+helm install dinky . -n dinky

+```

+

+### 卸载

+```shell

+cd dinky-release-${FLINK-VERSION}-${DINKY-VERSION}/deploy/kubernetes/helm/dinky

+

+helm uninstall dinky -n dinky

+```

+

+

+

+

+

diff --git a/docs/versioned_docs/version-1.0/deploy_guide/normal_deploy.mdx b/docs/versioned_docs/version-1.0/deploy_guide/normal_deploy.mdx

new file mode 100644

index 0000000000..8c004324fd

--- /dev/null

+++ b/docs/versioned_docs/version-1.0/deploy_guide/normal_deploy.mdx

@@ -0,0 +1,258 @@

+---

+sidebar_position: 1

+position: 1

+id: normal_deploy

+title: 常规部署

+---

+

+---

+

+## 数据库初始化

+

+Dinky 采用 mysql 作为后端的存储库,mysql 支持 5.7+。这里假设你已经安装了 mysql 。首先需要创建 Dinky 的后端数据库,这里以配置文件中默认库创建。

+

+在 Dinky 根目录 sql 文件夹下分别放置了 dinky-mysql.sql 、 upgrade/${version}_schema/mysql/ddl 和 dml。如果第一次部署,可以直接将 sql/dinky-mysql.sql 文件在 dinky 数据库下执行。(如果之前已经部署,那 upgrade 目录下存放了各版本的升级 sql ,根据版本号按需执行即可)

+

+

+

+

+```sql

+#登录mysql

+mysql -uroot -p

+#创建数据库

+mysql>

+create database dinky;

+#授权

+mysql>

+grant all privileges on dinky.* to 'dinky'@'%' identified by 'dinky' with grant option;

+mysql>

+flush privileges;

+#此处用 dinky 用户登录

+mysql -h fdw1 -udinky -pdinky

+```

+

+

+

+

+```sql

+#登录mysql

+mysql -uroot -p

+#创建数据库

+mysql>

+CREATE DATABASE dinky;

+#创建用户并允许远程登录

+mysql>

+create user 'dinky'@'%' IDENTIFIED WITH mysql_native_password by 'dinky';

+#授权

+mysql>

+grant ALL PRIVILEGES ON dinky.* to 'dinky'@'%';

+mysql>

+flush privileges;

+```

+

+

+

+

+

+#### 第一次部署

+

+```sql

+#首先登录 mysql

+mysql -h fdw1 -udinky -pdinky

+mysql> use dinky;

+mysql> source /opt/dinky/sql/dinky-mysql.sql

+```

+

+

+## Dinky 部署

+

+:::danger 注意事项

+

+自 Dinky v1.0.0 版本开始,Dinky 采用了新的打包部署方式, 提供了适配每个 Flink 版本的二进制包(tar.gz) ,需要根据 Flink 版本选择对应的 Dinky 版本,不再支持多个版本共存在单一二进制包内,请根据实际情况选择对应版本

+

+:::

+

+

+import Tabs from '@theme/Tabs';

+import TabItem from '@theme/TabItem';

+

+

+

+

+** 解压到指定目录 **

+

+```shell

+tar -zxf dinky-release-${flink.version}-${dinky.version}.tar.gz

+mv dinky-release-${flink.version}-${dinky.version} dinky

+cd dinky

+```

+

+

+

+

+

+### 配置文件

+

+创建好数据库后,修改 Dinky 配置文件,选择默认数据源为 mysql。

+

+```shell

+cd /opt/dinky/config/

+vim application.yml

+# 修改 Dinky 所使用的数据库类型为 mysql

+spring:

+ application:

+ name: Dinky

+ profiles:

+ # The h2 database is used by default. If you need to use other databases, please set the configuration active to: mysql, currently supports [mysql, pgsql, h2]

+ # If you use mysql database, please configure mysql database connection information in application-mysql.yml

+ # If you use pgsql database, please configure pgsql database connection information in application-pgsql.yml

+ # If you use the h2 database, please configure the h2 database connection information in application-h2.yml,

+ # note: the h2 database is only for experience use, and the related data that has been created cannot be migrated, please use it with caution

+ active: ${DB_ACTIVE:mysql} #[h2,mysql,pgsql]

+```

+

+修改 Dinky 的 mysql 的配置文件。

+

+```shell

+vim application-mysql.yml

+# 修改 Dinky 的 mysql 链接配置

+spring:

+ datasource:

+ url: jdbc:mysql://${MYSQL_ADDR:127.0.0.1:3306}/${MYSQL_DATABASE:dinky}?useUnicode=true&characterEncoding=UTF-8&autoReconnect=true&useSSL=false&zeroDateTimeBehavior=convertToNull&serverTimezone=Asia/Shanghai&allowPublicKeyRetrieval=true

+ username: ${MYSQL_USERNAME:dinky}

+ password: ${MYSQL_PASSWORD:dinky}

+ driver-class-name: com.mysql.cj.jdbc.Driver

+```

+

+### 上传依赖

+

+Dinky 需要具备内置的 Flink 环境,该 Flink 环境的实现需要用户自己在 Dinky 根目录下 extends/flink${FLINK_VERSION} 文件夹上传相关的 Flink 依赖,如 flink-dist, flink-table 等,具体见下文。当然也可在启动文件中指定 FLINK_HOME,但不建议这样做。

+

+:::warning 注意事项

+1. Dinky 并没有内置的 mysql/postgres 数据库驱动,需要用户自己上传 mysql-connector-java-xxx.jar/postgresql-xxx.jar 等jdbc 驱动到 `lib 下`或者`extends 下`

+2. Dinky 当前版本的 yarn 的 per-job 与 application 执行模式依赖 flink-shaded-hadoop ,需要额外添加 flink-shaded-hadoop-uber 包,如果您使用的是`flink-shaded-hadoop-uber-3`请手动删除该包内部的 javax.servlet 等冲突内容。

+当然如果你的 Hadoop 为 3+ 也可以自行编译对于版本的 dinky-client-hadoop.jar 以替代 uber 包,

+3. Dinky所有监控相关功能目前强依赖hadoop,即使你不需要任何hadoop功能,也需要上传flink-shaded-hadoop-uber,否则会导致监控功能无法正常使用

+:::

+

+将 flink-shaded-hadoop 上传到到 extends 文件目录下,使用 flink-shaded-hadoop-3 地址如下:

+

+```

+https://mvnrepository.com/artifact/org.apache.flink/flink-shaded-hadoop-3-uber?repo=cloudera-repos

+```

+

+如果是 CDH 及 HDP 使用开源 flink-shaded 对 Dinky 目前没有影响,其他用到的依赖取决于 CDH 或者 HDP 与开源版本的兼容性,需要自行根据兼容性添加依赖即可正常使用 Dinky 的所有功能。

+

+最终项目根目录如下,仅供参考:

+

+```

+├── auto.sh -- 启动停止脚本

+├── config -- 配置文件

+│ ├── jmx

+│ │ └── jmx_exporter_config.yaml -- JMX 监控集成

+│ ├── application.yml -- 主要程序运行配置文件

+│ ├── application-h2.yml -- h2 配置文件

+│ ├── application-jmx.yml -- jmx 配置文件

+│ ├── application-mysql.yml -- mysql 配置文件

+│ ├── application-pgsql.yml -- pgsql 配置文件

+│ ├── DinkyFlinkDockerfile -- k8s 集群配置自动构建镜像的Dockerfile

+│ └── log4j2.xml -- 日志配置

+├── dinky-loader

+│ ├── ExpressionVariableClass -- 全局变量动态加载的表达式扫描配置文件

+│ └── FlinkConfClass -- 全局变量动态加载 Flink 配置的扫描配置文件

+├── extends

+│ ├── flink1.14 -- 适配 Flink1.14.x

+│ │ └── dinky

+│ │ ├── dinky-catalog-mysql-1.14-${VERSION}.jar -- dinky 的 catalog 实现

+│ │ ├── dinky-client-1.14-${VERSION}.jar

+│ │ └── dinky-connector-jdbc-1.14-${VERSION}.jar -- dinky 的 jdbc 连接器增强实现

+│ ├── flink1.15 -- 适配 Flink1.15.x

+│ │ └── dinky

+│ │ ├── dinky-catalog-mysql-1.15-${VERSION}.jar -- dinky 的 catalog 实现

+│ │ └── dinky-client-1.15-${VERSION}.jar

+│ ├── flink1.16 -- 适配 Flink1.16.x

+│ │ └── dinky

+│ │ ├── dinky-catalog-mysql-1.16-${VERSION}.jar -- dinky 的 catalog 实现

+│ │ └── dinky-client-1.16-${VERSION}.jar

+│ ├── flink1.17 -- 适配 Flink1.17.x

+│ │ └── dinky

+│ │ ├── dinky-catalog-mysql-1.17-${VERSION}.jar -- dinky 的 catalog 实现

+│ │ └── dinky-client-1.17-${VERSION}.jar

+│ └── flink1.18 -- 适配 Flink1.18.x

+│ │ └── dinky

+│ │ ├── dinky-catalog-mysql-1.18-${VERSION}.jar -- dinky 的 catalog 实现

+│ │ └── dinky-client-1.18-${VERSION}.jar

+├── jar

+│ ├── dinky-app-1.14-${VERSION}-jar-with-dependencies.jar -- 适配 Flink1.14.x application

+│ ├── dinky-app-1.15-${VERSION}-jar-with-dependencies.jar -- 适配 Flink1.15.x application

+│ ├── dinky-app-1.16-${VERSION}-jar-with-dependencies.jar -- 适配 Flink1.16.x application

+│ ├── dinky-app-1.17-${VERSION}-jar-with-dependencies.jar -- 适配 Flink1.17.x application

+│ └── dinky-app-1.18-${VERSION}-jar-with-dependencies.jar -- 适配 Flink1.18.x application

+├── lib

+│ └── ... -- Dinky 的内部依赖

+└── sql

+ ├── dinky-mysql.sql -- Mysql 首次初始化脚本

+ ├── dinky-pg.sql -- PGSql 首次初始化脚本

+ └── upgrade -- 各个版本的升级 SQL

+```

+对应 `Flink` 版本的依赖,放在Dinky 安装目录下 extends/flink${FLINK_VERSION} 下,例如:

+```shell

+flink-cep-1.16.1.jar

+flink-connector-files-1.16.1.jar

+flink-connector-jdbc-1.16.1.jar

+flink-csv-1.16.1.jar

+flink-dist-1.16.1.jar

+flink-json-1.16.1.jar

+flink-scala_2.12-1.16.1.jar

+flink-shaded-hadoop-2-uber-2.7.5-8.0.jar

+flink-shaded-zookeeper-3.5.9.jar

+flink-table-api-java-uber-1.16.1.jar

+# !!!特别注意,flink自带lib里的planner是带loader的,比如:flink-table-planner-loader-1.16.1.jar,

+# 需要删除带loader的jar包,换一个不带loader的jar, 可前往flink根下的opt目录中找到

+# 对于standalone,hdfs,k8s等集群上的flink集群同样要做此操作

+flink-table-planner_2.12-1.16.1.jar

+

+flink-table-runtime-1.16.1.jar

+log4j-1.2-api-2.17.1.jar

+log4j-api-2.17.1.jar

+log4j-core-2.17.1.jar

+log4j-slf4j-impl-2.17.1.jar

+```

+:::tip

+1.0.0 之前的版本 Flink 相关依赖是放在 plugins 目录下,1.0.0 及之后是放在 extends 目录下。

+

+推荐公共 jar 包放在 extends 目录下,Flink 版本的依赖放在 extends/flink${FLINK_VERSION} 下

+:::

+

+### 启动 Dinky

+

+```shell

+#启动

+sh auto.sh start

+#停止

+sh auto.sh stop

+#重启

+sh auto.sh restart

+#查看状态

+sh auto.sh status

+

+# 前台启动(调试使用,会输出日志,阻塞当前终端,结束请Ctrl+C,但是会直接退出服务,仅供启动时无日志输出且在排查问题时使用)

+sh auto.sh startOnPending

+

+```

+

+#### 版本适配

+启动指令的第二个参数则是版本选择,支持 【1.14, 1.15, 1.16, 1.17, 1.18, 1.19】,参考指令如下:

+> 自 1.0.2 版本开始加入了自动检测 Flink 版本的功能,如果不传入版本号,则会自动检测 Flink 版本作为启动版本(即检测 extends 目录下的 flink${FLINK_VERSION} 文件夹)

+```shell

+#启动

+sh auto.sh start 1.16

+```

+

+:::tip 说明

+服务启动后,默认端口 8888,[http://127.0.0.1:8888](http://127.0.0.1:8888) , 默认用户名/密码: admin/dinky123!@# ,如需修改,请使用默认用户名/密码登录后,在`认证中心`->`用户`中修改

+

+Dinky 部署需要 MySQL5.7 以上版本

+

+:::

+

diff --git a/docs/versioned_docs/version-1.0/deploy_guide/upgrade/_category_.json b/docs/versioned_docs/version-1.0/deploy_guide/upgrade/_category_.json

new file mode 100644

index 0000000000..b65f1a32d6

--- /dev/null

+++ b/docs/versioned_docs/version-1.0/deploy_guide/upgrade/_category_.json

@@ -0,0 +1,4 @@

+{

+ "label": "upgrade",

+ "position": 4

+}

diff --git a/docs/versioned_docs/version-1.0/deploy_guide/upgrade/upgrade_075to100.md b/docs/versioned_docs/version-1.0/deploy_guide/upgrade/upgrade_075to100.md

new file mode 100644

index 0000000000..cc391c7ca5

--- /dev/null

+++ b/docs/versioned_docs/version-1.0/deploy_guide/upgrade/upgrade_075to100.md

@@ -0,0 +1,52 @@

+---

+sidebar_position: 4

+position: 4

+id: upgrade_075to100

+title: 0.7.5 升级到 1.0.0

+---

+

+

+:::warning 说明

+

+1. 本文档为 Dinky v1.0.0 版本升级文档, 适用于从 0.7.5 升级到 1.0.0 版本.

+2. 自 0.7.5 升级到 1.0.0 变化较大,存在部分不兼容变更,如果作业数量不多的情况下,建议重新建库部署,手动迁移任务.

+3. 如果作业数量较大,建议先进行备份,然后执行升级脚本.但是升级脚本无法完全平滑升级,可能会存在部分数据丢失的情况,请谨慎操作.

+4. 自 Dinky v1.0.0 之后, 默认密码为: dinky123!@#

+

+:::

+

+## 备份数据

+

+> 自行备份数据,以防升级失败,导致数据丢失.

+

+## 升级 SQL

+

+### 使用升级脚本

+

+```shell

+# 假设你的 Dinky 部署在 /opt/dinky 目录下

+

+# 登录到数据库,用户名和密码请自行修改

+mysql -uroot -p123455

+

+# 切换到 dinky 数据库

+use dinky

+

+# 导入升级脚本 请注意: 先执行 ddl.sql,再执行 dml.sql

+source /opt/dinky/sql/upgrade/1.0.0_schema/mysql/dinky_ddl.sql

+source /opt/dinky/sql/upgrade/1.0.0_schema/mysql/dinky_dml.sql

+

+# 升级完成后,请检查是否有错误信息,如果有错误信息,请根据错误信息进行处理

+

+# 退出数据库

+exit

+```

+

+### 使用数据库管理工具

+

+1. 打开数据库管理工具,如 Navicat 或者 MySQL Workbench,连接到数据库,用户名和密码请自行修改.

+2. 导入升级脚本,请注意: 先执行 ddl.sql,再执行 dml.sql.

+3. 升级完成后,请检查是否有错误信息,如果有错误信息,请根据错误信息进行处理.

+4. 退出数据库管理工具.

+

+> 如需手动 cv 执行, 请自行找到对应的 SQL 语句,复制到数据库管理工具中依次执行.

diff --git a/docs/versioned_docs/version-1.0/deploy_guide/upgrade/upgrade_overview.md b/docs/versioned_docs/version-1.0/deploy_guide/upgrade/upgrade_overview.md

new file mode 100644

index 0000000000..ceb49cb2c6

--- /dev/null

+++ b/docs/versioned_docs/version-1.0/deploy_guide/upgrade/upgrade_overview.md

@@ -0,0 +1,18 @@

+---

+sidebar_position: 1

+position: 1

+id: upgrade_overview

+title: 版本升级介绍

+---

+

+:::caution 注意

+1. 自 Dinky 0.7.5 开始进行升级教程, 后续版本更新将在此文档及子文档中进行更新。

+2. 所有版本的升级 SQL 在部署目录下的 sql/upgrade 目录下, 升级 SQL 按照版本号进行排序, 升级 SQL 目录命名规则为 0.7.5_schema/mysql

+3. 自 Dinky v1.0.0 开始支持 PostgreSQL,作为后端数据存储库实现, 升级 SQL 目录命名规则为 1.0.0_schema/postgresql

+4. 注意: Dinky v1.0.0 刚支持 PostgreSQL,此数据库类型不存在升级脚本,直接执行`sql/dinky-pg.sql`即可)

+5. 升级时请注意,先执行 `{version}_schema/mysql`/`{version}_schema/postgresql` 下的 `dinky_ddl.sql`,再执行 `{version}_schema/mysql`/`{version}_schema/postgresql` 下的 `dinky_dml.sql`

+:::

+

+### 版本升级列表

+

+- [0.7.5 升级到 1.0.0](upgrade_075to100)

\ No newline at end of file

diff --git a/docs/versioned_docs/version-1.0/developer_guide/_category_.json b/docs/versioned_docs/version-1.0/developer_guide/_category_.json

new file mode 100644

index 0000000000..1ae7ef1a79

--- /dev/null

+++ b/docs/versioned_docs/version-1.0/developer_guide/_category_.json

@@ -0,0 +1,4 @@

+{

+ "label": "developer_guide",

+ "position": 12

+}

diff --git a/docs/versioned_docs/version-1.0/developer_guide/contribution/_category_.json b/docs/versioned_docs/version-1.0/developer_guide/contribution/_category_.json

new file mode 100644

index 0000000000..5eb8872202

--- /dev/null

+++ b/docs/versioned_docs/version-1.0/developer_guide/contribution/_category_.json

@@ -0,0 +1,4 @@

+{

+ "label": "contribution",

+ "position": 1

+}

diff --git a/docs/versioned_docs/version-1.0/developer_guide/contribution/auto_sync.md b/docs/versioned_docs/version-1.0/developer_guide/contribution/auto_sync.md

new file mode 100644

index 0000000000..e80dfb5e00

--- /dev/null

+++ b/docs/versioned_docs/version-1.0/developer_guide/contribution/auto_sync.md

@@ -0,0 +1,19 @@

+---

+sidebar_position: 105

+position: 105

+id: auto_sync

+title: 自动同步主仓库

+---

+

+

+

+:::info 简介

+ 自动同步主仓库 (upstream) 的代码到你的仓库 (origin),保持你的仓库代码与主仓库代码同步。

+:::

+

+## 步骤

+

+1. Fork 主仓库到你的 GitHub 账号下.

+2. 点击 Fork 之后的仓库, 点击 `Actions` 标签.

+3. 会提示一些介绍, 点击 `I understand my workflows, go ahead and enable them` 按钮.

+4. 完成之后,会在每天的 00:00:00 执行同步操作. 后续该 workflow 文件不改变的情况下,会一直按照定时配置自动执行同步操作.

diff --git a/docs/versioned_docs/version-1.0/developer_guide/contribution/code_format.md b/docs/versioned_docs/version-1.0/developer_guide/contribution/code_format.md

new file mode 100644

index 0000000000..a1118e9115

--- /dev/null

+++ b/docs/versioned_docs/version-1.0/developer_guide/contribution/code_format.md

@@ -0,0 +1,66 @@

+---

+sidebar_position: 111

+position: 111

+id: code_format

+title: 代码格式化

+---

+

+:::info 简介

+

+如果你在 Dinky 基础上进行了二次开发/bugfix/实现了新功能,并打算贡献到社区,基于代码格式化要求,你必须执行格式化代码,满足规范后方可被合并.

+

+但是在 Dinky 1.0.0 之后,格式化插件升级后要求 JDK 环境为 JDK 11,如果你的 JDK 环境为 JDK 8,那么则需要升级 JDK 环境/配置服务端格式化,否则无法使用格式化插件.你的 Pull Request 的代码检查结果将会失败,从而无法被合并

+

+基于上述说明,下面介绍多种方式,如何执行格式化并满足格式化要求.

+:::

+

+## 升级 JDK 环境

+

+> 此为单个 JDK 环境的升级

+

+Dinky 1.0.0 之后,全面支持 JDK 11,如果你的 JDK 环境为 JDK 8,那么可以选择升级 JDK 环境,具体 JDK11 的安装方式自行搜索即可.

+

+## JDK 环境并存

+

+如果你需要有多个 JDK 环境,那么你可以通过以下方式来实现 JDK 环境并存:

+

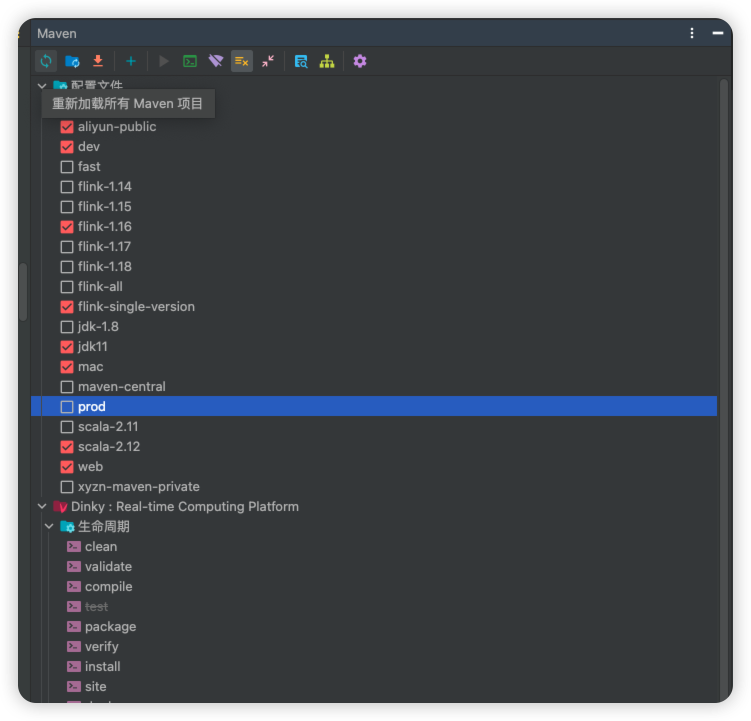

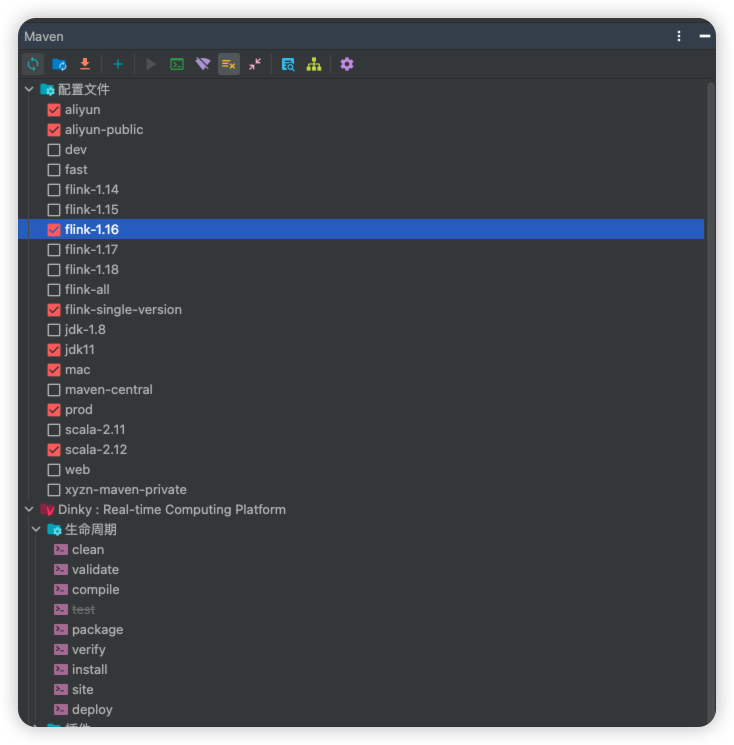

+1. 下载 JDK 11 并安装.不需要配置环境变量,只需要在 IDEA 中配置即可.前提是你所需的 JDK 主版本非 JDK11, 如果你想要设置 JDK 11 为默认,那么可以自行配置环境变量.

+2. 在 IDEA 打开的 Dinky 工程中配置 JDK 11,并勾选 Maven Profile 中的 `jdk11`,并刷新 Maven Profile,使其重新加载.

+3. 找到 Maven => Dinky 根下的 插件 => 展开 spotless, 双击 spotless:apply ,等待格式化完成.

+

+## 服务端格式化

+

+如果你只需要单个 JDK 环境,并且本地的 JDK 环境版本为 JDK 8, 不想升级 JDK 环境,那么你可以通过以下方式来实现:

+

+> 注意: 此操作需要在你提交本地代码到你的仓库前进行.

+

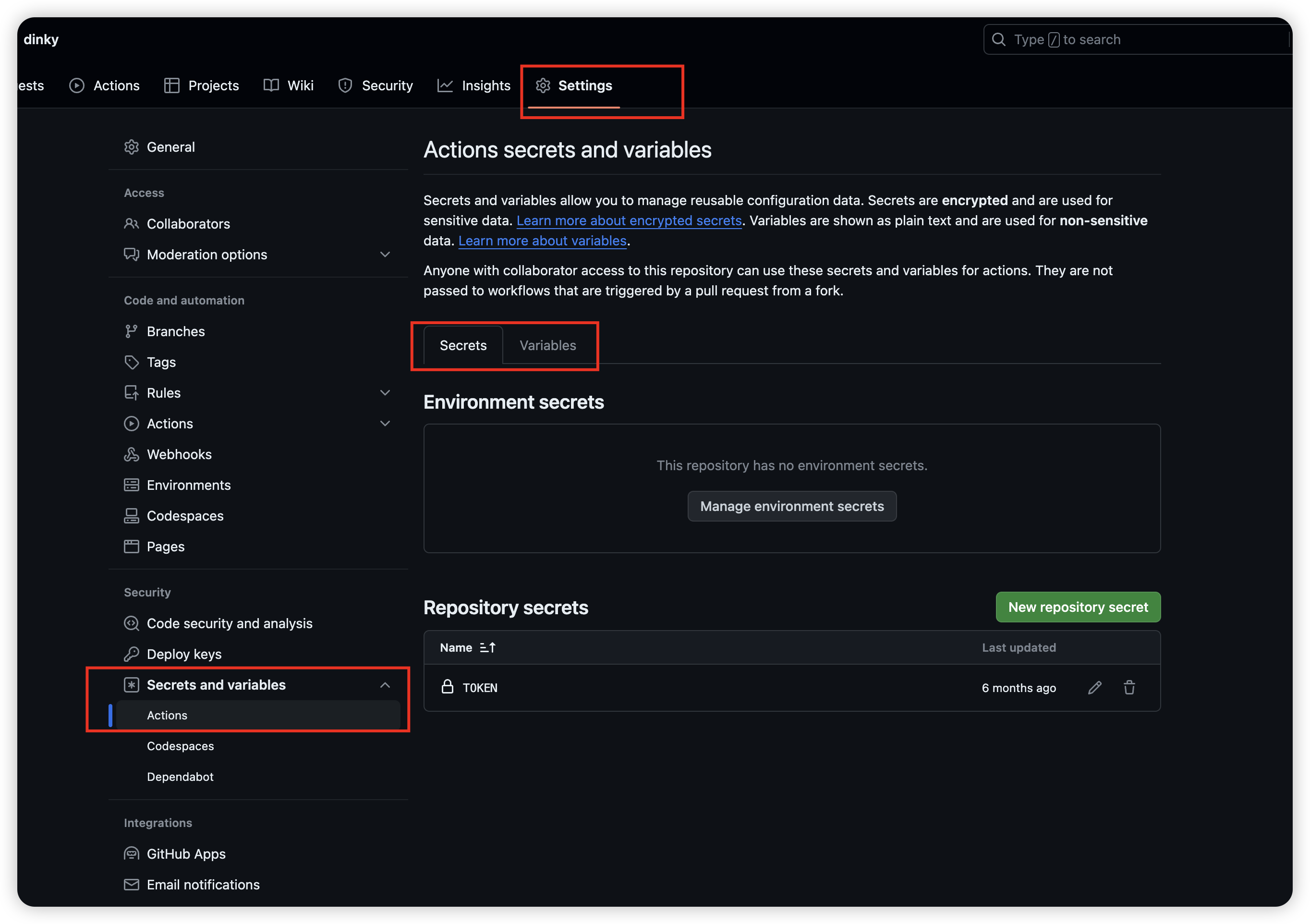

+1. 登录你的 GitHub 账号,转到 https://github.com/settings/tokens

+2. 点击下图路径, 创建 token,并指定名称为 `FORMAT`,请注意大小写,创建完成之后请牢记该 Token 值, 后续将会用到

+

+3. 打开你的 GitHub 中 Fork 的 Dinky 仓库 -> Settings -> Secrets and variables -> Actions

+

+4. 点击 Secrets Tag -> New repository secret -> 名称指定为 `TOKEN` , 粘贴你在第一步中创建的 token 值, 点击 Add secret

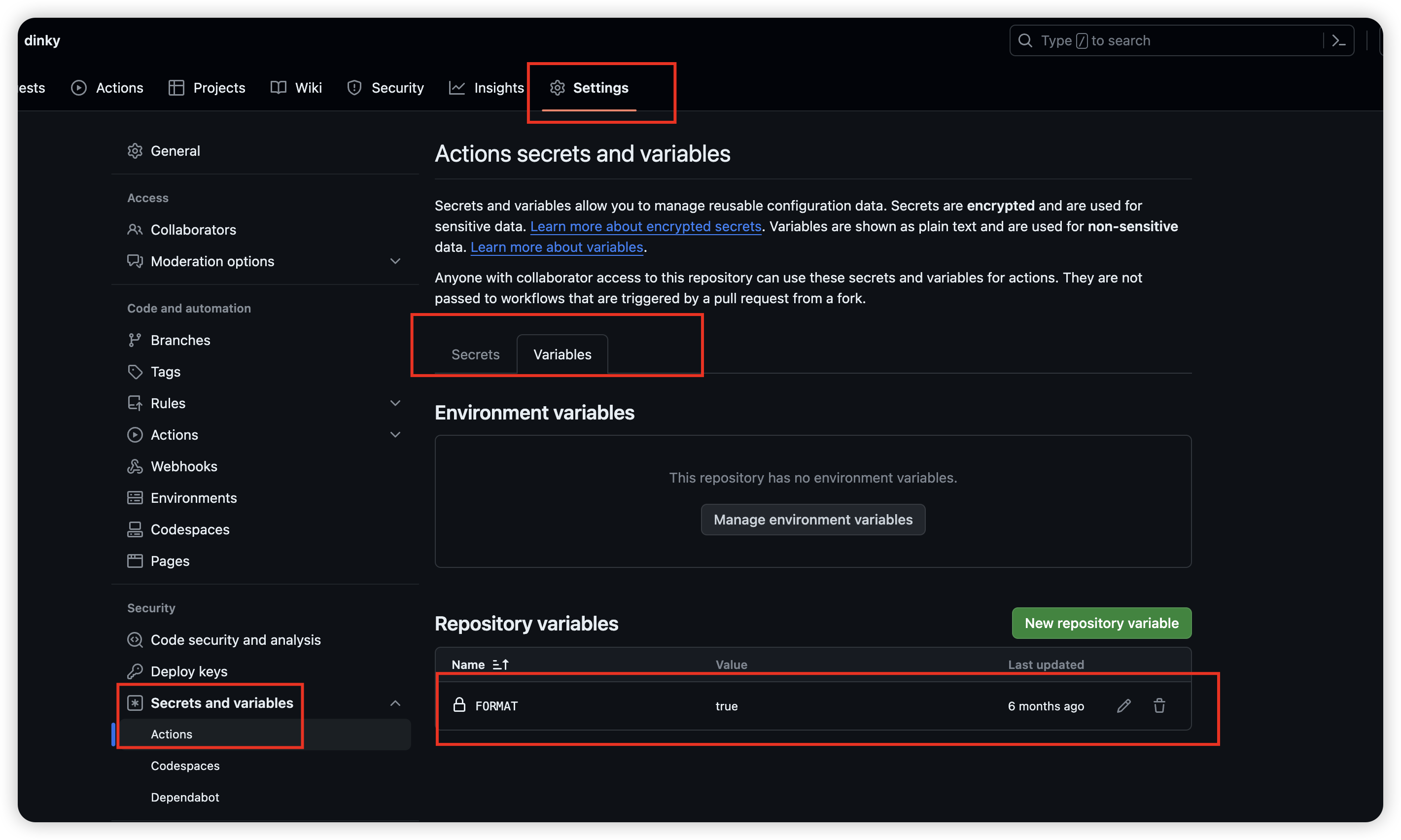

+5. 点击 Variables -> New repository variable -> 名称指定为 `FORMAT` , 值为`true`, 点击 Add variable

+

+

+6. 基于此方式,可以一劳永逸,无需在 IDEA 中手动执行格式化,并无需安装 JDK 11 环境. 只需要正常修改/新增代码 -> 提交到你的 Dinky 仓库即可,服务端会自动执行格式化,并将结果反馈在 下图所示的 Actions 界面中.

+

+此方式使用 GITHUB 的 Actions 服务,每次提交代码都会触发 Actions 服务,并执行格式化,如果格式化失败,则会反馈失败信息,如果格式化成功,则会反馈成功信息.

+

+

+## 前端格式化

+> 由于在 Dinky 1.0.0 之后,前端代码也需要进行格式化,但是在 本地只能通过手动执行格式化的方式来实现,所以在此提供一种方案,进行前端代码格式化. 如果配置了服务端格式化,那么可以忽略此步骤.由 GITHUB Actions 服务来执行格式化.

+

+步骤:

+1. 进入 dinky-web 目录,执行 `npm install -f` 安装依赖

+2. 执行 `npm run prettier` 进行格式化.

+

+

+:::tip 提示

+

+以上为几种如何实现格式化的方案, 请根据你的实际情况选择合适的方式.推荐使用 [服务端格式化](#服务端格式化) 的方式,因为它更加方便,而且不会影响你的本地环境.

+

+如果你在提交没有进行代码格式化且没有配置服务端格式化, 那么你的 Pull Request 将 actions 失败,并提示你进行格式化.如果你的 JDK 环境为 JDK 8,那么你需要升级 JDK 环境或者配置服务端格式化,否则无法通过格式化检查.

+如果 JDK 环境为 JDK 11,那么你可以在 IDEA 中配置 JDK 11,并勾选 Maven Profile 中的 `jdk11`,并刷新 Maven Profile,使其重新加载,然后再修改的类中再次回车触发修改,使该文件处于变更列表内,然后执行格式化即可.最后再进行提交.

+

+:::

\ No newline at end of file

diff --git a/docs/versioned_docs/version-1.0/developer_guide/contribution/commit_code.md b/docs/versioned_docs/version-1.0/developer_guide/contribution/commit_code.md

new file mode 100644

index 0000000000..e0ae0f49ba

--- /dev/null

+++ b/docs/versioned_docs/version-1.0/developer_guide/contribution/commit_code.md

@@ -0,0 +1,86 @@

+---

+sidebar_position: 108

+position: 108

+id: commit_code

+title: 提交代码须知

+---

+

+

+

+# 提交代码

+

+* 首先从远端仓库 *https://github.com/DataLinkDC/dinky.git* fork 一份代码到自己的仓库中

+

+* 远端仓库中分支:

+ * dev 日常开发分支: 日常 dev 开发分支,新提交的代码都可以 pull request 到这个分支上。

+ * 0.7.x 发布版本分支: 0.7.x 发布版本分支,目前仅接受 bugfix

+ * 1.x.x 发布版本分支

+

+* 把自己仓库 clone 到本地

+

+ ```sh

+ git clone https://github.com/DataLinkDC/dinky.git

+ ```

+

+* 添加远端仓库地址,命名为 upstream

+

+ ```sh

+ git remote add upstream https://github.com/DataLinkDC/dinky.git

+ ```

+

+

+

+* 查看仓库

+

+ ```sh

+ git remote -v

+ ```

+

+> 此时会有两个仓库:origin(自己的仓库)和 upstream(远端仓库)

+

+* 获取/更新远端仓库代码(已经是最新代码,就跳过)

+

+ ```sh

+ git fetch upstream

+ ```

+

+

+* 同步远端仓库代码到本地仓库

+

+ ```sh

+ git checkout origin/dev

+ git merge --no-ff upstream/dev

+ ```

+

+如果远端分支有新加的分支比如`dev-1.0`,需要同步这个分支到本地仓库

+

+ ```sh

+ git checkout -b dev-1.0 upstream/dev-1.0

+ git push --set-upstream origin dev-1.0

+ ```

+

+* 新建分支

+

+ ```sh

+ git checkout -b xxx origin/dev

+ ```

+

+确保分支 `xxx` 是基于官方 dev 分支的最新代码

+

+

+* 在新建的分支上本地修改代码以后,提交到自己仓库:

+

+ ```sh

+ git commit -m 'commit content'

+ git push origin xxx --set-upstream

+ ```

+

+* 将修改提交到远端仓库

+

+ * 在 github 的 Pull Request 页面,点击 "New pull request"

+

+ * 选择修改完的本地分支和要合并的目的分支,点击 "Create pull request"

+

+* 接着社区 Committer 们会做 CodeReview,然后他会与您讨论一些细节(包括设计,实现,性能等)。当团队中所有人员对本次修改满意后,会将提交合并到 dev 分支

+

+* 最后,恭喜您已经成为了 Dinky 的官方贡献者!

\ No newline at end of file

diff --git a/docs/versioned_docs/version-1.0/developer_guide/contribution/commit_message.md b/docs/versioned_docs/version-1.0/developer_guide/contribution/commit_message.md

new file mode 100644

index 0000000000..ae0fffd0dd

--- /dev/null

+++ b/docs/versioned_docs/version-1.0/developer_guide/contribution/commit_message.md

@@ -0,0 +1,97 @@

+---

+sidebar_position: 109

+position: 109

+id: commit_message

+title: Commit Message 须知

+---

+

+

+一个好的 commit message 是能够帮助其他的开发者(或者未来的开发者)快速理解相关变更的上下文,同时也可以帮助项目管理人员确定该提交是否适合包含在发行版中。但当我们在查看了很多开源项目的 commit log 后,发现一个有趣的问题,一部分开发者,代码质量很不错,但是 commit message 记录却比较混乱,当其他贡献者或者学习者在查看代码的时候,并不能通过 commit log 很直观的了解

+该提交前后变更的目的,正如 Peter Hutterer 所言:Re-establishing the context of a piece of code is wasteful. We can’t avoid it completely, so our efforts should go to reducing it as much as possible. Commit messages can do exactly that and as a result, a commit message shows whether a developer is a good collaborator. 因此,DolphinScheduler 结合其他社区以及 Apache 官方文档制定了该规约。

+

+### Commit Message RIP

+

+#### 1:明确修改内容

+

+commit message 应该明确说明该提交解决了哪些问题(bug 修复、功能增强等),以便于用户开发者更好的跟踪问题,明确版本迭代过程中的优化情况。

+

+#### 2:关联相应的Pull Request 或者Issue

+

+当我们的改动较大的时候,commit message 最好能够关联 GitHub 上的相关 Issue 或者 Pull Request,这样,我们的开发者在查阅代码的时候能够通过关联信息较为迅速的了解改代码提交的上下文情景,如果当前 commit 针对某个 issue,那么可以在 Footer 部分关闭这个 issue。

+

+#### 3:统一的格式

+

+格式化后的 CommitMessage 能够帮助我们提供更多的历史信息,方便快速浏览,同时也可以直接从 commit 生成 Change Log。

+

+Commit message 应该包括三个部分:Header,Body 和 Footer。其中,Header 是必需的,Body 和 Footer 可以省略。

+

+##### header

+